更新日志

内容

更新日志¶

2024.9.0¶

亮点¶

将 Bokeh 最低版本提升至 3.1.0¶

bokeh>=3.1.0 现在是为诊断和分布式集群仪表板所必需的。

更多详情请参见 James Bourbeau 的 GH#11375 和 GH#8861。

介绍新的 Task 类¶

添加一个 Task 类来替代用于任务规范的元组。

详情请参阅 Florian Jetter 的 GH#11248。

其他更改

将

peter-evans/create-pull-request从 6 升级到 7 (GH#11380)减少 tokenize 的开销 (GH#11373) Florian Jetter

将

tokenize移动到专用子模块 (GH#11371) Florian Jetter确保

process_runnables在存在多个分割时不至于过于急切 (GH#11367) Florian Jetter在shuffle中使用

np.min_scalar_type(GH#11369) James Bourbeau将索引数组写入dask图以减少多个xarray变量的大小(GH#11362) Patrick Hoefler

在洗牌中将索引器转换为最小的

dtype(GH#11364) Patrick Hoefler减少

dask.order的内存使用 (GH#11361) Florian Jetter将

JamesIves/github-pages-deploy-action从 4.6.3 升级到 4.6.4 (GH#11366)precommit自动更新 (GH#11360) Florian Jetter均匀调度 P2P 的解包任务 (GH#8873) Hendrik Makait

为本地主机工作/修复防火墙 (GH#8868) Mario Linker

使用新的

tokenize模块 (GH#8858) James Bourbeau使用幂等插件警告指向用户代码 (GH#8856) James Bourbeau

修复测试保姆超时 (GH#8847) Florian Jetter

将 JamesIves/github-pages-deploy-action 从 4.5.0 升级到 4.6.4 (GH#8853)

通过仅对

func和kwargs计算一次token来加速Client.map(GH#8855) Florian Jetter更新

pre-commit(GH#8852) Florian Jetter

2024.8.2¶

亮点¶

自动选择重新分块方法¶

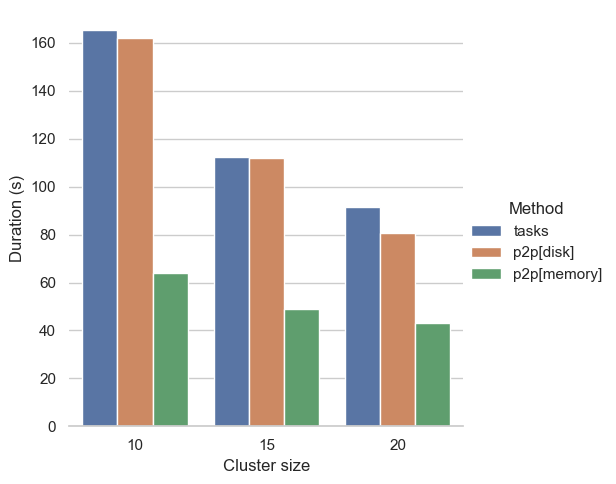

为了使用户能够在比以前更大的规模上重新分块数据,Dask 现在在集群上重新分块时会自动选择适当的重新分块方法。这不需要额外的配置,并且默认启用。

具体来说,Dask 在基于任务和点对点(P2P)重新分块之间进行选择。虽然基于任务的重新分块一直是之前的默认选项,但当重新分块需要旧块和新块之间的几乎所有对所有通信时,P2P 重新分块是有益的,例如在空间和时间分块之间切换时。在这些情况下,P2P 重新分块提供恒定的内存使用,并创建更小的任务图。因此,它适用于基于任务的重新分块之前会失败的场景。

要禁用自动选择,用户可以通过配置选择他们偏好的方法。

import dask.config

# Choose either "tasks" or "p2p"

dask.config.set({"array.rechunk.method": "tasks"})

或在重新分块时

import dask.array as da

arr = da.random.random(size=(1000, 1000, 365), chunks=(-1, -1, "auto"))

# Choose either "tasks" or "p2p"

arr = arr.rechunk(("auto", "auto", -1), method="tasks")

更多详情请参见 Hendrik Makait 的 GH#11337。

Dask 数组的新洗牌 API¶

Dask 为 Dask Arrays 添加了一个 shuffle-API。此 API 允许沿单个维度对数据进行洗牌。它将确保沿此维度的每个元素组都恰好在一个块中。这对于 Xarray 中的 GroupBy-Map 模式是一个非常有用的操作。更多信息和 API 签名请参见 shuffle()。

更多详情请参见 GH#11267, GH#11311 和 GH#11326,由 Patrick Hoefler 提供。

Dask 数组的新的 blockwise_reshape API¶

新的 blockwise_reshape() 为那些不关心底层数组顺序的情况启用了令人尴尬的并行重塑操作。它是令人尴尬的并行,并且不再在底层触发重新分块操作。当你不关心结果数组的顺序时,这很有用,例如,如果对数组应用了归约操作,或者重塑只是暂时的。

arr = da.random.random(size=(100, 100, 48_000), chunks=(1000, 100, 83)

result = reshape_blockwise(arr, (10_000, 48_000))

result.sum()

# or: do something that preserves the shape of each chunk

result = reshape_blockwise(result, (100, 100, 48_000), chunks=arr.chunks)

如果维度数量减少,Dask 会自动计算结果块,但如果维度数量增加,则必须指定结果块。

重塑 Dask 数组通常会在中间进行重新分块操作,从而创建非常复杂的计算,因为 Dask 默认尊重数组的 C 顺序。这确保了生成的 Dask 数组与相应的 NumPy 数组顺序相同。然而,这可能导致非常低效的计算。如果你不关心顺序,blockwise_reshape 比默认实现要高效得多。

警告

块状重塑操作作为默认设置更高效,但它们将返回一个顺序不同的数组。请谨慎使用!

更多详情请参见 GH#11328 由 Patrick Hoefler 提供。

多维位置索引保持块大小一致¶

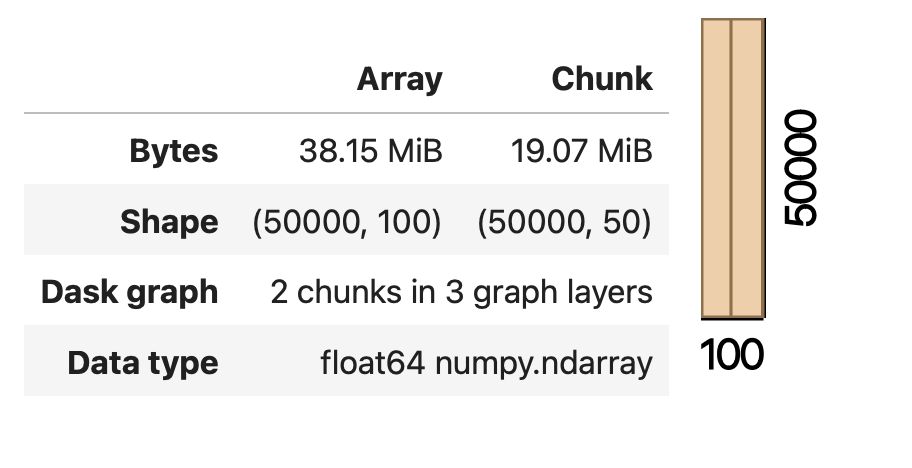

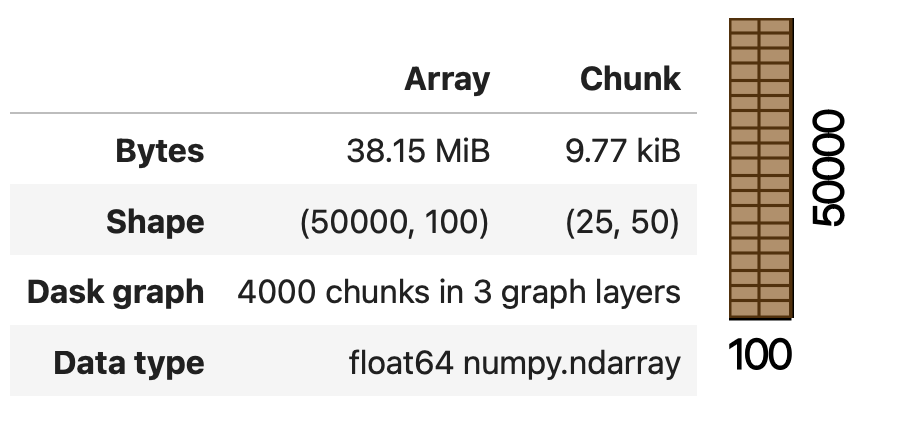

使用 vindex() 对 Dask 数组进行索引时,以前会在被索引的维度上创建一个单一的输出块。vindex 通常在 Xarray 中用于在单一步骤中索引多个维度,即:

arr = xr.DataArray(

da.random.random((100, 100, 100), chunks=(5, 5, 50)),

dims=['a', "b", "c"],

)

之前,这会将索引维度放入单个块中:

Dask 现在使用了一种改进的算法,确保块大小保持一致:

更多详情请参见 Patrick Hoefler 的 GH#11330。

其他更改

为 shuffle、

vindex和blockwise_reshape添加变更日志条目 (GH#11350) Patrick Hoefler确保持久化集合在无GC情况下释放 (GH#11348) Florian Jetter

更新dask会议的zoom链接 (GH#11357) Sarah Charlotte Johnson

在基于任务和点对点重新分块之间自动选择 (GH#11337) Hendrik Makait

为数组实现块状重塑API (GH#11328) Patrick Hoefler

使洗牌中的重新分块更加智能,必要时可以不均匀分布 (GH#11326) Patrick Hoefler

增加 GPU CI 更新的可见性 (GH#11345) Charles Blackmon-Luca

在安装文档中更新

numpy和pyarrow版本 (GH#11340) James Bourbeau修复 dask 和 distributed 依赖 (GH#11338) Patrick Hoefler

将

numpy>=1.24和pyarrow>=14.0.1的最低版本提升 (GH#11331) James Bourbeau将

crick添加回 Python 3.11+ CI 构建 (GH#11335) James Bourbeau在

vindex中保留 chunksizes (GH#11330) Patrick Hoefler修复

dask.array.fft与 Numpy 接口的不匹配问题(添加对 norm 参数的支持) (GH#10665) joanrue向

rechunk_p2p传递额外参数 (GH#11319) Hendrik Makait修复在2.0版本中``prod``对NumPy溢出的问题 (GH#11327) Patrick Hoefler

修复

map_overlap与new_axis(GH#11128) David Stansby避免捕获

xdist的代码(GH#8846)`Florian Jetter`_减少P2P重新分块的内存占用 (GH#8845) Hendrik Makait

为选择默认的重新分块方法添加测试 (GH#8843) Hendrik Makait

增加 GPU CI 更新的可见性 (GH#8841) Charles Blackmon-Luca

增加

test_pause_while_idle的超时时间 (GH#8844) Florian Jetter在P2P重新分块之前连接小的输入块 (GH#8832) Hendrik Makait

从

gen_cluster中移除 dump 集群 (GH#8823) Florian Jetter将

numpy>=1.24和pyarrow>=14.0.1的最低版本提升 (GH#8837) James Bourbeau修复

Worker上的PipInstall插件 (GH#8839) Hendrik Makait移除更多 Python 3.10 兼容性代码 (GH#8824) James Bourbeau

使用基于任务的重新分块来沿部分边界预分块 (GH#8831) Hendrik Makait

确保

client_desires_keys不会破坏Scheduler状态 (GH#8827) Florian Jetter将最小

cloudpickle版本提升至 3 (GH#8836) James Bourbeau

2024.8.1¶

亮点¶

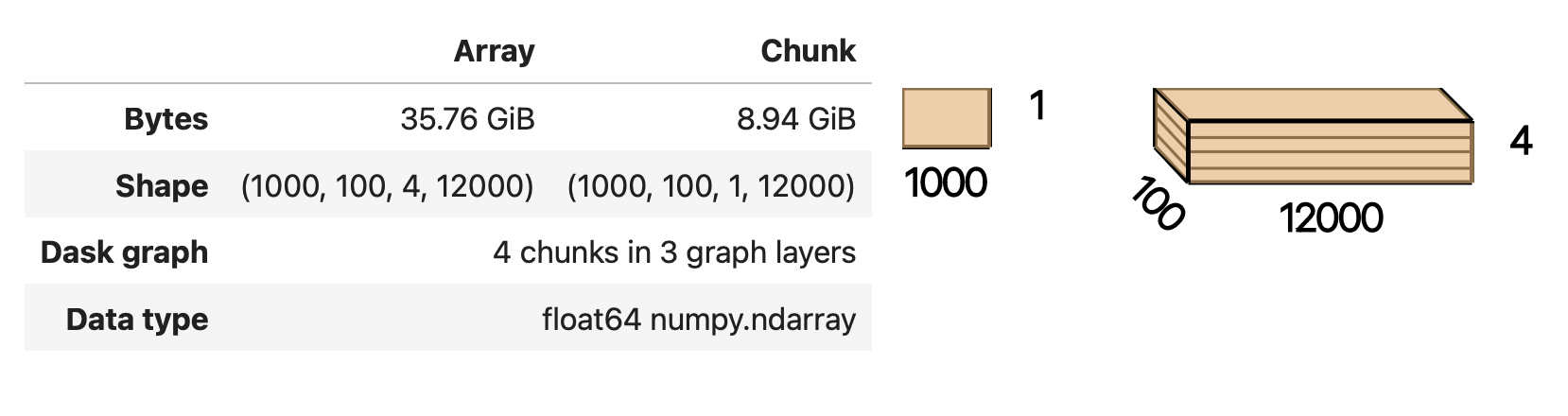

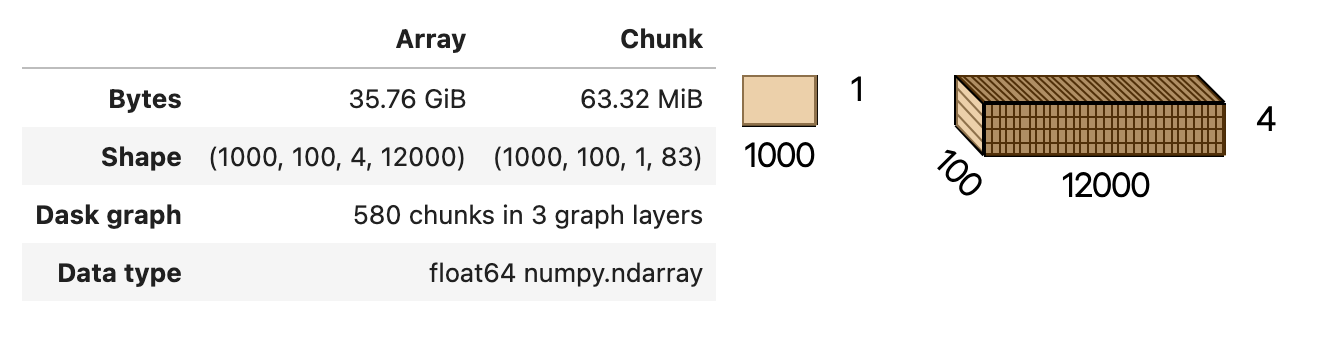

改进重塑Dask数组的输出块大小¶

重塑 Dask 数组时,通常会将维度压缩成一个单一的分块。这导致了非常大的输出分块,随后引发了许多内存溢出错误和性能问题。

arr = da.ones(shape=(1000, 100, 48_000), chunks=(1000, 100, 83))

arr.reshape(1000, 100, 4, 12_000)

之前,这会将最后一个维度放入一个大小为12,000的单个块中。

新算法将确保输入和输出之间的块大小保持一致。这将避免块大小的急剧增加和块的碎片化。

提高Xarray Rechunk-GroupBy-Reduce模式的调度效率¶

调度器之前为使用群体策略的 Xarray GroupBy-Reduction 模式创建了一个低效的执行图:

import xarray as xr

arr = xr.open_zarr(...)

arr.chunk(time=TimeResampler("ME")).groupby("time.month").mean()

任务图执行顺序算法中的一个问题导致了一种效率低下的执行策略,该策略在集群上积累了大量不必要的内存。改进与 2024.08.0 中的先前排序改进 非常相似。

放弃对 Python 3.9 的支持¶

此版本根据 NEP 29 放弃了对 Python 3.9 的支持。现在,运行 Dask 所需的最低版本是 Python 3.10。

更多详情请参见 GH#11245 和 GH#8793 由 Patrick Hoefler 提供。

其他更改

确保

pickle不改变标记 (GH#11320) Florian Jetter为

reshape和排序改进添加变更日志条目 (GH#11324) Patrick Hoefler重命名

chunksize-tolerance选项 (GH#11317) Patrick Hoefler升级 gpuCI 并修复使用 “cupy” 后端时的 Dask Array 故障 (GH#11309) Richard (Rick) Zamora

为

shuffle实现自动重新分块 (GH#11311) Patrick Hoefler确保我们在CI中针对

numpy2 进行测试 (GH#11182) James Bourbeau恢复“在分布式调度器上测试排序 (GH#11310)” (GH#11321) Florian Jetter

在分布式调度器上测试排序 (GH#11310) Florian Jetter

添加测试以覆盖新

reshape实现 (GH#11313) 的更多情况 Patrick Hoefler顺序:为具有多个叶节点的分支选择更好的目标 (GH#11303) Patrick Hoefler

顺序:确保可运行的任务确实可运行 (GH#11305) Florian Jetter

修复上游

numpy构建 (GH#11304) Patrick Hoefler如果可能,使

shuffle成为无操作 (GH#11291) Patrick Hoefler在

reshape中保持chunksize一致 (GH#11273) Patrick Hoefler启用仅有一个未知块的切片 (GH#11301) Patrick Hoefler

在 Dask 文档中链接到

dask与spark的基准测试 (GH#11289) Sarah Charlotte Johnson修复掩码数组的切片问题 (GH#11300) Patrick Hoefler

数组:修复

asarray对于带有dtype的数组输入 (GH#11288) Lucas Colley将

numpy常量添加到数组 API (GH#11287) Lucas Colley忽略返回值的类型 (GH#11286) Patrick Hoefler

在重塑中移除自动调整大小 (GH#11269) Patrick Hoefler

API: 在

dask.array命名空间中暴露np数据类型 (GH#11178) Lucas Colley减少未管理内存使用警告的频率 (GH#8834) Patrick Hoefler

将 gpuCI

RAPIDS_VER更新为24.10(GH#8786)避免

Server._shift_counters()中的RuntimeError: dictionary changed size during iteration(GH#8828) Hendrik Makait改进调度器的并发关闭 (GH#8829) Hendrik Makait

次要:从P2P重新分块中的部分连接中提取截断逻辑 (GH#8826) Hendrik Makait

避免

remove_from_task_prefix_count的过度属性访问开销 (GH#8821) Florian Jetter如果验证被禁用,则避免键验证 (GH#8822) Florian Jetter

记录

worker_client事件 (GH#8819) James Bourbeau

2024.8.0¶

亮点¶

通过位置索引器提高切片效率和性能¶

通过位置索引器对 Dask 数组进行切片时的性能改进。随机访问模式现在更加稳定,并产生更易于使用的输出结果。

x[slice(None), [1, 1, 3, 6, 3, 4, 5]]

使用位置索引器之前容易导致输出块的数量急剧增加,并生成非常大的任务图。这一问题已通过更高效的算法得到解决。

新的算法将保持沿被索引轴的块大小相同,以避免块的碎片化或块大小的显著增加。

更多详情和性能基准测试请参见 Patrick Hoefler 的 GH#11262 和 GH#11267。

提高 Xarray GroupBy-Reduce 模式的调度效率¶

调度器之前为 Xarray GroupBy-Reduction 模式创建了一个低效的执行图,例如:

import xarray as xr

arr = xr.open_zarr(...)

arr.groupby("time.month").mean()

任务图执行顺序算法中的一个问题导致了一种低效的执行策略,该策略在集群上积累了大量不必要的内存。

该操作本身是令人尴尬的并行。使用适当的执行策略,调度器现在可以以恒定的内存执行操作,避免溢出,并允许我们扩展到更大的数据集。

更多详情和示例请参见 Patrick Hoefler 的 GH#8818。

其他更改

为 dask 顺序补丁添加变更日志 (GH#11278) Patrick Hoefler

为

xarray映射减少添加回归测试 (GH#11277) Florian Jetter为

take添加变更日志条目 (GH#11274) Patrick Hoefler恢复“order: 移除数据任务图规范化” (GH#11276) Patrick Hoefler

使用 shuffle 算法进行

take(GH#11267) Patrick Hoefler实现基于任务的数组洗牌 (GH#11262) Patrick Hoefler

移除数据任务图规范化 (GH#11263) Florian Jetter

更新月度会议的Zoom链接 (GH#11265) Sarah Charlotte Johnson

更新最佳实践中的数据加载部分 (GH#11247) Patrick Hoefler

将文档字符串中的默认

chunksize匹配到代码中实际设置的默认值 (GH#11254) Bernhard Raml修复

pandas3 中的类型转换错误 (GH#11250) Patrick Hoefler跳过

pandas的新警告 (GH#11249) Patrick Hoefler修复

pandas的夜间构建错误 (GH#11244) Patrick Hoefler在 dask 顺序之后运行图规范化 (GH#8818) Patrick Hoefler

更新大型图表尺寸警告以移除散点图推荐 (GH#8815) Patrick Hoefler

失败超过

no-workers-timeout的任务 (GH#8806) Hendrik Makait修复

NannyPlugin.setup和NannyPlugin.teardown的异常处理 (GH#8811) Hendrik Makait修复

WorkerPlugin.setup和WorkerPlugin.teardown的异常处理 (GH#8810) Hendrik Makait拼写修正 (GH#8812) alex-rakowski

修复

send_recv_from_rpc的if/else(GH#8809) Patrick Hoefler确保自适应只停止一次 (GH#8807) Hendrik Makait

减少与GC相关的日志噪音 (GH#8804) Hendrik Makait

从

Scheduler中移除未使用的delete_interval和synchronize_worker_interval(GH#8801) Hendrik Makait更改计算失败日志消息的日志级别 (GH#8802) Patrick Hoefler

为GC花费的时间添加Prometheus指标 (GH#8803) Hendrik Makait

为

dask_worker_{added|removed}_total添加 Prometheus 指标 (GH#8798) Hendrik Makait为

worker-ttl-timed-out添加日志事件 (GH#8800) Hendrik Makait为

dask_client_connections_{added|removed}_total添加 Prometheus 指标 (GH#8799) Hendrik Makait修复

PackageInstall插件 (GH#8794) Hendrik Makait使盗窃更加稳健 (GH#8788) Hendrik Makait

留下关于未来实例化的警告 (GH#8782) Florian Jetter

2024年7月1日¶

亮点¶

更强大的分布式锁¶

distributed.Lock 现在能够抵御工作节点故障。以前,在持有锁的工作节点丢失或因错误未能释放锁的情况下,可能会发生死锁。

更多详情请参见 Florian Jetter 的 GH#8770。

其他更改

移除并警告持久使用 (GH#11237) Patrick Hoefler

在创建

meta时保留timestamp单位 (GH#11233) Patrick Hoefler确保

dask-exprDataFrame在放入delayed时得到优化(GH#11231) Patrick Hoefler修复

pandas=3中d频率弃用的问题 (GH#11228) James Bourbeau提高

test_quantile的近似阈值 (GH#10720) Florian Jetter将

xarray-contrib/issue-from-pytest-log从 1.2.8 升级到 1.3.0 (GH#11221)将

JamesIves/github-pages-deploy-action从 4.6.1 升级到 4.6.3 (GH#11222)确保

Lock始终向调度器注册 (GH#8781) Florian Jetter暂时固定

setuptools < 71(GH#8785) James Bourbeau在

TaskPrefix上恢复len()(GH#8783) Hendrik Makait避免

p2p-failed日志事件的误报 (GH#8777) Hendrik Makait在 Prometheus 中分别展示暂停和退休的工人 (GH#8613) Patrick Hoefler

创建过渡失败日志事件 (GH#8776) alex-rakowski

为P2P重新分块实现HLG层 (GH#8751) Hendrik Makait

为可能由 (GH#8703) (GH#8769) Hendrik Makait 引起的死锁场景添加另一个测试

如果在已释放的未来上对持久化集合进行计算,则引发错误 (GH#8764) Florian Jetter

从失败的P2P任务中重新引发

P2PConsistencyError(GH#8748) Hendrik Makait更稳健、更快的测试内存采样器 (GH#8758) Florian Jetter

修复

scheduler_bokeh::test_shuffling(GH#8766) Florian Jetter增加

pubsub::test_client_worker的超时时间 (GH#8765) Florian Jetter提取异步任务组 (GH#8756) Florian Jetter

不要在工作者表中按字典顺序排序键 (GH#8753) Florian Jetter

对于频繁调用的函数,使用

functools.cache而不是functools.lru_cache(GH#8762) Jonas Dedden更强大的深度嵌套结构 (GH#8730) Florian Jetter

将HLG添加到MAP (GH#8740) alex-rakowski

在工作者信息页面添加关闭工作者按钮 (GH#8742) James Bourbeau

2024.7.0¶

亮点¶

放弃对 pandas 1.x 的支持¶

此版本放弃了对 pandas<2 的支持。pandas 2.0 现在是运行 Dask DataFrame 所需的最低版本。

partd 的最低版本也提升至 1.4.0。1.4 之前的版本与 pandas 2 不兼容。

更多详情请参见 Patrick Hoefler 的 GH#11199。

发布-订阅 API 已弃用¶

distributed.Pub 和 distributed.Sub 已被弃用,并将在未来的版本中移除。请改为使用 distributed.Client.log_event() 和 distributed.Worker.log_event()。

详情请参见 Hendrik Makait 的 GH#8724。

其他更改

仅计算

xarraysizeof中内存中的数据(GH#11206)`Florian Jetter`_修复

botocore重新引发错误 (GH#11209) Patrick Hoefler更新文档中的 Coiled 链接 (GH#11211) Sarah Charlotte Johnson

添加一些数组表达式方法 (GH#11210) Patrick Hoefler

修复箭头数据类型的

quantile(GH#11202) Patrick Hoefler添加工具以验证可选依赖 (GH#11205) Patrick Hoefler

实现数组表达式切换 (GH#11203) Patrick Hoefler

移除不再支持的

ipython引用 (GH#11196) Patrick Hoefler移除

from_delayed引用 (GH#11195) Patrick Hoefler添加其他 IO 连接器到文档 (GH#11189) Patrick Hoefler

从

cudf修复assert_eq导入 (GH#8747) James Bourbeau任务错误时记录回溯 (GH#8746) Hendrik Makait

在轮询 Prometheus 指标时更新系统监控 (GH#8745) Hendrik Makait

在

mindeps构建中将pandas升级到 2.0 (GH#8743) James Bourbeau将事件日志功能重构到代理中 (GH#8731) Hendrik Makait

放弃对 pandas 1.X 的支持 (GH#8741) Hendrik Makait

移除

is_python_shutting_down(GH#8492) Hendrik Makait修复

test_task_state_instance_are_garbage_collected(GH#8735) Hendrik Makait修复浮点数不准确性 (GH#8736) Hendrik Makait

修复

pynvml句柄 (GH#8693) Benjamin Zaitlenget_ip: 处理获取0.0.0.0(GH#8712) Adam Williamson在

test_task_state_instance_are_garbage_collected中移除FutureWarning(GH#8734) Hendrik Makait修复 CI 上的

mindeps测试 (GH#8728) Hendrik Makait将事件日志相关的测试提取到单独的文件中 (GH#8733) Hendrik Makait

为

ProcessPoolExecutor使用更安全的环境 (GH#8715) Elliott Sales de Andrade在仪表板中缓存工作地址的URL编码 (GH#8725) Florian Jetter

更强大的

bokehtest_shuffling(GH#8727) Florian Jetter修复演员文档中的类型错误 (GH#8711) Sultan Orazbayev

如果提供了插件类型而不是实例,则显示更有用的警告 (GH#8689) Florian Jetter

改进由于断开连接导致的任务取消错误 (GH#8705) Hendrik Makait

修复

test_forget_errors上的等待条件 (GH#8714) Elliott Sales de Andrade跳过

test_deadlock_dependency_of_queued_released(GH#8723) Hendrik Makait修复

test_quiet_client_close(GH#8722) Hendrik Makait修复

save_sys_modules中的清理迭代 (GH#8713) Elliott Sales de Andrade为缺失的

bokeh安装命令添加引号 (GH#8717) James Bourbeau

2024.6.2¶

这是一个补丁发布,用于更新2024.6.1版本中``dask``和``distributed``版本固定的问题。

其他更改

使文档构建通过 (GH#11184) James Bourbeau

profile._f_lineno: 在 Python 3.13 中处理next_line为None(GH#8710) Adam Williamson

2024.6.1¶

亮点¶

此版本包含一个关键修复,修复了当根任务的依赖项因工作节点丢失等原因被重新调度时可能出现的死锁问题。

更多详情请参见 Hendrik Makait 的 GH#8703。

其他更改

缓存全局查询规划配置 (GH#11183) Richard (Rick) Zamora

Python 3.13 修复了 (GH#11185) Adam Williamson

修复

pandas=3的test_map_freq_to_period_start(GH#11181) James Bourbeau将 release-drafter/release-drafter 从 5 升级到 6 (GH#8699)

2024.6.0¶

亮点¶

内存映射数组分词¶

现在,对 memmap 数组进行分词将避免将数组具体化到内存中。

更多详情请参见 Florian Jetter 的 GH#11161。

其他更改

修复

test_dt_accessor在禁用查询计划时的问题 (GH#11177) James Bourbeau使用

packaging.version.Version(GH#11171) James Bourbeau移除已弃用的

dask.compatibility模块 (GH#11172) James Bourbeau确保

xarray.NamedArray的兼容性 (GH#11168) Hendrik Makait估计

xarray集合的大小 (GH#11166) Florian Jetter添加关于期货和变量的章节 (GH#11164) Florian Jetter

更新了合并的Dask社区会议信息的文档 (GH#11159) Sarah Charlotte Johnson

避免在

test_prometheus_collect_count_total_by_cost_multipliers中的舍入误差 (GH#8687) Hendrik Makait在

update_graph日志事件中记录键冲突计数 (GH#8692) Hendrik Makait当推送新标签时自动发布 GitHub 版本 (GH#8626) Jacob Tomlinson

修复具有多个主题的日志事件 (GH#8691) Hendrik Makait

在

Scheduler.remove_worker中将safe重命名为expected(GH#8686) Hendrik Makait失败期间的日志事件 (GH#8663) Hendrik Makait

急切地更新

TaskPrefix的聚合统计数据,而不是按需计算 (GH#8681) Hendrik Makait通过避免将解包递归到索引中来改进P2P重新分块的图提交时间 (GH#8672) Florian Jetter

在

remove-worker事件中添加安全关键字 (GH#8647) alex-rakowski改进了P2P RPC调用的错误处理并减少了日志记录 (GH#8666) Hendrik Makait

调整

dask-expr的 P2P 测试 (GH#8662) Hendrik Makait遍历

Server.digests_total_since_heartbeat的副本以避免RuntimeError(GH#8670) Hendrik Makait在计算失败时记录任务状态 (GH#8668) Hendrik Makait

为任务组添加 Prometheus 仪表 (GH#8661) Hendrik Makait

修复

pandas子类中 shuffle 代码的过于严格的断言 (GH#8667) Joris Van den Bossche减少不应运行的错误任务的噪音(GH#8664) Hendrik Makait

2024年5月2日¶

此版本主要包含一些小的错误修复。

其他更改

修复CI中的夜间Zarr安装 (GH#11151) James Bourbeau

将 Python 3.11 构建添加到 GPU CI (GH#11135) Charles Blackmon-Luca

将 gpuCI 的

RAPIDS_VER更新为24.08(GH#11141)更新

test_groupby_grouper_dispatch(GH#11144) Richard (Rick) Zamora将

JamesIves/github-pages-deploy-action从 4.6.0 升级到 4.6.1 (GH#11136)在新

sparse版本发布后,取消跳过test_array_function_sparse(GH#11139) James Bourbeau修复

pandas=3上的test_parse_dates_multi_column(GH#11132) James Bourbeau不要为已标记的提交草拟发布说明 (GH#11138) Jacob Tomlinson

减少部分P2P重新分块的任务组数量 (GH#8655) Hendrik Makait

将 gpuCI 的

RAPIDS_VER更新为24.08(GH#8652)向调度器提交集合元数据 (GH#8612) Florian Jetter

避免多个

WorkerStatesphinx 错误 (GH#8643) James Bourbeau

2024年5月1日¶

亮点¶

NumPy 2.0 支持¶

此版本包含针对即将发布的 NumPy 2.0 版本的兼容性更新。

更多详情请参见 Benjamin Zaitlen 的 GH#11096 和 James Bourbeau 的 GH#11106。

增强的 Zarr 存储支持¶

此版本增加了对 MutableMapping 支持的 Zarr 存储,如 zarr.storage.DirectoryStore 等。

更多详情请参见 Greg M. Fleishman 的 GH#10422。

其他更改

对ML页面进行了小更新 (GH#11129) James Bourbeau

在0.15.2版本中跳过失败的

sparse测试 (GH#11131) James Bourbeau确保在上游CI构建中安装了每晚构建的

pyarrow(GH#11121) James Bourbeau添加ML概述文档的初始草稿 (GH#11114) Matthew Rocklin

在 gpuCI 中测试查询计划 (GH#11060) Richard (Rick) Zamora

跳过 NumPy 2.0 测试时避免

pytest错误 (GH#11110) James Bourbeau在上游CI构建中使用夜间版本的

h5py(GH#11108) James Bourbeau在上游CI构建中使用夜间版本的

scikit-image(GH#11107) James Bourbeau将

actions/checkout从 4.1.4 升级到 4.1.5 (GH#11105)修复后启用parquet追加测试 (GH#11104) Patrick Hoefler

跳过

numpy2 的fastparquet测试 (GH#11103) Patrick Hoefler修复了codespell发现的拼写错误 (GH#11097) Dimitri Papadopoulos Orfanos

修复文档构建 (GH#11099) Patrick Hoefler

清理

percentiles_summary逻辑 (GH#11094) Richard (Rick) Zamora应用

ruff/flake8-implicit-str-concat规则 ISC001 (GH#11098) Dimitri Papadopoulos Orfanos使用 Python 3.13 修复 Windows 上的时钟 (GH#8642) Victor Stinner

修复 Mac OS (arm64) 上的“打印主机信息” CI 步骤 (GH#8638) Hendrik Makait

2024.5.0¶

亮点¶

此版本主要包含一些小的错误修复。

其他更改

不要链接到

clickintersphinx 开发版本 (GH#11091) M Bussonnier修复了一些

dask-expr表达式的 API 文档链接 (GH#11092) Patrick Hoefler将

dask-expr添加到上游构建 (GH#11086) Patrick Hoefler在启用

query-planning时添加melt支持 (GH#11088) Richard (Rick) Zamora在

numpy2 环境中跳过数据帧/产品 (GH#11089) Benjamin Zaitlen添加图表以说明优化器的作用 (GH#11072) Patrick Hoefler

修复

pandas上游测试 (GH#11085) Patrick Hoefler将

conda-incubator/setup-miniconda从 3.0.3 升级到 3.0.4 (GH#11084)将

actions/checkout从 4.1.3 升级到 4.1.4 (GH#11083)修复

pytest更改后的 CI (GH#11082) Patrick Hoefler修复测试以实现更高效的

dask-expr实现 (GH#11071) Patrick Hoefler泛化

clear_known_categories工具 (GH#11059) Richard (Rick) Zamora将

JamesIves/github-pages-deploy-action从 4.5.0 升级到 4.6.0 (GH#11062)将

release-drafter/release-drafter从 5 升级到 6 (GH#11063)将

actions/checkout从 4.1.2 升级到 4.1.3 (GH#11061)更新 GPU CI

RAPIDS_VER到 24.06,禁用查询规划 (GH#11045) Charles Blackmon-Luca移动测试 (GH#8631) Hendrik Makait

将

actions/checkout从 4.1.2 升级到 4.1.3 (GH#8628)

2024年4月2日¶

亮点¶

简单的合并实现¶

查询优化器将检查查询,以确定是否需要对 merge(...) 或 groupby(...).apply(...) 进行洗牌。如果在之前的步骤中,DataFrame 已经在相同的列上进行了洗牌,并且中间没有任何操作改变分区布局或每个分区中的相关值,则可以避免洗牌。

>>> result = df.merge(df2, on="a")

>>> result = result.merge(df3, on="a")

查询优化器将识别到``result``之前已经在``”a”``上进行了洗牌,因此在第二次合并操作中仅对``df3``进行洗牌,然后再进行块级合并。

read_parquet 中的自动分区¶

如果从 Parquet 文件读取的单个分区太小,查询优化器将自动重新分区数据集。这将减少分区数量,从而也减少了任务图的大小。

优化器旨在生成至少75MB的分区,并在必要时将多个文件合并以达到此阈值。该值可以通过使用进行配置。

>>> dask.config.set({"dataframe.parquet.minimum-partition-size": 100_000_000})

该值以字节为单位给出。默认阈值相对保守,以避免工作节点上每个线程的内存量相对较小时出现内存问题。

其他更改

添加 GitHub 发布自动化 (GH#11057) Jacob Tomlinson

为新版本添加变更日志条目(GH#11058) Patrick Hoefler

在

_bind_property中恢复 try/except 块 (GH#11049) Lawrence Mitchell修复查询计划文档的链接 (GH#11054) Patrick Hoefler

为Parquet文件大小添加配置参数 (GH#11052) Patrick Hoefler

为查询优化器添加文档 (GH#11043) Patrick Hoefler

将 np.ma.masked 赋值给对象类型数组 (GH#9627) David Hassell

如果未安装

dask_expr,请不要报错 (GH#11048) Simon Høxbro Hansen调整

test_set_index以适应“cudf”后端 (GH#11029) Richard (Rick) Zamora使用

to/from_legacy_dataframe代替to/from_dask_dataframe(GH#11025) Richard (Rick) Zamora标记化 bag

groupby键 (GH#10734) Charles Stern为与点对点相关的调度函数添加延迟“cudf”注册 (GH#11040) Richard (Rick) Zamora

在异常时收集

memray配置文件 (GH#8625) Florian Jetter确保

inproc正确模拟序列化协议 (GH#8622) Florian Jetter放松测试统计分析2 (GH#8621) Florian Jetter

当

worker-ttl过期时重启工作进程 (GH#8538) crusaderky使用

monotonic进行截止时间测试 (GH#8620) Florian Jetter修复带有注释的已发布期货的竞争条件 (GH#8577) Florian Jetter

如果工作进程因内存压力而重启,则发送日志事件 (GH#8617) Patrick Hoefler

不要在CI中打印xfailed测试 (GH#8619) Florian Jetter

确保工人在参与p2p时不会被缩减 (GH#8610) Florian Jetter

针对稳定的

fsspec运行 (GH#8615) Florian Jetter

2024年4月1日¶

这是一个小型的错误修复版本,修复了在 Python 3.11.9 中导入 dask.dataframe 时的一个错误。

详情请参见 Richard (Rick) Zamora 的 GH#11035 和 GH#11039。

其他更改

移除命名聚合的跳过 (GH#11036) Patrick Hoefler

在反序列化时不要深度复制只读缓冲区 (GH#8609) crusaderky

将

dask-expr添加到daskconda 配方中 (GH#8601) Charles Blackmon-Luca

2024.4.0¶

亮点¶

查询计划修复¶

此版本包含Dask DataFrame新查询计划器中的各种错误修复。

GPU 指标仪表板修复¶

GPU 内存和利用率仪表盘功能已恢复。之前这些图表无意中被留空。

详情请参见 Benjamin Zaitlen 的 GH#8572。

其他更改

在标签发布时构建夜间版本 (GH#11014) Charles Blackmon-Luca

从测试套件中移除

xfail回溯 (GH#11028) Patrick Hoefler修复上游

pandas更改的 CI (GH#11027) Patrick Hoefler修复

value_counts在分支仅包含 nans 时引发的错误 (GH#11023) Patrick Hoefler在

dask_cudf中启用自定义表达式 (GH#11013) Richard (Rick) Zamora当无法导入

dask-expr时,引发ImportError而不是ValueError(GH#11007) James Lamb将 HypersSpy 添加到

ecosystem.rst(GH#11008) Jonas Lähnemann将 Hugging Face

hf://添加到fsspec兼容的远程服务列表中 (GH#11012) Quentin Lhoest将

actions/checkout从 4.1.1 升级到 4.1.2 (GH#11009)刷新注释和跨度的文档 (GH#8593) crusaderky

修复来自

pandas的弃用警告 (GH#8564) Patrick Hoefler将 Python 3.11 添加到 GPU CI 矩阵 (GH#8598) Charles Blackmon-Luca

使用单调计时器的截止时间 (GH#8597) crusaderky

将 gpuCI 的

RAPIDS_VER更新为24.06(GH#8588)重构

restart()和restart_workers()(GH#8550) crusaderky将

actions/checkout从 4.1.1 升级到 4.1.2 (GH#8587)在失败的

sizeof警告中包含类型 (GH#8580) James Bourbeau

2024年3月1日¶

这是一个小版本发布,主要是在升级时,如果未安装 dask-expr ,则将异常降级为警告。

其他更改

只有在

dask-expr未安装时发出警告 (GH#11003) Florian Jetter修复由 codespell 发现的拼写错误 (GH#10993) Dimitri Papadopoulos Orfanos

禁用

dask-expr的额外 CI 作业 (GH#8583) crusaderky修复不稳定的

test_restart_waits_for_new_workers(GH#8573) crusaderky修复不稳定的

test_raise_on_incompatible_partitions(GH#8571) crusaderky

2024.3.0¶

发布于2024年3月11日

亮点¶

查询规划¶

此版本默认启用了 dask.dataframe 所有用户的查询计划功能。

查询规划功能代表了使用 dask-expr 对 DataFrame 的重写。这是一个即插即用的替代方案,我们预计大多数用户不需要调整他们的代码。任何反馈可以在 Dask 的 问题追踪器 上报告,或者在 查询规划反馈问题 上提交。

如果你遇到任何问题,你仍然可以通过设置来选择退出。

>>> import dask

>>> dask.config.set({'dataframe.query-planning': False})

Pandas 1.X 支持的落日¶

新的查询规划后端至少需要 pandas 2.0 版本。如果你通过 conda 安装,或者使用 dask[complete] 或 dask[dataframe] 从 pip 安装,pandas 版本将自动安装。

如果你在没有额外安装的情况下安装 dask,遗留的 DataFrame 实现仍然支持 pandas 1.X。

其他更改

使用 dask-expr 更新 pandas 夜间测试 (GH#10989) Patrick Hoefler

使用 dask-expr 文档作为 DataFrame 的主要参考文档 (GH#10990) Patrick Hoefler

调整 dask-expr 的 from_array 测试 (GH#10988) Patrick Hoefler

取消跳过

to_delayed测试 (GH#10985) Patrick Hoefler将 conda-incubator/setup-miniconda 从 3.0.1 升级到 3.0.3 (GH#10978)

修复启用 dask-expr 时的错误 (GH#10977) Patrick Hoefler

更新 dask-expr 的文档和需求并移除警告 (GH#10976) Patrick Hoefler

修复 numpy 2 与 ogrid 使用的兼容性 (GH#10929) David Hoese

打开 dask-expr 开关 (GH#10967) Patrick Hoefler

强制使用相同的字节顺序解释初始化随机种子… (GH#10970) Elliott Sales de Andrade

在读取CSV时使用正确的行终止符编码 (GH#10972) Elliott Sales de Andrade

perf: 在 _optimize_blockwise 中不要不必要地重新计算输入/输出索引 (GH#10966) Lindsey Gray

调整 dask-expr 中字符串选项的测试 (GH#10968) Patrick Hoefler

调整 dask-expr 中数组转换的测试 (GH#10973) Patrick Hoefler

TST: 修复32位上的sizeof测试 (GH#10971) Elliott Sales de Andrade

TST: 为 pyarrow 添加缺失的跳过 (GH#10969) Elliott Sales de Andrade

为

bag.to_dataframe实现 dask-expr 转换 (GH#10963) Patrick Hoefler清理

dask.config的 Sphinx 文档 (GH#10959) crusaderky在 Python 3.12+ 上使用标准库

importlib.metadata(GH#10955) wim glenn将 partitioning_index 转换为更小的尺寸 (GH#10953) Florian Jetter

重用 dask/dask 分组聚合 (GH#10952) Patrick Hoefler

确保期货上的代币是唯一的 (GH#8569) Florian Jetter

不要掩盖良好的性能指标失败 (GH#8568) crusaderky

在 dask-expr 中标记 shuffle 快速任务 (GH#8563) crusaderky

按持续时间衡量 Gilknocker Prometheus 指标 (GH#8558) crusaderky

修复 memory->erred 上的调度器转换错误 (GH#8549) Hendrik Makait

修复不稳定的 test_Future_release_sync (GH#8562) crusaderky

修复不稳定的 test_flaky_connect_recover_with_retry (GH#8556) Hendrik Makait

在 scheduler.py 中进行类型调整 (GH#8551) crusaderky

将 conda-incubator/setup-miniconda 从 3.0.2 升级到 3.0.3 (GH#8553)

在CI上安装dask-expr (GH#8552) Hendrik Makait

P2P shuffle 可以在写入磁盘之前删除分区列 (GH#8531) Hendrik Makait

改进工作器移除的日志记录 (GH#8517) crusaderky

添加指示器支持以进行合并 (GH#8539) Patrick Hoefler

将 conda-incubator/setup-miniconda 从 3.0.1 升级到 3.0.2 (GH#8535)

获取模块路径时避免迭代错误 (GH#8533) James Bourbeau

在代码收集时忽略标准库的 threading 模块 (GH#8532) James Bourbeau

修复P2P重试时的过度日志记录 (GH#8511) Hendrik Makait

防止 retire_workers 参数中的拼写错误 (GH#8524) crusaderky

对 test_steal 进行美化清理(从 #8185 回溯) (GH#8509) crusaderky

修复不稳定的 test_compute_per_key (GH#8521) crusaderky

修复不稳定的 test_no_workers_timeout_queued (GH#8523) crusaderky

2024年2月1日¶

发布于2024年2月23日

亮点¶

允许静默 dask.DataFrame 弃用警告¶

上一个版本包含了一个 DeprecationWarning,它提醒用户即将切换 dask.dafaframe 以使用支持查询计划的新后端(另见 GH#10934)。

此 DeprecationWarning 在导入 dask.dataframe 模块时触发,社区对此过于冗长表示担忧。

现在可以静音此警告

# via Python

>>> dask.config.set({'dataframe.query-planning-warning': False})

# via CLI

dask config set dataframe.query-planning-warning False

更强大的分布式调度器,用于处理罕见的关键冲突¶

块级融合优化可能会导致任务键冲突,该冲突未被分布式调度器正确处理(参见 GH#9888)。用户通常会通过看到导致系统死锁或严重故障的各种内部异常来注意到这一点。虽然此问题无法修复,但调度器现在实现了一种机制,该机制应能缓解大多数情况,并在检测到问题时发出警告。

详情请参见 crusaderky 和 Florian Jetter 的 GH#8185。

在这过程中,tokenization 已经实施了各种改进。详情请参见 GH#10913, GH#10884, GH#10919, GH#10896 以及主要来自 crusaderky 的 GH#10883。

在大规模集群上更强大的自适应缩放¶

自适应缩放在之前如果需要移动许多任务进行缩减时可能会丢失数据。这通常(但不限于)发生在大规模集群上,表现为任务的重新计算,并可能导致集群在扩展和缩减之间振荡而无法完成。

更多详情请参见 crusaderky 的 GH#8522。

其他更改

移除不稳定的 fastparquet 测试 (GH#10948) Patrick Hoefler

启用来自 dask-expr 的聚合 (GH#10947) Patrick Hoefler

更新 dask-expr 中分配更改的测试 (GH#10944) Patrick Hoefler

调整以适应 pandas 大字符串更改 (GH#10942) Patrick Hoefler

修复不稳定的 test_describe_empty (GH#10943) crusaderky

使用 Python 3.12 作为参考环境 (GH#10939) crusaderky

[Cosmetic] 清理 test_config.py 中的临时路径 (GH#10938) crusaderky

[CLI]

dask config set和dask config find更新。(GH#10930) Miles当一个块充满NaN时使用combine_first (GH#10932) crusaderky

正确解析CLI中的小写true/false配置 (GH#10926) crusaderky

dask config get修复了打印 None 值的问题 (GH#10927) crusaderky查询规划不能为空 (GH#10928) crusaderky

再次加快 nunique 的速度 (GH#10922) Patrick Hoefler

清理了一些 Cython 警告处理 (GH#10924) crusaderky

将 pre-commit/action 从 3.0.0 升级到 3.0.1 (GH#10920)

提高并避免提供给 P2P 洗牌的元数据丢失是错误的 (GH#8520) Florian Jetter

修复 gpuci: np.product 已被弃用 (GH#8518) crusaderky

将 gpuCI 的

RAPIDS_VER更新为24.04(GH#8471)在 Python 3.12 上取消固定 ipywidgets (GH#8516) crusaderky

在 run_spec 冲突时保留旧依赖 (GH#8512) crusaderky

微小的mypy修复 (GH#8513) crusaderky

确保大负载可以被序列化并通过通讯发送 (GH#8507) Florian Jetter

允许配置大型图警告阈值 (GH#8508) Florian Jetter

与分词相关的测试调整(从 #8185 回溯)(GH#8499) crusaderky

对

update_graph的调整(从 #8185 回传) (GH#8498) crusaderkyAMM: 测试增量退休 (GH#8501) crusaderky

在CI中抑制dask-expr警告 (GH#8505) crusaderky

在CI中忽略dask-expr警告 (GH#8504) James Bourbeau

改进P2P稳定排序的测试 (GH#8458) Hendrik Makait

将 pre-commit/action 从 3.0.0 升级到 3.0.1 (GH#8503)

2024.2.0¶

发布于2024年2月9日

亮点¶

弃用 Dask DataFrame 实现¶

当前的 Dask DataFrame 实现已被弃用。在未来的版本中,Dask DataFrame 将使用包含多项改进的新实现,包括逻辑查询计划。面向用户的 DataFrame API 将保持不变。

新的实现已经可用,可以通过安装 dask-expr 库来启用:

$ pip install dask-expr

并开启查询规划选项:

>>> import dask

>>> dask.config.set({'dataframe.query-planning': True})

>>> import dask.dataframe as dd

新实现的API文档可在 http://www.aidoczh.com/dask/en/stable/dataframe-api.html 获取

任何反馈都可以在 Dask 问题跟踪器 https://github.com/dask/dask/issues 上报告。

详情请参见 Patrick Hoefler 的 GH#10912。

改进的分词¶

此版本包含了对 Dask 对象令牌化逻辑的若干改进。现在更多对象生成确定性令牌,这可以通过缓存中间结果来提高性能。

详情请参见 crusaderky 的 GH#10898, GH#10904, GH#10876, GH#10874, 和 GH#10865。

其他更改

修复字符串转换中对只读数组的就地修改 (GH#10886) Patrick Hoefler

为

dask-expr添加变更日志条目 (GH#10915) Patrick Hoefler修复

cudf的leftsemi合并 (GH#10914) Patrick Hoefler对

dask-expr警告的轻微更新 (GH#10916) James Bourbeau改进

groupby.nunique的性能 (GH#10910) Patrick Hoefler在

dask-expr中为leftsemi合并添加配置 (GH#10908) Patrick Hoefler调整

dask-expr的分配测试 (GH#10907) Patrick Hoefler在GPU CI的

test_to_datetime中避免使用pytest.warns(GH#10902) Richard (Rick) Zamora更新文档首页的部署选项 (GH#10901) James Bourbeau

修复数据框文档中的拼写错误 (GH#10900) Matthew Rocklin

将

peter-evans/create-pull-request从 5 升级到 6 (GH#10894)修复 mimesis API

>=13.1.0- 使用random.randint(GH#10888) Miles调整无效测试 (GH#10897) Patrick Hoefler

Pickle

da.argwhere和da.count_nonzero(GH#10885) crusaderky修复

dask-expr测试后单例 pr (GH#10892) Patrick Hoefler为新的parquet缓存添加了几个``dask-expr``修复 (GH#10880) Florian Jetter

更新部署文档 (GH#10882) Matthew Rocklin

从

dask-expr文档构建开始 (GH#10879) Patrick Hoefler测试静态方法和类方法的标记化 (GH#10872) crusaderky

在API文档中添加

distributed.print和distributed.warn(GH#10878) James Bourbeau在M1架构上运行macos ci (GH#10877) Patrick Hoefler

更新

dask-expr的测试 (GH#10838) Patrick Hoefler更新 parquet 测试以与

dask-expr修复 (GH#10851) 保持一致 Richard (Rick) Zamora修复

test_graph_manipulation中的回归问题 (GH#10873) crusaderky调整

pytest错误以适应 dask-expr ci (GH#10871) Patrick Hoefler从

pyproject.toml中移除警告过滤器 (GH#10867) Patrick Hoefler跳过

test_append_with_partition以使用 fastparquet (GH#10828) Patrick Hoefler修复

pytest8 个问题 (GH#10868) Patrick Hoefler调整

dask-expr中Groupby.aggregate对中位数支持的测试 (2/2) (GH#10870) Hendrik Makait在

sort_values中允许升序的长度大于一 (GH#10864) Florian Jetter允许在 Python 3.9 中引发其他消息 (GH#10862) Hendrik Makait

在病理情况下获取计算代码时不要崩溃 (GH#8502) James Bourbeau

将

peter-evans/create-pull-request从 5 升级到 6 (GH#8494)修复

cudf溢出指标的测试 (GH#8478) Mads R. B. Kristensen升级到

pytest8 (GH#8482) crusaderky修复

test_two_consecutive_clients_share_results(GH#8484) crusaderky

2024年1月1日¶

发布于2024年1月26日

亮点¶

Pandas 2.2 和 Scipy 1.12 支持¶

此版本包含针对最新 pandas 和 scipy 版本的兼容性更新。

详情请参见 crusaderky 的 GH#10834, GH#10849, GH#10845, 和 GH#8474。

弃用¶

在大多数 DataFrame 方法中弃用

out=和dtype=参数 (GH#10800) crusaderky

其他更改

将推荐的部署选项添加到部署文档中 (GH#10866) James Bourbeau

改进

_agg_finalize以符合输出预期 (GH#10835) Hendrik Makait为 hlg 实现确定性分词 (GH#10817) Patrick Hoefler

重构:将

tokenize()的测试移至其自己的模块 (GH#10863) crusaderky更新 DataFrame 示例部分 (GH#10856) James Bourbeau

暂时固定

mimesis<13.1.0(GH#10860) James Bourbeau对

_testing.py进行了微小的外观调整(GH#10857) crusaderky取消跳过并调整使用

dask-expr的groupby-聚合median的测试 (GH#10832) Hendrik Makait在上游CI中修复

sizeof(pd.MultiIndex)的测试 (GH#10850) crusaderkynumpy2.0: 修复uint64数组的切片 (GH#10854) crusaderky将

numpy版本常量重命名为与pandas匹配 (GH#10843) crusaderky将

actions/cache从 3 升级到 4 (GH#10852)将 gpuCI

RAPIDS_VER更新为24.04(GH#10841)修复doctest中的弃用问题 (GH#10844) crusaderky

在

numpy2.x 中更改了dtype算术 (GH#10831) crusaderky调整

dask-expr中median支持的测试 (GH#10839) Patrick Hoefler调整

dask-expr中groupby-aggregate对median支持的测试 (GH#10840) Hendrik Makaitnumpy2.x: 修复MaskedArray上的std()(GH#10837) crusaderky如果测试失败,则失败

dask-exprci (GH#10829) Patrick Hoefler在导出测试时激活

query_planning(GH#10833) Patrick Hoefler公开数据框测试 (GH#10830) Patrick Hoefler

numpy2: n 维fft函数中的弃用 (GH#10821) crusaderky为

dask-expr泛化CreationDispatch(GH#10794) Richard (Rick) Zamora修复更多测试以使用

pytest.warns()(GH#10818) Michał Górnynp.unique(): 逆向在numpy2 (GH#10819) crusaderky将

test_split_adaptive_files固定到pyarrow引擎 (GH#10820) Patrick Hoefler调整

dask/dask中的剩余测试 (GH#10813) Patrick Hoefler仅限于 Arrow 的测试 (GH#10814) Patrick Hoefler

从

std测试中过滤警告 (GH#10815) Patrick Hoefler调整大部分索引测试 (GH#10790) Patrick Hoefler

部署文档更新 (GH#10778) Sarah Charlotte Johnson

调整

test_to_datetime以兼容dask-exprHendrik Makait上游CI调整 (GH#10806) crusaderky

改进

to_numeric的测试 (GH#10804) Hendrik Makait处理矩阵子类的序列化 (GH#8480) Florian Jetter

在P2P中使用最小的数据类型作为分区列 (GH#8479) Florian Jetter

pandas2.2: 修复test_dataframe_groupby_tasks(GH#8475) crusaderky将

actions/cache从 3 升级到 4 (GH#8477)pandas2.2 与pyarrow14: 已弃用DatetimeTZBlock(GH#8476) crusaderkypandas2.2.0: 弃用频率别名M以支持ME(GH#8473) Hendrik Makait修复文档构建 (GH#8472) Hendrik Makait

修复基于P2P的连接与显式

npartitions(GH#8470) Hendrik MakaitNit: 在测试报告环境中硬编码Python版本 (GH#8462) crusaderky

替换所有

sys.is_finalizing的出现 (GH#8449) Florian Jetter

2024.1.0¶

发布于2024年1月12日

亮点¶

P2P 中的部分重新分块¶

P2P 重新分块现在利用了输入和输出块之间的关系。对于不需要全对全数据传输的情况,这可能会显著减少运行时间和内存/磁盘占用。它还支持任务剔除。

详情请参见 Hendrik Makait 的 GH#8330。

Fastparquet 引擎已弃用¶

fastparquet Parquet 引擎已被弃用。用户应通过 安装 PyArrow 并移除 read_parquet 或 to_parquet 调用中的 engine="fastparquet" 来迁移到 pyarrow 引擎。

详情请参见 crusaderky 的 GH#10743。

改进了对任意数据的序列化¶

此版本改进了对任意数据的序列化鲁棒性。之前在某些情况下,序列化非 msgpack 可序列化的数据时可能会失败。现在在这些情况下,我们改为使用 pickle。

详情请参见 Hendrik Makait 的 GH#8447。

额外的弃用¶

弃用

shuffle关键字,改为使用shuffle_method作为 DataFrame 方法 (GH#10738) Hendrik Makait在

repartition中弃用自动参数推断 (GH#10691) Patrick Hoefler弃用

set_index和sort_values的npartitions="auto"(GH#10750) Miles

其他更改

避免在任务洗牌中使用导致数据丢失的快捷方式 (GH#10763) Patrick Hoefler

在排序时忽略数据任务 (GH#10706) Florian Jetter

从

dask-expr添加get_dummies(GH#10791) Patrick Hoefler调整

dask-expr迁移的 IO 测试 (GH#10776) Patrick Hoefler移除

groupby中关于sort和split_out的弃用警告 (GH#10788) Patrick Hoefler解决

pandas的弃用问题 (GH#10789) Patrick Hoefler在

get_scheduler中仅导入distributed一次 (GH#10771) Florian Jetter简化 GitHub 操作 (GH#10781) crusaderky

清理CI中的冗余部分 (GH#10768) crusaderky

更新

ufunc的测试 (GH#10773) Patrick Hoefler使用

pytest.mark.skipif(DASK_EXPR_ENABLED)(GH#10774) crusaderky调整

dask-expr的随机测试 (GH#10759) Patrick Hoefler修复了来自

pandas的一些弃用警告 (GH#10749) Patrick Hoefler调整

dask-expr的随机测试 (GH#10762) Patrick Hoefler更新

pre-commit(GH#10767) Hendrik Makait在CI中清理配置开关 (GH#10766) crusaderky

改进

validate_key的异常 (GH#10765) Hendrik Makait在

set_index中处理未知的datetimeindexes分割 (GH#10757) Patrick Hoefler为小数添加哈希 (GH#10758) Patrick Hoefler

审查

is_monotonic的测试 (GH#10756) crusaderky在

value_counts_aggregate中更改参数顺序 (GH#10751) Patrick Hoefler调整

dask-expr的一些 groupby 测试 (GH#10752) Patrick Hoefler将 mimesis 限制在

< 12以适应 3.9 构建 (GH#10755) Patrick Hoefler不要在跳过条件中评估配置 (GH#10753) Patrick Hoefler

调整一些测试以兼容

dask-expr(GH#10714) Patrick Hoefler使

dask.array.utils函数更通用到其他 Dask 数组 (GH#10676) Matthew Rocklin删除重复的“单机”部分 (GH#10747) Matthew Rocklin

调整 ORC

engine=参数 (GH#10746) crusaderky在文档首页添加任务图动画 (GH#10730) Sarah Charlotte Johnson

使用新的 Xarray 标志 (GH#10729) James Bourbeau

更新“10分钟了解Dask”页面上的标签样式 (GH#10728) James Bourbeau

在CI中更新环境文件上传步骤 (GH#10726) James Bourbeau

如果

split_out>1,不要在 GroupBy.nunqiue 中重复未观察到的类别 (GH#10716) Patrick Hoeflerdask.order更新的变更日志条目 (GH#10715) Florian Jetter在

_check_dsk中放松冗余键检查 (GH#10701) Richard (Rick) Zamora恢复

pickle更改 (GH#8456) Florian Jetter为P2P洗牌保持稳定的顺序 (GH#8453) Hendrik Makait

允许维护者手动调度测试工作流 (GH#8445) Erik Sundell

将调度器相关的转换功能设为私有 (GH#8448) Hendrik Makait

更新

pre-commit钩子 (GH#8444) Hendrik Makait在序列化时不要总是检查

__main__ in result(GH#8443) Florian Jetter仅在实现时将

wait_for_workers委托给集群实例 (GH#8441) Erik Sundell在

test_pandas中延长睡眠时间 (GH#8440) Julian Gilbey避免使用已弃用的

shuffle关键字 (GH#8439) Hendrik MakaitShuffle 指标 4/4: 移除定制诊断 (GH#8367) crusaderky

不要在测试套件中运行

gilknocker(GH#8423) Florian Jetter调整

abstractmethods(GH#8427) crusaderkyShuffle 指标 3/4: 捕获背景指标 (GH#8366) crusaderky

洗牌指标 2/4:添加背景指标 (GH#8365) crusaderky

洗牌指标 1/4: 添加前景指标 (GH#8364) crusaderky

将

actions/upload-artifact从 3 升级到 4 (GH#8420)修复

test_merge_p2p_shuffle_reused_dataframe_with_different_parameters(GH#8422) Hendrik Makait改进P2P调度器插件中的日志记录 (GH#8410) Hendrik Makait

重新启用

test_decide_worker_coschedule_order_neighbors(GH#8402) Florian Jetter将cuDF溢出统计信息添加到RMM/GPU内存图中 (GH#8148) Charles Blackmon-Luca

修复Nanny启动的worker的哈希不一致问题 (GH#8400) Charles Stern

如果工作线程正在运行长时间运行的任务(例如

worker_client),则不允许其缩减 (GH#7481) Florian Jetter修复不稳定的

test_subprocess_cluster_does_not_depend_on_logging(GH#8417) crusaderky

2023.12.1¶

发布于2023年12月15日

亮点¶

逻辑查询计划现可用于 Dask DataFrames¶

Dask DataFrames 现在通过使用逻辑查询计划器性能得到了很大提升。此功能目前默认关闭,但可以通过以下方式开启:

dask.config.set({"dataframe.query-planning": True})

您还需要安装 dask-expr:

pip install dask-expr

到目前为止,我们已经看到了有希望的性能提升,更多信息请参见 这篇博客文章 和 这些定期更新的基准测试。关于查询优化器如何工作的更详细解释可以在 这篇博客文章 中找到。

此功能仍在积极开发中,API 尚未稳定,因此可能会发生重大变化。我们预计将在明年年初将查询优化器设为默认。

详情请参见 Patrick Hoefler 的 GH#10634。

read_parquet 中的Dtype推断¶

read_parquet 现在会将 Arrow 类型 pa.date32(), pa.date64() 和 pa.decimal() 推断为 pandas 中的 ArrowDtype。这些数据类型由原始的 Arrow 数组支持,因此避免了转换为 NumPy 对象。此外,read_parquet 将不再将嵌套和二进制类型推断为字符串,它们将被存储在 NumPy 对象数组中。

详情请参见 Patrick Hoefler 的 GH#10698 和 GH#10705。

调度改进以减少内存使用¶

此版本对调度逻辑的核心部分进行了重大重写。它包括在 dask.order 中对拓扑排序算法的新方法,该算法决定了任务的运行顺序。不当的排序被认为是导致集群内存压力过大的主要原因。

此版本更新修复了在 2023.10.0 版本中引入的一些性能退化问题(参见 GH#10535)。通常情况下,计算现在会更加积极地释放数据,如果这些数据不再需要在内存中保留的话。

详情请参见 Florian Jetter 的 GH#10660, GH#10697。

改进的基于P2P的合并鲁棒性和性能¶

此版本包含多个更新,修复了2023.9.2版本中可能引入的死锁问题,并增强了集群动态扩展时基于P2P合并的鲁棒性。

详情请参见 Hendrik Makait 的 GH#8415, GH#8416, 和 GH#8414。

已移除禁用 pickle 选项¶

distributed.scheduler.pickle 配置选项不再支持。自2023.4.0版本起,pickle 用于传输任务图,因此不能再被禁用。现在,当 distributed.scheduler.pickle 设置为 False 时,我们会引发一个信息性的错误。

详情请参见 Florian Jetter 的 GH#8401。

其他更改

为最近的P2P合并修复添加变更日志条目 (GH#10712) Hendrik Makait

更新 DataFrame 页面 (GH#10710) Matthew Rocklin

为

dask-expr切换添加变更日志条目 (GH#10704) Patrick Hoefler改进

PipInstall更改的变更日志条目 (GH#10711) Hendrik Makait移除 PR 标签器 (GH#10709) James Bourbeau

向

Delayed对象添加.__wrapped__(GH#10695) Andrew S. Rosen将

actions/labeler从 4.3.0 升级到 5.0.0 (GH#10689)将

actions/stale从 8 升级到 9 (GH#10690)[Dask.order] 从排序中移除非可运行的叶子节点 (GH#10697) Florian Jetter

更新安装文档 (GH#10699) Matthew Rocklin

修复文档中的软件环境链接 (GH#10700) James Bourbeau

避免将非字符串转换为箭头字符串以读取parquet文件 (GH#10692) Patrick Hoefler

将

xarray-contrib/issue-from-pytest-log从 1.2.7 升级到 1.2.8 (GH#10687)文档更新,修复样式,提及免费 (GH#10679) Matthew Rocklin

更新部署文档 (GH#10680) Matthew Rocklin

使用关键路径方法重写 Dask.order (GH#10660) Florian Jetter

避免替换多次出现的键 (GH#10646) Florian Jetter

添加缺失的图片到文档 (GH#10694) Matthew Rocklin

将

actions/setup-python从 4 升级到 5 (GH#10688)更新着陆页 (GH#10674) Matthew Rocklin

在调度中简化元检查 (GH#10638) Patrick Hoefler

Pin PR 标签器 (GH#10675) Matthew Rocklin

稍微重新组织文档索引 (GH#10669) Matthew Rocklin

将

actions/setup-java从 3 升级到 4 (GH#10667)将

conda-incubator/setup-miniconda从 2.2.0 升级到 3.0.1 (GH#10668)将

xarray-contrib/issue-from-pytest-log从 1.2.6 更新到 1.2.7 (GH#10666)修复

test_categorize_info与 nightlypyarrow(GH#10662) James Bourbeau重写

test_subprocess_cluster_does_not_depend_on_logging(GH#8409) Hendrik Makait在

SpillBuffer中未能 pickle 键时避免RecursionError并使用tblib=3(GH#8404) Hendrik Makait允许任务覆盖

is_rootish启发式 (GH#8412) Hendrik Makait移除 GPU 执行器 (GH#8399) Hendrik Makait

不要依赖于子进程集群的日志记录 (GH#8398) Hendrik Makait

将 gpuCI 的

RAPIDS_VER更新为24.02(GH#8384)将

actions/setup-python从 4 升级到 5 (GH#8396)确保在P2P重新分块中的输出块均匀分布 (GH#8207) Florian Jetter

琐事:修正拼写错误 (GH#8395) crusaderky

将

JamesIves/github-pages-deploy-action从 4.4.3 升级到 4.5.0 (GH#8387)将

conda-incubator/setup-miniconda from从 3.0.0 升级到 3.0.1 (GH#8388)

2023.12.0¶

发布于2023年12月1日

亮点¶

Pip安装 重启和环境变量¶

distributed.PipInstall 插件现在具有更强大的重启逻辑,并且还支持 环境变量。

下面展示了用户如何使用 distributed.PipInstall 插件和一个 TOKEN 环境变量来安全地从私有仓库安装包:

from dask.distributed import PipInstall

plugin = PipInstall(packages=["private_package@git+https://${TOKEN}@github.com/dask/private_package.git])

client.register_plugin(plugin)

详情请参见 Hendrik Makait 的 GH#8374、GH#8357 和 GH#8343。

Bokeh 3.3.0 兼容性¶

此版本包含与使用 bokeh>=3.3.0 和代理 Dask 仪表板的兼容性更新。以前,仪表板图表的内容不会显示。

详情请参见 Jacob Tomlinson 的 GH#8347 和 GH#8381。

其他更改

在

test_pyarrow_filesystem_option_real_data中添加network标记 (GH#10653) Richard (Rick) Zamora将 GPU CI 升级到 CUDA 11.8 (GH#10656) Charles Blackmon-Luca

确定性地标记

pandas偏移量 (GH#10643) Patrick Hoefler添加 tokenize

pd.NA功能 (GH#10640) Patrick Hoefler将 gpuCI

RAPIDS_VER更新为24.02(GH#10636)为

DataFrame.clip和Series.clip添加axis参数 (GH#10616) Richard (Rick) Zamora更新内存中重新分块的变更日志条目 (GH#10630) Florian Jetter

修复不稳定的

test_resources_reset_after_cancelled_task(GH#8373) crusaderky将 GPU CI 升级到 CUDA 11.8 (GH#8376) Charles Blackmon-Luca

将

conda-incubator/setup-miniconda从 2.2.0 升级到 3.0.0 (GH#8372)向P2P调度器插件添加调试日志 (GH#8358) Hendrik Makait

O(1)访问/info/task/端点 (GH#8363) crusaderky从 shuffle 注解中移除字符串化 (GH#8362) crusaderky

不要将

int指标转换为float(GH#8361) crusaderky删除 asyncio TCP 后端 (GH#8355) Florian Jetter

为

context_meter.add_callback添加卸载支持 (GH#8360) crusaderky测试

sync()传播 contextvars (GH#8354) crusaderkycaptured_context_meter(GH#8352) crusaderkycontext_meter.clear_callbacks(GH#8353) crusaderky使用

@log_errors装饰器 (GH#8351) crusaderky修复

test_statistical_profiling_cycle(GH#8356) Florian JetterShuffle: 不要在每次RPC时解析dask.config (GH#8350) crusaderky

将

Client.register_plugin的idempotent参数替换为插件上的.idempotent属性 (GH#8342) Hendrik Makait修复测试报告生成 (GH#8346) Hendrik Makait

在

mindeps-pandasCI 上安装pyarrow-hotfix(GH#8344) Hendrik Makait更新

pre-commit代码检查工具 (GH#8340) crusaderky使用显式

dtype=object更新 cuDF 测试 (GH#8339) Peter Andreas Entschev修复

Cluster/SpecCluster调用异步关闭方法 (GH#8327) Peter Andreas Entschev

2023.11.0¶

发布于2023年11月10日

亮点¶

零拷贝 P2P 数组重新分块¶

使用内存中P2P数组重新分块时,用户应看到显著的性能提升。这是由于不再复制底层数据缓冲区。

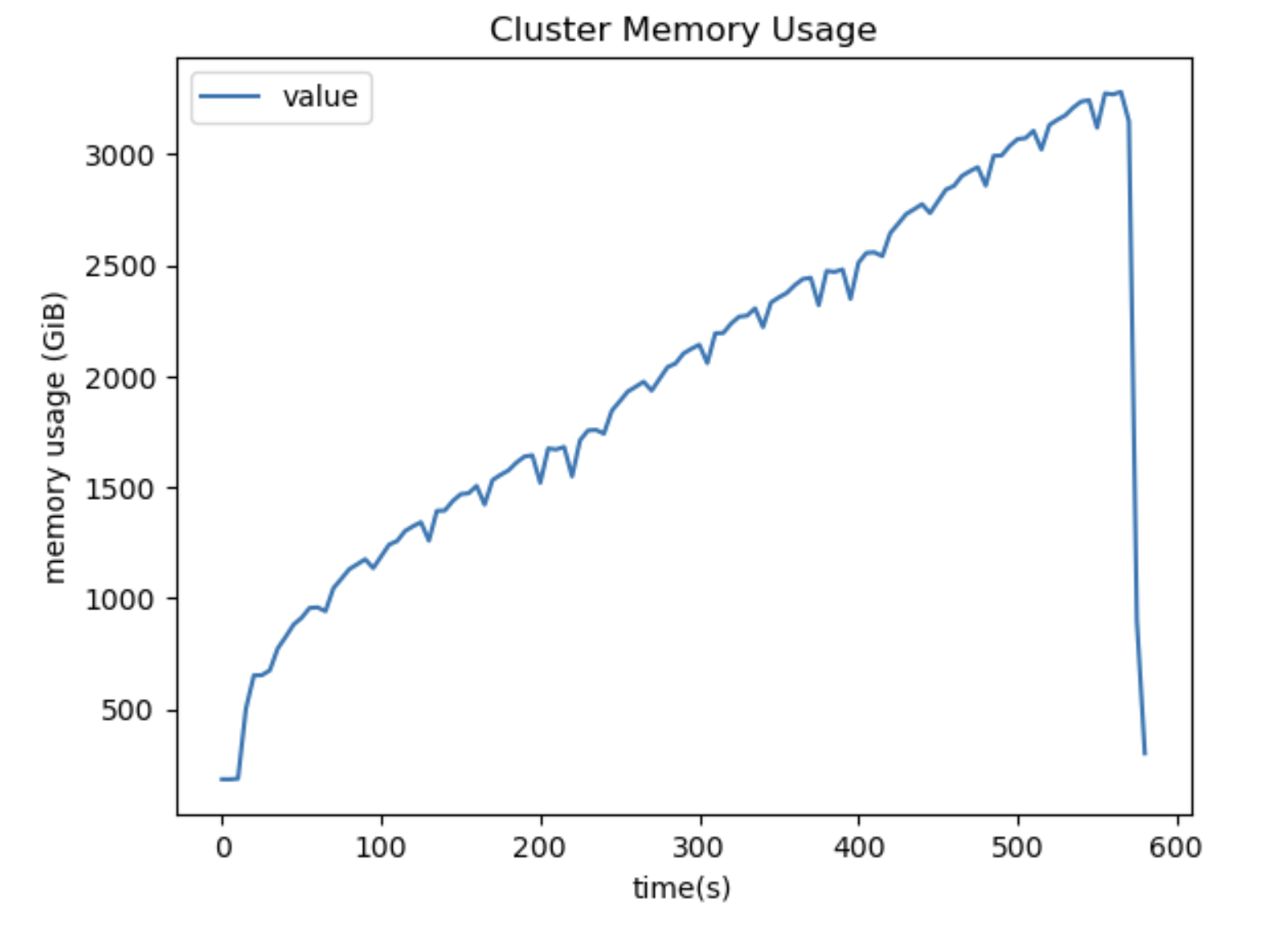

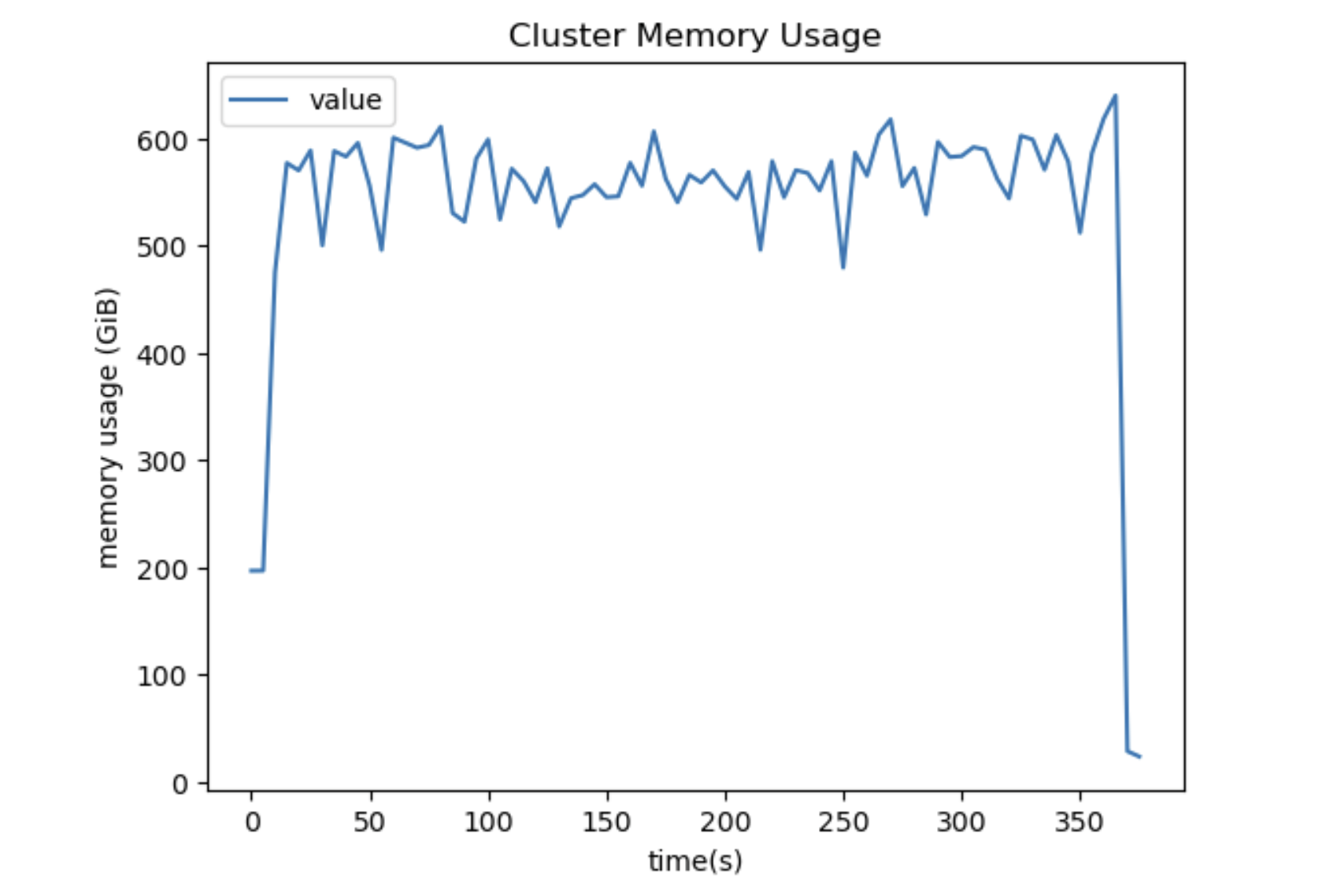

下面展示了一个简单的示例,我们比较了不同重新分块方法的性能。

shape = (30_000, 6_000, 150) # 201.17 GiB

input_chunks = (60, -1, -1) # 411.99 MiB

output_chunks = (-1, 6, -1) # 205.99 MiB

arr = da.random.random(size, chunks=input_chunks)

with dask.config.set({

"array.rechunk.method": "p2p",

"distributed.p2p.disk": True,

}):

(

da.random.random(size, chunks=input_chunks)

.rechunk(output_chunks)

.sum()

.compute()

)

详情请参见 crusaderky 的 GH#8282, GH#8318, GH#8321 以及 Hendrik Makait 的 (GH#8322)。

弃用 PyArrow <14.0.1¶

pyarrow<14.0.1 的使用从本版本开始已被弃用。建议所有用户升级他们的 pyarrow 版本或安装 pyarrow-hotfix。详情请参阅 此 CVE。

详情请参见 Florian Jetter 的 GH#10622。

改进了用于 Parquet 的 PyArrow 文件系统¶

在读取 Parquet 数据集时使用 filesystem="arrow" 现在可以正确推断访问远程云托管数据时的正确云区域。

详情请参见 Richard (Rick) Zamora 的 GH#10590。

改进P2P混洗中的类型协调¶

详情请参见 Hendrik Makait 的 GH#8332。

其他更改

将最小

click版本提升至>=8.1(GH#10623) Jacob Tomlinson避免碎片化 DataFrame 的

PerformanceWarning(GH#10621) Patrick Hoefler在GPU CI更新工作流中泛化计算

NEW_*_VER(GH#10610) Charles Blackmon-Luca切换到更新的 GPU CI 镜像 (GH#10608) Charles Blackmon-Luca

在

fsspec测试中移除双斜杠 (GH#10605) Mario Šaško重新启用

test_ucx_config_w_env_var(GH#8272) Peter Andreas Entschev在从网络接收时不共享

host_array(GH#8308) crusaderky在GPU CI更新工作流中泛化``NEW_*_VER``的计算 (GH#8319) Charles Blackmon-Luca

切换到更新的 GPU CI 镜像 (GH#8316) Charles Blackmon-Luca

对shuffle仪表板的小更新 (GH#8315) Matthew Rocklin

不要使用

bytearray().join(GH#8312) crusaderky在P2P哈希连接中重用相同的洗牌 (GH#8306) Hendrik Makait

2023.10.1¶

发布于2023年10月27日

亮点¶

Python 3.12¶

此版本正式添加了对 Python 3.12 的支持。

详情请参见 Thomas Grainger 的 GH#10544 和 GH#8223。

其他更改

避免过于激进地将parquet文件分割为行组 (GH#10600) Matthew Rocklin

加速

normalize_chunks以适应常见情况 (GH#10579) Martin Durant使用 Python 3.11 进行上游和 doctests CI 构建 (GH#10596) Thomas Grainger

将

actions/checkout从 4.1.0 升级到 4.1.1 (GH#10592)切换到 PyTables

HEAD(GH#10580) Thomas Grainger移除

numpy.core警告过滤器,链接至pyarrow引起的BlockManager警告 (GH#10571) Thomas Grainger取消忽略并修复已弃用的频率别名 (GH#10577) Thomas Grainger

将

register_assert_rewrite在conftest中提前以修复警告 (GH#10578) Thomas Grainger将

versioneer升级到 0.29 (GH#10575) Thomas Grainger将

test_concat_categorical改为非严格模式 (GH#10574) Thomas Grainger使用 NumPy 2.0 启用 SciPy 测试 Thomas Grainger

启用 scikit-image 的 NumPy 2.0 测试 (GH#10569) Thomas Grainger

修复上游构建 (GH#10549) Thomas Grainger

为

drop_duplicates添加优化的代码路径 (GH#10542) Richard (Rick) Zamora在

dd.DataFrame.sort_values中支持cudf后端 (GH#10551) Richard (Rick) Zamora将图表标签中的“GIL Contention”重命名为“GIL” (GH#8305) Matthew Rocklin

将

actions/checkout从 4.1.0 升级到 4.1.1 (GH#8299)修复仪表盘 (GH#8293) Hendrik Makait

@log_errors用于异步任务 (GH#8294) crusaderky为 serialize_bytes 添加注解和更好的测试 (GH#8300) crusaderky

暂时将

test_decide_worker_coschedule_order_neighbors标记为 xfail 以解除 CI 阻塞 (GH#8298) James Bourbeau在代码示例中跳过

xdist和matplotlib(GH#8290) Matthew Rocklin在

numpy>=2.dev0上使用numpy._core(GH#8291) Thomas Grainger修复

MemoryShardsBuffer.bytes_read的计算 (GH#8289) crusaderky允许 P2P 在内存中存储数据 (GH#8279) Hendrik Makait

将

versioneer升级到 0.29 (GH#8288) Thomas Grainger允许

ResourceLimiter无限制 (GH#8276) Hendrik Makait运行

pre-commit自动更新 (GH#8281) Thomas Grainger为P2P层注释实例变量 (GH#8280) Hendrik Makait

优雅地移除工作者不应将任务标记为可疑 (GH#8234) Thomas Grainger

为

dask spec添加信号处理 (GH#8261) Thomas Grainger为

sync添加类型标注 (GH#8275) Hendrik Makait更好的 shuffle offload 注解 (GH#8277) crusaderky

测试 p2p 洗牌的最小版本 (GH#8270) crusaderky

在测试失败时运行覆盖率 (GH#8269) crusaderky

使用

aiohttp与扩展 (GH#8274) Thomas Grainger

2023.10.0¶

发布于2023年10月13日

亮点¶

减少多数组缩减的内存压力¶

此版本包含了Dask任务图调度逻辑的主要更新。这些更新显著减少了数组缩减时的内存压力。我们预计这将对数组计算社区产生重大影响。

详情请参见 Florian Jetter 的 GH#10535。

改进的P2P洗牌鲁棒性¶

有几个更新(如下所列)使得P2P洗牌更加健壮,更不容易失败。

详情请参见 Hendrik Makait 的 GH#8262, GH#8264, GH#8242, GH#8244, 和 GH#8235,以及 Charles Blackmon-Luca 的 GH#8124。

减少大型图的调度器CPU负载¶

在计算大型任务图时,用户应在其调度程序上看到降低的CPU负载。

详情请参见 Florian Jetter 的 GH#8238 和 GH#10547 以及 crusaderky 的 GH#8240。

其他更改

分派用于基于磁盘的洗牌的

partd.Encode类 (GH#10552) Richard (Rick) Zamora添加Hive分区的文档 (GH#10454) Richard (Rick) Zamora

为

dask.order添加类型注解 (GH#10553) Florian Jetter允许在

dd.read_csv中传递index_col=False(GH#9961) Michael Leslie加强

HighLevelGraph注解 (GH#10524) crusaderky对最新

ipykernel/ipywidgets的支持 (GH#8253) crusaderky检查P2P合并的最小

pyarrow版本 (GH#8266) Hendrik Makait对 Python 3.12 的支持 (GH#8223) Thomas Grainger

在发送大图时使用

memoryview.nbytes进行警告 (GH#8268) crusaderky在没有

gilknocker的情况下运行测试 (GH#8263) crusaderky在 MacOS CI 上禁用 ipv6 (GH#8254) crusaderky

清理冗余的最小版本 (GH#8251) crusaderky

在调度器插件中清理

BARRIER_PREFIX的使用 (GH#8252) crusaderky改进P2P工作插件中的shuffle运行处理 (GH#8245) Hendrik Makait

显式设置

charset=utf-8(GH#8250) crusaderky对 GH#8239 (GH#8247) crusaderky 的输入调整

简化调度器断言 (GH#8246) crusaderky

改进打字(GH#8239)`Hendrik Makait`_

尊重 cgroups v2 的“低”内存限制 (GH#8243) Samantha Hughes

通过将其设为调度器插件来修复

PackageInstall(GH#8142) Hendrik MakaitXfail

test_ucx_config_w_env_var(GH#8241) crusaderkySpecCluster对损坏工作者的恢复能力 (GH#8233) crusaderky取消任务时抑制

SpillBuffer堆栈跟踪 (GH#8232) crusaderky在字符串化更改后更新注释 (GH#8195) crusaderky

减少配置文件的最大递归深度 (GH#8224) crusaderky

卸载深度嵌套的对象 (GH#8214) crusaderky

修复不稳定的

test_close_connections(GH#8231) crusaderky修复不稳定的

test_popen_timeout(GH#8229) crusaderky修复不稳定的

test_adapt_then_manual(GH#8228) crusaderky防止

SpillBuffer中的冲突 (GH#8226) crusaderky允许

retire_workers并发运行 (GH#8056) Florian Jetter修复

TaskState对象的 HTML 表示 (GH#8188) Florian Jetter修复

profile.py中builtin_function_or_method的AttributeError(GH#8181) Florian Jetter修复不稳定的

test_spans(v2) (GH#8222) crusaderky

2023年9月3日¶

发布于2023年9月29日

亮点¶

恢复以前的配置覆盖行为¶

2023.9.2 版本在 dask.config.get 中使用 override_with= 关键字覆盖配置选项的方式上引入了一个非预期的重大变化(参见 GH#10519)。此版本恢复了之前的行为。

详情请参见 crusaderky 的 GH#10521。

Dask 数组缩减中的复杂数据类型¶

此版本改进了在使用 Dask Array 中的常见归约操作(例如 var、std、moment)时对复杂数据类型的支持。

详情请参见 wkrasnicki 的 GH#10009。

其他更改

将

actions/checkout从 4.0.0 升级到 4.1.0 (GH#10532)匹配

pandas恢复apply弃用 (GH#10531) James Bourbeau将 gpuCI 的

RAPIDS_VER更新为23.12(GH#10526)使用

fsspec==2023.9.1暂时跳过失败的测试 (GH#10520) James Bourbeau

2023年9月2日¶

发布于2023年9月15日

亮点¶

当安装了过时的 PyArrow 时,P2P 混洗现在会引发错误¶

之前,如果安装了较旧版本的 pyarrow,默认的混洗方法会从点对点(P2P)混洗静默回退到基于任务的混洗。现在,我们会引发一个包含所需最低 pyarrow 版本的信息性错误,而不是静默回退。

详情请参见 Hendrik Makait 的 GH#10496。

admin.traceback.shorten 的弃用周期¶

2023.9.0 版本在没有引入弃用周期的情况下修改了 admin.traceback.shorten 配置选项。这导致在某些情况下无法创建 Dask 集群。此版本为此配置更改引入了弃用周期。

详情请参见 crusaderky 的 GH#10509。

其他更改

避免在

delayed任务中具体化所有迭代器 (GH#10498) James Bourbeau在

dask.config中彻底改革弃用系统 (GH#10499) crusaderky在

timeseries中移除不必要的检查 (GH#10447) Patrick Hoefler在测试中使用

register_plugin(GH#10503) James Bourbeau在

pyarrow_schema_dispatch中明确preserve_index(GH#10501) Hendrik Makait为

pyarrow_schema_dispatch添加**kwargs支持 (GH#10500) Hendrik Makait集中并输入

no_default(GH#10495) crusaderky

2023年9月1日¶

发布于2023年9月6日

备注

这是一个热修复版本,修复了2023.9.0版本中引入的P2P洗牌错误(参见 GH#10493)。

增强功能¶

更严格的dask键数据类型 (GH#10485) crusaderky

在

DASK_环境变量中对None的特殊处理 (GH#10487) crusaderky

Bug 修复¶

修复

DataFrame.set_index和DataFrame.sort_values中meta的_partitionsdtype(GH#10493) Hendrik Makait在

derived_from中处理cached_property装饰器 (GH#10490) Lawrence Mitchell

维护¶

将

actions/checkout从 3.6.0 升级到 4.0.0 (GH#10492)简化一些

import distributed的测试 (GH#10484) crusaderky

2023.9.0¶

发布于2023年9月1日

Bug 修复¶

移除对

np.int64在键中的支持 (GH#10483) crusaderky修复

meta中_partitions的dtype以进行洗牌 (GH#10462) Hendrik Makait不要使用异常钩子来缩短回溯 (GH#10456) crusaderky

文档¶

在 DataFrame 文档中添加

p2p洗牌选项 (GH#10477) Patrick Hoefler

维护¶

跳过

pandas=2.1.0的失败测试 (GH#10488) Patrick Hoefler更新

pandas=2.1.0的测试 (GH#10439) Patrick Hoefler启用

pytest-timeout(GH#10482) crusaderky将

actions/checkout从 3.5.3 升级到 3.6.0 (GH#10470)

2023年8月1日¶

发布于2023年8月18日

增强功能¶

为

cpu_count添加 cgroup v2 支持 (GH#10419) Johan Olsson支持多列

groupby并设置sort=True和split_out>1(GH#10425) Richard (Rick) Zamora添加

DataFrame.enforce_runtime_divisions方法 (GH#10404) Richard (Rick) Zamora启用文件

mode="x"并设置single_file=True以用于 Dask DataFrame 的to_csv(GH#10443) Genevieve Buckley

维护¶

为

pandas的from_pyarrow_table_dispatch添加默认的types_mapper(GH#10446) Richard (Rick) Zamora

2023.8.0¶

发布于2023年8月4日

增强功能¶

修复

make_timeseries性能回退 (GH#10428) Irina Truong

文档¶

将

distributed.print添加到调试文档 (GH#10435) James Bourbeau记录NumPy函数与Dask函数兼容性 (GH#9941) Chiara Marmo

维护¶

在

license元数据中使用 SPDX (GH#10437) John A Kirkham在

dask[dataframe]中要求dask[array](GH#10357) John A Kirkham将 gpuCI 的

RAPIDS_VER更新为23.10(GH#10427)简化兼容性代码 (GH#10426) Hendrik Makait

修复兼容性变量命名 (GH#10424) Hendrik Makait

修复了上游

pandas和pyarrow的一些错误 (GH#10412) Irina Truong

2023年7月1日¶

发布于2023年7月20日

备注

此版本更新了 Dask DataFrame,如果安装了 pandas>=2 和 pyarrow>=12,将自动将使用 object 数据类型的文本数据转换为 string[pyarrow]。

这将显著减少处理文本数据的工作流中的内存消耗,并提高计算性能。

你可以通过将 dataframe.convert-string 配置值设置为 False 来禁用此更改。

dask.config.set({"dataframe.convert-string": False})

增强功能¶

如果安装了适当的依赖项,则转换为

pyarrow字符串 (GH#10400) James Bourbeau在

p2p的shuffle之前避免repartition(GH#10421) Patrick Hoefler生成随机 Dask DataFrame 的 API (GH#10392) Irina Truong

加速

dask.bag.Bag.random_sample(GH#10356) crusaderky为无效的时间单位引发有帮助的

ValueError(GH#10408) Nat Tabris当分区匹配时(分区作为列表提供),使

repartition成为无操作 (GH#10395) Nicolas Grandemange

Bug 修复¶

在

read_parquet令牌中使用dataframe.convert-string(GH#10411) James Bourbeau在连接

MultiIndex时,类别dtype会丢失 (GH#10407) Irina Truong修复

FutureWarning: 提供的可调用对象...(GH#10405) Irina Truong在

read_parquet中启用非分类的 hive-partition 列 (GH#10353) Richard (Rick) Zamoraconcat忽略没有列的DataFrame(GH#10359) Patrick Hoefler

2023.7.0¶

发布于2023年7月7日

增强功能¶

在尝试加载CLI入口点时捕获异常 (GH#10380) Jacob Tomlinson

Bug 修复¶

修复

_clean_ipython_traceback中的拼写错误 (GH#10385) Alexander Clausen确保

df在from_pandas之后是不可变的 (GH#10383) Patrick Hoefler在

Series.rename中一致地警告inplace(GH#10313) Patrick Hoefler

文档¶

在rechunk文档中添加关于输出形状和重塑的说明 (GH#10377) Swayam Patil

维护¶

简化

astype实现 (GH#10393) Patrick Hoefler修复

test_first_and_last以适应已弃用的last(GH#10373) James Bourbeau在

create_merge_tree中添加level(GH#10391) Patrick Hoefler不要从

scipy.stats.chisquare文档字符串派生 (GH#10382) Doug Davis

2023.6.1¶

发布于2023年6月26日

增强功能¶

移除不再支持的

clip_lower和clip_upper(GH#10371) Patrick Hoefler清理远程回溯 (GH#10354) Irina Truong

为

pyarrow.Table转换添加调度机制 (GH#10312) Richard (Rick) Zamora即使启用了融合,也选择P2P (GH#10344) Hendrik Makait

在图生成过程中尽早验证重新分块的可能性 (GH#10336) Hendrik Makait

Bug 修复¶

修复了传递给

read_csv的header问题 (GH#10355) GALI PREM SAGAR在

GroupBy.var和GroupBy.std中尊重dropna和observed(GH#10350) Patrick Hoefler修复在分布式客户端写入hdf时出现的

H5FD_lock错误 (GH#10309) Irina Truong修复

bag.map()的total_mem_usage(GH#10341) Irina Truong

弃用¶

弃用

DataFrame.fillna/Series.fillna的method参数 (GH#10349) Irina Truong弃用

DataFrame.first和Series.first(GH#10352) Irina Truong

维护¶

弃用

numpy.compat(GH#10370) Irina Truong修复线程间注释和跨度泄漏的问题 (GH#10367) Irina Truong

在

pyarrow_table_dispatch函数中使用通用 kwargs (GH#10364) Richard (Rick) Zamora移除

isna中不必要的try/except(GH#10363) Patrick Hoeflermypy对 numpy 1.25 的支持 (GH#10362) crusaderky将

actions/checkout从 3.5.2 升级到 3.5.3 (GH#10348)在

upstream构建中恢复numba(GH#10330) James Bourbeau更新

pandas/numpy/scipy的夜间轮子索引 (GH#10346) Matthew Roeschke在yaml中添加rechunk配置值(GH#10343)`Hendrik Makait`_

2023.6.0¶

发布于2023年6月9日

增强功能¶

为

read_parquet添加缺失的not in谓词支持 (GH#10320) Richard (Rick) Zamora

Bug 修复¶

修复

value_counts的错误 (GH#10323) Irina Truong更新空的

describe顶部和频率值 (GH#10319) James Bourbeau

文档¶

修复 hetzner 拼写错误 (GH#10332) Sarah Charlotte Johnson

维护¶

在 Python 3.11 上使用

numba和sparse进行测试 (GH#10329) Thomas Grainger移除

numpy.find_common_type警告忽略 (GH#10311) James Bourbeau将 gpuCI 的

RAPIDS_VER更新为23.08(GH#10310)

2023年5月1日¶

发布于2023年5月26日

备注

此版本放弃了对 Python 3.8 的支持。自此版本起,Dask 支持 Python 3.9、3.10 和 3.11。更多详情请参见 此社区问题。

增强功能¶

放弃对 Python 3.8 的支持 (GH#10295) Thomas Grainger

更改 Dask Bag 分区方案以提高集群饱和度 (GH#10294) Jacob Tomlinson

为GPU支持的集合泛化

dd.to_datetime,引入get_meta_library实用工具 (GH#9881) Charles Blackmon-Luca将

na_action添加到DataFrame.map(GH#10305) Patrick Hoefler在

DataFrame.nsmallest和DataFrame.nlargest中,当未给出columns时引发TypeError(GH#10301) Patrick Hoefler改进

pd.MultiIndex的sizeof(GH#10230) Patrick Hoefler在一系列

DataFrame方法中支持重复的列 (GH#10261) Patrick Hoefler为

DataFrame.idxmin和DataFrame.idxmax添加numeric_only支持 (GH#10253) Patrick Hoefler为

DataFrame.quantile实现numeric_only支持 (GH#10259) Patrick Hoefler在

DataFrame.std中添加对numeric_only=False的支持 (GH#10251) Patrick Hoefler为

GroupBy.cumprod和GroupBy.cumsum实现numeric_only=False(GH#10262) Patrick Hoefler为

skew和kurtosis实现numeric_only(GH#10258) Patrick Hoeflermask和where应该接受一个callable(GH#10289) Irina Truong修复

read_parquet中从Categorical到pa.dictionary的转换 (GH#10285) Patrick Hoefler

Bug 修复¶

嵌套注解上的虚假配置 (GH#10318) crusaderky

修复已知和未知块大小的维度的重新分块行为 (GH#10157) Hendrik Makait

启用

drop以支持不匹配的分区 (GH#10300) James Bourbeau修复

to_timestamp的divisions构造 (GH#10304) Patrick Hoeflerpandas

ExtensionDtype在Series归约操作中引发 (GH#10149) Patrick Hoefler修复

da.random接口中的回归问题 (GH#10247) Eray Aslanda.coarsen不会修剪元数据中的空块 (GH#10281) Irina Truong修复了

read_csv中engine="pyarrow"的 dtype 推断问题 (GH#10280) Patrick Hoefler

文档¶

将

meta_from_array添加到 API 文档 (GH#10306) Ruth Comer更新 Coiled 链接 (GH#10296) Sarah Charlotte Johnson

为演示日添加文档 (GH#10288) Matthew Rocklin

维护¶

在上传conda nightly版本时,从conda-forge显式安装

anaconda-client(GH#10316) Charles Blackmon-Luca配置

isort以添加from __future__ import annotations(GH#10314) Thomas Grainger避免在测试中使用

pandasSeries.__getitem__的弃用 (GH#10308) James Bourbeau忽略来自

pandas的numpy.find_common_type警告 (GH#10307) James Bourbeau添加测试以检查

DataFrame.__setitem__不会就地修改df(GH#10223) Patrick Hoefler在

value_counts中清理dropna的默认值 (GH#10299) Patrick Hoefler将

pytest-cov添加到test额外功能中 (GH#10271) James Bourbeau

2023.5.0¶

发布于2023年5月12日

增强功能¶

为

GroupBy.corr和GroupBy.cov实现numeric_only=False(GH#10264) Patrick Hoefler在

DataFrame.var中添加对numeric_only=False的支持 (GH#10250) Patrick Hoefler为

DataFrame.mode添加numeric_only支持 (GH#10257) Patrick Hoefler将

DataFrame.map添加到dask.DataFrameAPI (GH#10246) Patrick Hoefler调整

DataFrame.applymap的弃用和所有NAconcat行为变化 (GH#10245) Patrick Hoefler为

DataFrame.count启用numeric_only=False(GH#10234) Patrick Hoefler在掩码/条件中禁止数组输入 (GH#10163) Irina Truong

在

GroupBy.corr和GroupBy.cov中支持numeric_only=True(GH#10227) Patrick Hoefler为

GroupBy.median添加numeric_only支持 (GH#10236) Patrick Hoefler在

dask.datasets中支持mimesis=9(GH#10241) James Bourbeau为

min,max和prod添加numeric_only支持 (GH#10219) Patrick Hoefler为

GroupBy.cumsum和GroupBy.cumprod添加numeric_only=True支持 (GH#10224) Patrick Hoefler添加助手以解包

numeric_only关键字 (GH#10228) Patrick Hoefler

Bug 修复¶

修复

clone+from_array失败 (GH#10211) crusaderky修复ea dtypes的数据框缩减 (GH#10150) Patrick Hoefler

避免在

numpy=1.25中的标量转换弃用警告 (GH#10248) James Bourbeau确保转换输出与输入具有相同的索引 (GH#10184) Irina Truong

修复单行分区上的

corr和cov(GH#9756) Irina Truong修复

test_groupby_numeric_only_supported和test_groupby_aggregate_categorical_observed的上游错误 (GH#10243) Irina Truong

文档¶

清理未来文档 (GH#10266) Matthew Rocklin

维护¶

当meta传递给``apply``时发出警告(GH#10256)`Patrick Hoefler`_

在CI中移除

imageio版本限制 (GH#10260) Patrick Hoefler移除未使用的

DataFrame方差方法 (GH#10252) Patrick Hoefler取消

xfailtest_categories与pyarrow字符串和pyarrow>=12(GH#10244) Irina Truong将 gpuCI

PYTHON_VER从 3.8 升级到 3.9 (GH#10233) Charles Blackmon-Luca

2023年4月1日¶

发布于2023年4月28日

增强功能¶

为

DataFrame.sum实现numeric_only支持 (GH#10194) Patrick Hoefler在

GroupBy操作中添加对numeric_only=True的支持 (GH#10222) Patrick Hoefler在

pandas1.4 及以上版本中避免在DataFrame.__setitem__中进行深层复制 (GH#10221) Patrick Hoefler避免使用

Series.apply调用_meta_nonempty(GH#10212) Patrick Hoefler取消固定

sqlalchemy并修复兼容性问题 (GH#10140) Patrick Hoefler

Bug 修复¶

部分恢复默认客户端发现 (GH#10225) Florian Jetter

在

Index元创建中支持箭头数据类型 (GH#10170) Patrick Hoefler在截断浮点数时,重新分区会引发扩展数据类型的错误 (GH#10169) Patrick Hoefler

将

fastparquet中的空Index调整为object数据类型 (GH#10179) Patrick Hoefler

文档¶

更新 Kubernetes 文档 (GH#10232) Jacob Tomlinson

将

DataFrame.reduction添加到 API 文档 (GH#10229) James Bourbeau在文档中添加

DataFrame.persist并修复链接 (GH#10231) Patrick Hoefler为

GroupBy.transform添加文档 (GH#10185) Irina Truong修复随机数生成文档中的格式问题 (GH#10189) Eray Aslan

维护¶

将 imageio 固定在

<2.28(GH#10216) Patrick Hoefler关于

importlib_metadata回传的注释 (GH#10207) James Bourbeau将

xarray添加回 Python 3.11 CI 构建 (GH#10200) James Bourbeau添加

mindeps构建,包含所有可选依赖 (GH#10161) Charles Blackmon-Luca在

percentiles_summary中为array_safe提供适当的like值 (GH#10156) Charles Blackmon-Luca避免在

read_hdf中多次重新打开 hdf 文件 (GH#10205) Thomas Grainger在可空列上添加合并测试 (GH#10071) Charles Blackmon-Luca

修复覆盖率配置 (GH#10203) Thomas Grainger

移除

is_period_dtype和is_sparse_dtype(GH#10197) Patrick Hoefler将

actions/checkout从 3.5.0 升级到 3.5.2 (GH#10201)避免使用 pandas 中已弃用的

is_categorical_dtype(GH#10180) Patrick Hoefler调整已弃用的

is_interval_dtype和is_datetime64tz_dtype(GH#10188) Patrick Hoefler

2023.4.0¶

发布于2023年4月14日

增强功能¶

在

update_defaults中覆盖旧的默认值 (GH#10159) Gabe Joseph添加一个CLI命令来

list和getdask配置中的值 (GH#9936) Irina Truong处理基于字符串的引擎参数到

read_json(GH#9947) Richard (Rick) Zamora避免使用已弃用的

GroupBy.dtypes(GH#10111) Irina Truong

Bug 修复¶

恢复

grouper相关更改 (GH#10182) Irina TruongGroupBy.cov对非数值分组列引发异常 (GH#10171) Patrick Hoefler更新支持

numpy数值数据类型的Index(GH#10154) Irina Truong在使用

pyarrow读取时,保留分区列的dtype(GH#10115) Patrick Hoefler修复

to_hdf的注释 (GH#10123) Hendrik Makait在检查列是否全为数值时处理

None列名 (GH#10128) Lawrence Mitchell修复

valid_divisions当传入tuple时的问题 (GH#10126) Brian Phillips在

DataFrame.categorize中维护注解 (GH#10120) Hendrik Makait修复在过滤过程中处理缺失的 parquet 最小/最大统计信息的问题 (GH#10042) Richard (Rick) Zamora

弃用¶

弃用

use_nullable_dtypes=并添加dtype_backend=(GH#10076) Irina Truong在

Series.apply中弃用convert_dtype(GH#10133) Irina Truong

文档¶

基于文档

Generator的随机数生成 (GH#10134) Eray Aslan

维护¶

将

dataframe.convert_string更新为dataframe.convert-string(GH#10191) Irina Truong将

python-cityhash添加到 CI 环境中 (GH#10190) Charles Blackmon-Luca暂时固定

scikit-image以修复 Windows CI (GH#10186) Patrick Hoefler处理

to_pydatetime和apply的 pandas 弃用警告 (GH#10168) Patrick Hoefler移除

bokeh<3限制 (GH#10177) James Bourbeau修复写时复制下的失败测试 (GH#10173) Patrick Hoefler

允许

pyarrowCI 失败 (GH#10176) James Bourbeau在

dask.array中切换到Generator以进行随机数生成 (GH#10003) Eray Aslan将

peter-evans/create-pull-request从 4 升级到 5 (GH#10166)修复

test_arithmetic中的modf操作不稳定问题 (GH#10162) Irina Truong暂时从CI中移除

xarray与pandas2.0 (GH#10153) James Bourbeau修复

test_default_scheduler_on_worker中的update_graph计数逻辑 (GH#10145) James Bourbeau修复

pandas2.0 的文档构建 (GH#10138) James Bourbeau从 gpuCI 更新审核者中移除

dask/gpu(GH#10135) Charles Blackmon-Luca将 gpuCI 的

RAPIDS_VER更新为23.06(GH#10129)将

actions/stale从 6 升级到 8 (GH#10121)使用声明式的

setuptools(GH#10102) Thomas Grainger放松对

Scalar类对象的assert_eq检查 (GH#10125) Matthew Rocklin将 readthedocs 配置升级到 ubuntu 22.04 和 Python 3.11 (GH#10124) Thomas Grainger

将

actions/checkout从 3.4.0 升级到 3.5.0 (GH#10122)修复

pyarrowCI 构建中的test_null_partition_pyarrow(GH#10116) Irina Truong删除分布式包 (GH#9988) Florian Jetter

将

dask.compatibility设为私有 (GH#10114) Jacob Tomlinson

2023年3月2日¶

发布于2023年3月24日

增强功能¶

弃用

groupby中分类数据的observed=False(GH#10095) Irina Truong弃用某些 groupby 操作中的

axis=参数 (GH#10094) James Bourbeau在

DataFrame.rolling/Series.rolling中的axis关键字已被弃用 (GH#10110) Irina TruongDataFrame._data在pandas中的弃用 (GH#10081) Irina Truong使用

importlib_metadata回退以避免 CLIUserWarning(GH#10070) Thomas Grainger将

dask.dataframe.read_parquet的端口选项解析逻辑移植到to_parquet(GH#9981) Anton Loukianov

Bug 修复¶

避免在 groupby-apply 中使用

dd.shuffle(GH#10043) Richard (Rick) Zamora使用

pyarrowparquet 引擎启用空 hive 分区 (GH#10007) Richard (Rick) Zamora在

*_like函数中支持未知形状 (GH#10064) Doug Davis

文档¶

在API文档中添加

to_backend方法 (GH#10093) Lawrence Mitchell在开发者文档中移除损坏的gpuCI链接 (GH#10065) Charles Blackmon-Luca

维护¶

将 readthedocs sphinx 警告配置为错误 (GH#10104) Thomas Grainger

取消

xfailtest_division_or_partition的pyarrow字符串激活 (GH#10108) Irina Truong取消

xfailtest_different_columns_are_allowed,当pyarrow字符串激活时 (GH#10109) Irina Truong恢复 Entrypoints 兼容性 (GH#10113) Jacob Tomlinson

取消

xfailtest_to_dataframe_optimize_graph并激活pyarrow字符串 (GH#10087) Irina Truong仅在可编辑安装时运行

test_development_guidelines_matches_ci(GH#10106) Charles Blackmon-Luca取消

xfailtest_dataframe_cull_key_dependencies_materialized,当pyarrow字符串激活时 (GH#10088) Irina Truong在CI环境中安装

mimesis(GH#10105) Charles Blackmon-Luca修复未找到模块

ipykernel的问题 (GH#10101) Irina Truong通过安装

ipykernel修复文档构建 (GH#10103) Thomas Grainger允许

pyarrow在失败时继续构建 (GH#10097) James Bourbeau将

actions/checkout从 3.3.0 升级到 3.4.0 (GH#10096)修复

test_set_index_on_empty在pyarrow字符串激活时的问题 (GH#10054) Irina Truong取消

xfailpyarrow序列化测试 (GH#10082) James BourbeauCI 环境文件清理 (GH#10078) James Bourbeau

取消

xfail更多pyarrow测试 (GH#10066) Irina Truong暂时跳过

pyarrow_compat测试与 pandas 2.0 (GH#10063) James Bourbeau修复

test_melt在pyarrow字符串激活时的问题 (GH#10052) Irina Truong修复

test_str_accessor在pyarrow字符串激活时的问题 (GH#10048) James Bourbeau修复

test_better_errors_object_reductions在pyarrow字符串激活时的问题 (GH#10051) James Bourbeau修复

test_loc_with_non_boolean_series在pyarrow字符串激活时的问题 (GH#10046) James Bourbeau修复

test_values在pyarrow字符串激活时的问题 (GH#10050) James Bourbeau暂时

xfailtest_upstream_packages_installed(GH#10047) James Bourbeau

2023年3月1日¶

发布于2023年3月10日

增强功能¶

在

MultiIndex中支持 pyarrow 字符串 (GH#10040) Irina Truong改进了对

pyarrow字符串的支持 (GH#10000) Irina Truong修复数组缩减期间的不稳定

RuntimeWarning(GH#10030) James Bourbeau扩展

complete额外功能 (GH#10023) James Bourbeau使用

dataframe.convert-string=True和pandas<2.0时引发错误 (GH#10033) Irina Truong将 shuffle/rechunk 配置选项/关键字参数重命名为

method(GH#10013) James Bourbeau添加对将

pandas扩展数据类型转换为数组的初始支持 (GH#10018) James Bourbeau移除

randomgen支持 (GH#9987) Eray Aslan

Bug 修复¶

当重新分块到相同大小的未知大小时跳过分块 (GH#10027) Hendrik Makait

自定义工具将 parquet 过滤器转换为

pyarrow表达式 (GH#9885) Richard (Rick) Zamora在填充时将

numpy标量和 0d 数组视为标量 (GH#9653) Justus Magin在自适应

read_parquet操作后修复 parquet 覆盖行为 (GH#10002) Richard (Rick) Zamora

维护¶

从

pyarrowparquet 引擎中移除过时的 hive-partitioning 代码 (GH#10039) Richard (Rick) Zamora将最小支持的

pyarrow提升至 7.0 (GH#10024) James Bourbeau恢复“准备丢弃 packunpack (GH#9994) (GH#10037) Florian Jetter”

在报告前让 codecov 等待更多构建 (GH#10031) James Bourbeau

准备 drop packunpack (GH#9994) Florian Jetter

添加启用

pyarrow字符串的 CI 作业 (GH#10017) James Bourbeau修复

pandas2.0 的test_groupby_dropna_with_agg(GH#10001) Irina Truong修复

pandas2.0 的test_pickle_roundtrip(GH#10011) James Bourbeau

2023.3.0¶

发布于2023年3月1日

Bug 修复¶

Bag 不能将 p2p 作为 shuffle 的默认设置 (GH#10005) Florian Jetter

文档¶

默认P2P的小跟进 (GH#10008) James Bourbeau

维护¶

为可选的

jinja2依赖添加最低版本 (GH#9999) Charles Blackmon-Luca

2023年2月1日¶

发布于2023年2月24日

备注

此版本将默认的 DataFrame 洗牌算法更改为 p2p,以提高稳定性和性能。在此了解更多,并请在 此讨论 中提供任何反馈。

如果你在使用这个新算法时遇到问题,请参阅 文档 以获取更多信息,以及如何切换回旧模式。

增强功能¶

默认启用P2P混洗 (GH#9991) Florian Jetter

P2P 重新分块 (GH#9939) Hendrik Makait

为 read_parquet 提供高效的 dataframe.convert-string 支持 (GH#9979) Irina Truong

允许 DataFrame 合并的 p2p 洗牌关键字参数 (GH#9900) Florian Jetter

将

split_row_groups的默认值更改为“infer” (GH#9637) Richard (Rick) Zamora添加将字符串数据转换为使用

pyarrow字符串的选项 (GH#9926) James Bourbeau添加对多列

sort_values的支持 (GH#8263) Charles Blackmon-Lucadask.array中的Generator基于随机数生成 (GH#9038) Eray Aslan支持

pandas2.0 兼容性的简单 groupby 聚合的numeric_only(GH#9889) Irina Truong

Bug 修复¶

修复分析器图表未与上下文管理器进入时间对齐的问题 (GH#9739) David Hoese

放松 dask.dataframe assert_eq 类型检查 (GH#9989) Matthew Rocklin

为

pandas2.0 恢复describe兼容性 (GH#9982) James Bourbeau

文档¶

改进 Dask 文档的部署 (GH#9912) Sarah Charlotte Johnson

更多关于

DataFrame.partitions的文档 (GH#9976) Tom Augspurger更新文档,增加关于默认延迟调度器 (GH#9903) 的更多信息 Guillaume Eynard-Bontemps

部署考虑文档 (GH#9933) Gabe Joseph

维护¶

暂时重新运行不稳定测试 (GH#9983) James Bourbeau

更新 FULL_RAPIDS_VER/FULL_UCX_PY_VER 的解析 (GH#9990) Charles Blackmon-Luca

将最低支持版本提升至

pandas=1.3和numpy=1.21(GH#9950) James Bourbeau修复

std以与pandas2.0 的numeric_only一起工作 (GH#9960) Irina Truong暂时

xfailtest_roundtrip_partitioned_pyarrow_dataset(GH#9977) James Bourbeau修复 test_idxmaxmin 中的写时复制失败 (GH#9944) Patrick Hoefler

更新

pre-commit版本 (GH#9955) crusaderky修复

pandas2.0 的test_groupby_unaligned_index(GH#9963) Irina Truong取消

xfailtest_set_index_overlap_2对于pandas2.0 (GH#9959) James Bourbeau修复

pandas2.0 的test_merge_by_index_patterns(GH#9930) Irina Truong将 jacobtomlinson/gha-find-replace 从 2 升级到 3 (GH#9953) James Bourbeau

修复

test_rolling_agg_aggregate以兼容pandas2.0 (GH#9948) Irina Truong将

black更新到23.1.0(GH#9956) crusaderky在 Python 3.8 和 3.10 上运行 GPU 测试 (GH#9940) Charles Blackmon-Luca

修复

pandas2.0 的test_to_timestamp(GH#9932) Irina Truong修复

groupbyvalue_counts在pandas2.0 兼容性中的错误 (GH#9928) Irina Truong配置转换器:将所有短横线替换为下划线 (GH#9945) Jacob Tomlinson

CI: 在上游测试构建中使用 nightly wheel 安装 pyarrow (GH#9873) Joris Van den Bossche

2023.2.0¶

发布于2023年2月10日

增强功能¶

在

pandas2.0 中更新quantile的numeric_only默认值 (GH#9854) Irina Truong当分区匹配时,使

repartition成为无操作(GH#9924) James Bourbeau在

pandas2.0 中更新describe的datetime_is_numeric行为 (GH#9868) Irina Truong更新

value_counts以在pandas2.0 中返回正确的名称 (GH#9919) Irina Truong在

pandas2.0 中支持新的axis=None行为用于某些归约操作 (GH#9867) James Bourbeau在

nanmin和nanmax的块级别过滤掉所有-nanRuntimeWarning(GH#9916) Julia Signell修复

pandas2.0 的数值meta_nonempty索引creation(GH#9908) James Bourbeau修复

pandas2.0 的DataFrame.info()测试 (GH#9909) James Bourbeau

Bug 修复¶

修复

GroupBy.value_counts对多个groupby列的处理 (GH#9905) Charles Blackmon-Luca

文档¶

修复开发指南中的一些过时信息/拼写错误 (GH#9893) Patrick Hoefler

在

drop_duplicates文档字符串中添加关于keep=False的注释 (GH#9887) Jayesh Manani为 dask 数组添加

meta详细信息 (GH#9886) Jayesh Manani澄清任务流显示的行数多于线程数 (GH#9906) Gabe Joseph

维护¶

修复

pandas2.0 的test_numeric_column_names(GH#9937) Irina Truong修复

pandas2.0 的dask/dataframe/tests/test_utils_dataframe.py测试 (GH#9788) James Bourbeau将

index.is_numeric替换为is_any_real_numeric_dtype以兼容pandas2.0 (GH#9918) Irina Truong避免在dask工具中导入``pd.core`` (GH#9907) Matthew Roeschke

在拉取请求上使用标签进行

upstream构建 (GH#9910) James Bourbeau扩展对

sqlalchemy.exc.RemovedIn20Warning的异常捕获 (GH#9904) James Bourbeau在CI中暂时限制

sqlalchemy < 2(GH#9897) James Bourbeau将

isort版本更新至 5.12.0 (GH#9895) Lawrence Mitchell在

read_csv中移除未使用的skiprows变量 (GH#9892) Patrick Hoefler

2023年1月1日¶

发布于2023年1月27日

增强功能¶

在

Array和_Frame中添加to_backend方法 (GH#9758) Richard (Rick) Zamorapandas2.0 中时间戳索引分区的微小修复 (GH#9872) Irina Truong将

numeric_only添加到DataFrame.cov和DataFrame.corr(GH#9787) James Bourbeau修复了

pandas2.0 中group_keys默认值更改的相关问题 (GH#9855) Irina Truonginfer_datetime_format对pandas2.0 的兼容性 (GH#9783) James Bourbeau

Bug 修复¶

修复

BroadcastJoinLayer中的序列化错误 (GH#9871) Richard (Rick) Zamora在

DataFrame.merge中满足broadcast参数 (GH#9852) Richard (Rick) Zamora

文档¶

修复“重复的显式目标名称”文档警告 (GH#9863) Chiara Marmo

修复“定义新的集合后端”文档中的代码格式问题 (GH#9864) Chiara Marmo

更新内存图表的仪表板文档 (GH#9768) Jayesh Manani

添加关于

no-worker任务的文档部分 (GH#9839) Florian Jetter

维护¶

检测

distributed调度器的额外更新 (GH#9890) James Bourbeau将 gpuCI 的

RAPIDS_VER更新为23.04(GH#9876)集合与

distributed默认值之间的反向优先级 (GH#9869) Florian Jetter更新

xarray-contrib/issue-from-pytest-log到版本 1.2.6 (GH#9865) James Bourbeau不需要dask配置shuffle默认值 (GH#9826) Florian Jetter

取消

xfaildatetime64Parquet 往返测试以适应新的fastparquet(GH#9811) James Bourbeau添加选项以手动运行

upstreamCI 构建 (GH#9853) James Bourbeau在CI构建中使用自定义超时 (GH#9844) James Bourbeau

从

make_blockwise_graph中移除kwargs(GH#9838) Florian Jetter在

test_setitem_extended_API_2d_mask中忽略persist调用的警告 (GH#9843) Charles Blackmon-Luca修复本地运行S3测试 (GH#9833) James Bourbeau

2023.1.0¶

发布于2023年1月13日

增强功能¶

即使没有设置配置,也使用

distributed默认客户端 (GH#9808) Florian Jetter实现

ma.where和ma.nonzero(GH#9760) Erik Holmgren更新

zarr存储创建函数 (GH#9790) Ryan Abernatheyiteritems对pandas2.0 的兼容性 (GH#9785) James Bourbeau为

pandas的string[python]dtype 提供准确的sizeof(GH#9781) crusaderky压缩重复引用 pandas 对象类型的

sizeof()(GH#9776) crusaderkyGroupBy.__getitem__对pandas2.0 的兼容性 (GH#9779) James Bourbeauappend对pandas2.0 的兼容性 (GH#9750) James Bourbeauget_dummies对pandas2.0 的兼容性 (GH#9752) James Bourbeauis_monotonic对pandas2.0 的兼容性 (GH#9751) James Bourbeaunumpy=1.24兼容性 (GH#9777) James Bourbeau

文档¶

删除

to_json文档字符串中重复的encoding关键字参数 (GH#9796) Sultan Orazbayev在

LocalCluster文档中提及SubprocessCluster(GH#9784) Hendrik Makait将 Prometheus 文档移动到

dask/distributed(GH#9761) crusaderky

维护¶

在

test_setitem_extended_API_2d_mask中暂时忽略RuntimeWarning(GH#9828) James Bourbeau修复不稳定的

test_threaded.py::test_interrupt(GH#9827) Hendrik Makait在

upstream报告中更新xarray-contrib/issue-from-pytest-log(GH#9822) James Bourbeau在gpuCI构建中安装``pip`` dask (GH#9816) Charles Blackmon-Luca

将

actions/checkout从 3.2.0 升级到 3.3.0 (GH#9815)解决

mindeps测试中的sqlalchemy导入失败问题 (GH#9809) Charles Blackmon-Luca忽略

sqlalchemy.exc.RemovedIn20Warning(GH#9801) Thomas Graingerxfaildatetime64对pandas2.0 的 Parquet 往返测试 (GH#9786) James Bourbeau减少预期 DoK 稀疏矩阵的大小 (GH#9775) Elliott Sales de Andrade

从

dask/dataframe/io/orc/utils.py中移除可执行标志 (GH#9774) Elliott Sales de Andrade

2022.12.1¶

发布于2022年12月16日

增强功能¶

支持

dtype_backend="pandas|pyarrow"配置 (GH#9719) James Bourbeau在

dask.dataframe中支持cupy.ndarray到cudf.DataFrame的分发 (GH#9579) Richard (Rick) Zamora在

read_parquet中使文件系统后端可配置 (GH#9699) Richard (Rick) Zamora高效序列化所有

pyarrow扩展数组 (GH#9740) James Bourbeau

Bug 修复¶

修复在重新分区时使用

tz感知型 datetime 索引的错误 (GH#9741) James Bourbeau聚合中的部分函数可能具有参数 (GH#9724) Irina Truong

添加对

pyarrow支持的扩展数据类型的简单操作支持 (GH#9717) James Bourbeau在

SeriesGroupby情况下正确重命名列 (GH#9716) Lawrence Mitchell

文档¶

更新 Prometheus 文档 (GH#9696) Hendrik Makait

维护¶

将

zarr添加到 Python 3.11 CI 环境 (GH#9771) James Bourbeau添加对 Python 3.11 的支持 (GH#9708) Thomas Grainger

将

actions/checkout从 3.1.0 升级到 3.2.0 (GH#9753)避免

np.bool8弃用警告 (GH#9737) James Bourbeau确保在

upstreamCI 构建中不会覆盖开发包 (GH#9731) James Bourbeau在测试期间避免添加

data.h5和mydask.html文件 (GH#9726) Thomas Grainger

2022.12.0¶

于2022年12月2日发布

增强功能¶

从

read_parquet中移除基于统计的set_index逻辑 (GH#9661) Richard (Rick) Zamora为

dd.read_parquet添加use_nullable_dtypes支持 (GH#9617) Ian Rose修复

map_overlap以接受 pandas 参数 (GH#9571) Fabien Aulaire修复 pandas 1.5+ 在

.str.split(..., expand=True)中的FutureWarning(GH#9704) Jacob Hayes为

groupby切片启用列投影 (GH#9667) Richard (Rick) Zamora改进失败的backend调度调用的错误信息 (GH#9677) Richard (Rick) Zamora

Bug 修复¶

在arrow parquet引擎中修订元创建 (GH#9672) Richard (Rick) Zamora

修复

da.fft.fft以支持类数组输入 (GH#9688) James Bourbeau修复

groupby在按名称分组索引时的聚合 (GH#9646) Richard (Rick) Zamora

维护¶

避免在

test_inheriting_class中出现PytestReturnNotNoneWarning(GH#9707) Thomas Grainger修复不稳定的

test_dataframe_aggregations_multilevel(GH#9701) Richard (Rick) Zamora更新

mypy版本 (GH#9697) crusaderky在

test_map_partitions_df_input中禁用仪表板 (GH#9687) James Bourbeau在

upstream构建中使用最新的xarray-contrib/issue-from-pytest-log(GH#9682) James Bourbeauxfailttest_1samp用于上游scipy(GH#9670) James Bourbeau将 gpuCI 的

RAPIDS_VER更新为23.02(GH#9678)

2022.11.1¶

发布于2022年11月18日

增强功能¶

限制

bokeh=3支持 (GH#9673) Gabe Josephfastparquet进化的更新 (GH#9650) Martin Durant

维护¶

在gpuCI更新工作流中更新

ga-yaml-parser步骤 (GH#9675) Charles Blackmon-Luca恢复

importlib.metadata的解决方法 (GH#9658) James Bourbeau修复

mindeps-distributedCI 构建以处理未安装numpy/pandas的情况 (GH#9668) James Bourbeau

2022.11.0¶

发布于2022年11月15日

增强功能¶

将

from_dict实现泛化,以允许从其他后端使用 (GH#9628) GALI PREM SAGAR

Bug 修复¶

避免在

dask.dataframe.core中使用pandas构造函数 (GH#9570) Richard (Rick) Zamora修复

sort_values与Timestamp数据 (GH#9642) James Bourbeau在

_get_partitions中泛化数组检查并移除pd.Index调用 (GH#9634) Benjamin Zaitlen修复

read_csv在header=0和names时的行为 (GH#9614) Richard (Rick) Zamora

文档¶

更新队列仪表板文档 (GH#9660) Gabe Joseph

从文档字符串中移除

import dask as d(GH#9644) Matthew Rocklin修复

read_parquet文档字符串中对分区文档的链接 (GH#9636) qheuristics在

array/bag/dataframe部分添加 API 文档链接 (GH#9630) Matthew Rocklin

维护¶

使用

conda-incubator/setup-miniconda@v2.2.0(GH#9662) John A Kirkham允许

bokeh=3(GH#9659) James Bourbeau使用 Python 3.10 运行

upstream构建 (GH#9655) James Bourbeau在mindeps测试中固定

pyyaml版本 (GH#9640) Charles Blackmon-Luca添加

pre-commit以捕捉breakpoint()(GH#9638) James Bourbeau将

xarray-contrib/issue-from-pytest-log从 1.1 升级到 1.2 (GH#9635)移除

blosc引用 (GH#9625) Naty Clementi升级

mypy并删除未使用的注释 (GH#9616) Hendrik Makait强化

test_repartition_npartitions(GH#9585) Richard (Rick) Zamora

2022.10.1¶

发布于2022年10月28日

增强功能¶

为

set_index添加扩展 dtype 支持 (GH#9566) James Bourbeau重新设计数组 HTML 表示以提高清晰度 (GH#9519) Shingo OKAWA

文档¶

添加关于默认限制线程过度订阅的注释 (GH#9592) James Bourbeau

使用

sphinx-click为daskCLI (GH#9589) James Bourbeau修复信号量API文档 (GH#9584) James Bourbeau

在

map_overlap文档字符串中渲染元描述 (GH#9568) James Bourbeau

维护¶

在 Dask 中要求 Click 7.0+ (GH#9595) John A Kirkham

暂时限制

bokeh<3(GH#9607) James Bourbeau解决

upstreamCI 中的importlib相关失败 (GH#9604) Charles Blackmon-Luca改进

upstreamCI 报告 (GH#9603) James Bourbeau修复

upstreamCI 报告 (GH#9602) James Bourbeau移除

setuptools主机依赖,添加 CLI 入口点 (GH#9600) Charles Blackmon-Luca

2022.10.0¶

发布于2022年10月14日

新功能¶

Dask-Array 和 Dask-DataFrame 中的 IO 后端库调度 (GH#9475) Richard (Rick) Zamora

添加新的可扩展CLI (GH#9283) Doug Davis

增强功能¶

修复数组复制不是空操作 (GH#9555) David Hoese

在

map_overlap中添加对字符串 timedelta 的支持 (GH#9559) Nicolas Grandemange使

datetime.datetime幂等化标记 (GH#9532) Martin Durant

Bug 修复¶

避免在延迟调度注册中的竞争条件 (GH#9545) James Bourbeau

不允许对

int数据类型使用np.nan进行 setitem 操作 (GH#9531) Doug Davis选择时修复项目CSV列(GH#9534) Martin Durant

文档¶

更新 Parquet 最佳实践 (GH#9537) Matthew Rocklin

维护¶

限制

tiledb-py版本以避免 CI 失败 (GH#9569) James Bourbeau将

actions/github-script从 3 升级到 6 (GH#9564)将

actions/stale从 4 升级到 6 (GH#9551)将

peter-evans/create-pull-request从 3 升级到 4 (GH#9550)将

actions/checkout从 2 升级到 3.1.0 (GH#9552)将

codecov/codecov-action从 1 升级到 3 (GH#9549)将

the-coding-turtle/ga-yaml-parser从 0.1.1 升级到 0.1.2 (GH#9553)移动 dependabot 配置文件 (GH#9547) James Bourbeau

为GitHub actions添加dependabot (GH#9542) James Bourbeau

在 Windows 和 Linux 上运行 mypy (GH#9530) crusaderky

将 gpuCI 的

RAPIDS_VER更新为22.12(GH#9524)

2022年9月2日¶

发布于2022年9月30日

增强功能¶