MLflow Sentence-Transformers 风格

注意

sentence-transformers 风格正在积极开发中,并被标记为实验性。公共API可能会发生变化,随着风格的演进,可能会添加新功能。

介绍

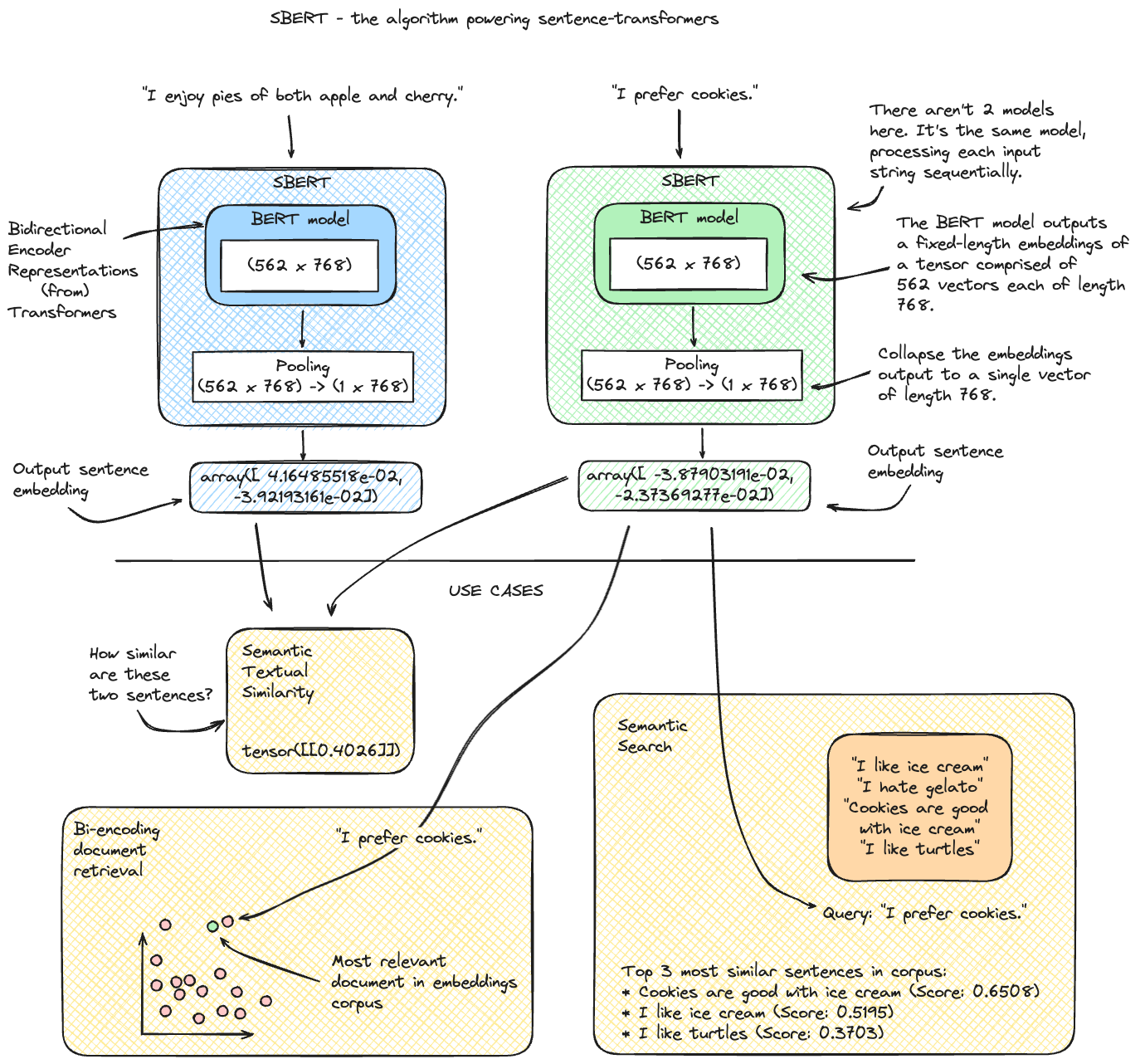

Sentence-Transformers 是一个开创性的 Python 库,专门用于生成高质量、语义丰富的句子和段落嵌入。作为著名的 Transformers 库的扩展,由 🤗 Hugging Face 开发,Sentence-Transformers 特别适用于需要深入理解句子级上下文的任务。该库对于语义搜索、文本聚类和相似性评估等 NLP 应用至关重要。

利用预训练模型如BERT、RoBERTa和DistilBERT,这些模型经过微调用于句子嵌入,Sentence-Transformers简化了生成文本有意义向量表示的过程。该库因其简单性、效率及其生成的嵌入质量而脱颖而出。

该库提供了许多强大的高层实用函数,用于对句子嵌入执行常见的后续任务。这些包括:

语义文本相似性: 评估两个句子之间的 语义相似性。

语义搜索: 搜索 给定查询在语料库中最语义相似的句子。

聚类: 将 相似的句子 分组在一起。

信息检索:通过文档 检索和排序 找到与给定查询最相关的句子。

释义挖掘:在大规模文本语料库中寻找具有相似(或相同)`含义 <https://www.sbert.net/examples/applications/paraphrase-mining/README.html>`_ 的文本条目。

是什么让这个库如此特别?

让我们来看一下 Sentence-Transformers 库如何工作的基本表示,以及你可以用它做什么!

将 Sentence-Transformers 与 MLflow 集成,MLflow 是一个致力于简化整个机器学习生命周期的平台,增强了这些专门的自然语言处理模型的实验跟踪和部署能力。MLflow 对 Sentence-Transformers 的支持使从业者能够有效地管理实验、跟踪不同的模型版本,并轻松部署模型以进行各种自然语言处理任务。

Sentence-Transformers 提供:

高质量句子嵌入:高效生成捕捉语言上下文和语义细微差别的句子嵌入。

预训练模型可用性:访问为句子嵌入任务微调的各种预训练模型,简化嵌入生成过程。

易用性: 简化的API,使其对NLP专家和新手都易于访问。

自定义训练与微调:灵活地在特定数据集上微调模型,或从头开始训练新模型,以实现定制化的自然语言处理解决方案。

通过 MLflow 的 Sentence-Transformers 风格,用户可以受益于:

简化的实验跟踪:在训练和微调过程中轻松记录参数、指标和句子嵌入模型。

无忧部署:通过简单的API调用,部署用于各种应用的句子嵌入模型。

广泛的模型兼容性:支持来自 Sentence-Transformers 库的一系列句子嵌入模型,确保能够访问最新的嵌入技术。

无论你是在进行语义文本相似性、聚类还是信息检索,MLflow 与 Sentence-Transformers 的集成都为将高级句子级理解融入你的应用提供了一个强大且高效的路径。

特性

使用 MLflow 的 Sentence-Transformers 风格,用户可以:

保存 和 记录 Sentence-Transformer 模型在 MLflow 中使用相应的 API:

mlflow.sentence_transformers.save_model()和mlflow.sentence_transformers.log_model()。跟踪详细的实验,包括与微调运行相关的 参数、指标 和 工件。

部署 用于实际应用的句子嵌入模型。

利用

mlflow.pyfunc.PythonModel风格进行通用 Python 函数推理,实现复杂而强大的自定义机器学习解决方案。

你可以用 Sentence Transformers 和 MLflow 做什么?

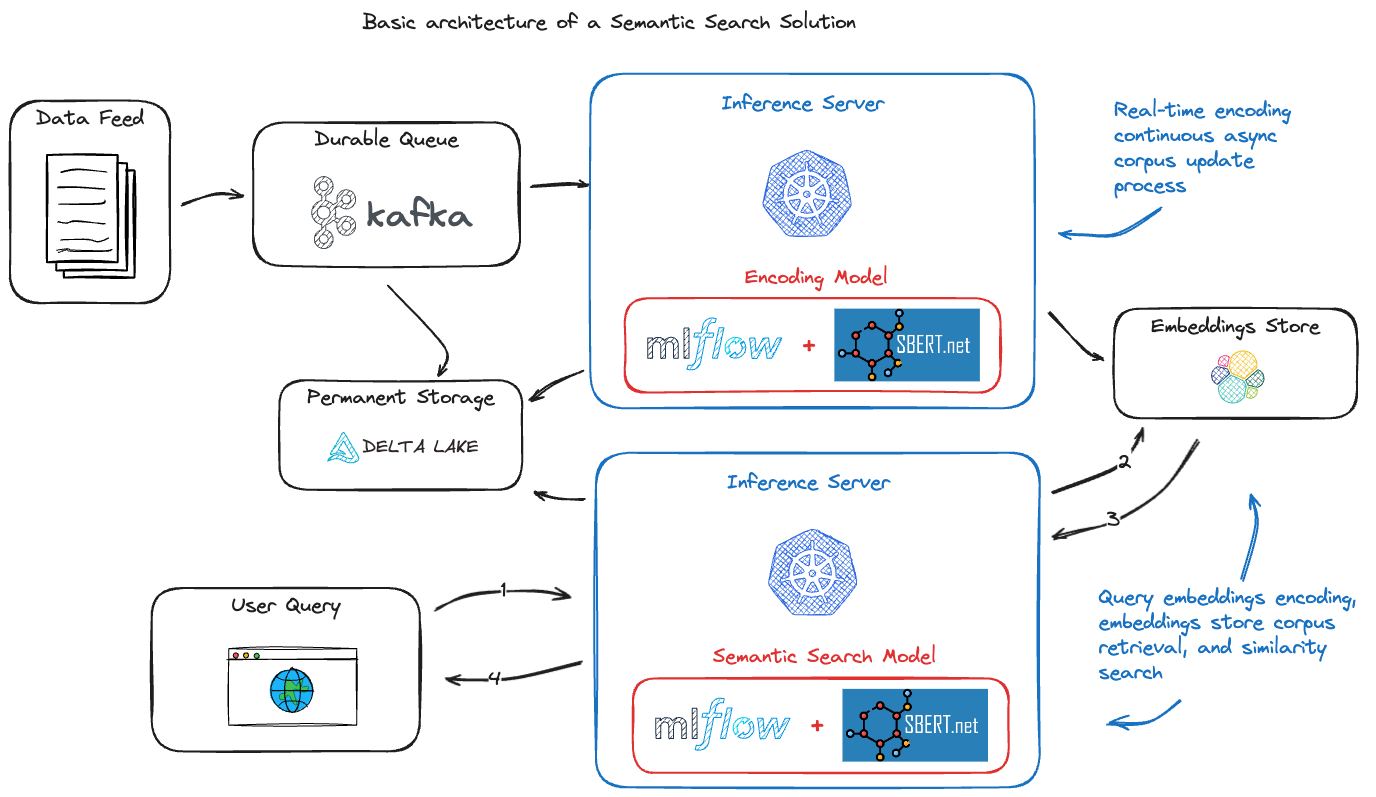

使用这些工具可以构建的更强大的应用之一是语义搜索引擎。通过使用现成的开源工具,您可以构建一个语义搜索引擎,该引擎可以为给定的查询在语料库中找到语义上最相似的句子。与传统基于关键词的搜索引擎相比,这是一个显著的改进,后者在理解查询的上下文方面能力有限。

以下展示了此类应用栈的一个示例高层架构:

轻松部署

一旦模型训练完成,它需要被部署用于推理。MLflow 与 Sentence Transformers 的集成通过提供诸如 mlflow.sentence_transformers.load_model() 和 mlflow.pyfunc.load_model() 等功能简化了这一过程,这些功能使得模型服务变得容易。你可以阅读更多关于 使用 MLflow 部署模型 的信息,找到关于 使用部署 API 的进一步信息,以及 启动本地模型服务端点 以深入了解 MLflow 提供的部署选项。

开始使用 MLflow Sentence Transformers 风格 - 教程和指南

下面,你会发现一些专注于不同方式的指南,这些方式可以利用 sentence-transformers 库的强大功能,利用 MLflow 的 API 进行跟踪和推理能力。

入门教程

高级教程

详细文档

要了解更多关于sentence transformers的MLflow风格的细节,请深入阅读下面的综合指南。

View the Comprehensive Guide了解更多关于 Sentence Transformers

Sentence Transformers 是一个用于计算句子、段落和图像的密集向量表示的多功能框架。基于 BERT、RoBERTa 和 XLM-RoBERTa 等变换器网络,它在各种任务中提供了最先进的性能。该框架设计用于易于使用和定制,使其适用于自然语言处理及其他领域的广泛应用。

对于那些对深入研究 Sentence Transformers 感兴趣的人,以下资源是不可或缺的:

官方文档和源代码

官方文档:要获取全面的入门指南、高级用法和API参考,请访问 Sentence Transformers 文档。

GitHub 仓库: Sentence Transformers GitHub 仓库 是获取最新代码、示例和更新的主要来源。在这里,您还可以报告问题、为项目做出贡献,或探索社区如何使用和扩展该框架。

Sentence Transformers 的官方指南和教程

图书馆资源

PyPI 包: Sentence Transformers 的 PyPI 页面 提供了安装信息、版本历史和包依赖项。

Conda Forge 包: 对于偏好使用 Conda 作为包管理器的用户,Sentence Transformers 的 Conda Forge 页面 是获取安装和包详情的主要资源。

预训练模型: Sentence Transformers 提供了大量针对各种语言和任务优化的 预训练模型 。这些模型可以轻松集成到您的项目中。

Sentence Transformers 在不断发展,定期更新并增加其功能。无论你是自然语言处理领域的研究人员、开发者还是爱好者,这些资源都将帮助你充分利用这一强大的工具。