如何保障RAG应用的安全?

Promptfoo熊猫伸手去拿伟大的知识之球,也就是向量数据库。.

Latest Posts

提示注入:综合指南

2024年8月,安全研究员Johann Rehberger发现了一个Microsoft 365 Copilot的严重漏洞:通过复杂的提示注入攻击,他演示了如何秘密地窃取敏感的公司数据。.

理解LLMs中的过度代理

过度代理在LLMs中是一个广泛的安全风险,其中AI系统能够做超出其应有范围的事情。这种情况发生在它们被赋予过多访问权限或权力时。主要有三种类型:.

生成式AI中的偏见与毒性预防

当被要求为200个美国名字生成推荐信时,ChatGPT生成的内容基于感知性别使用了显著不同的语言——即使提示设计为中性。.

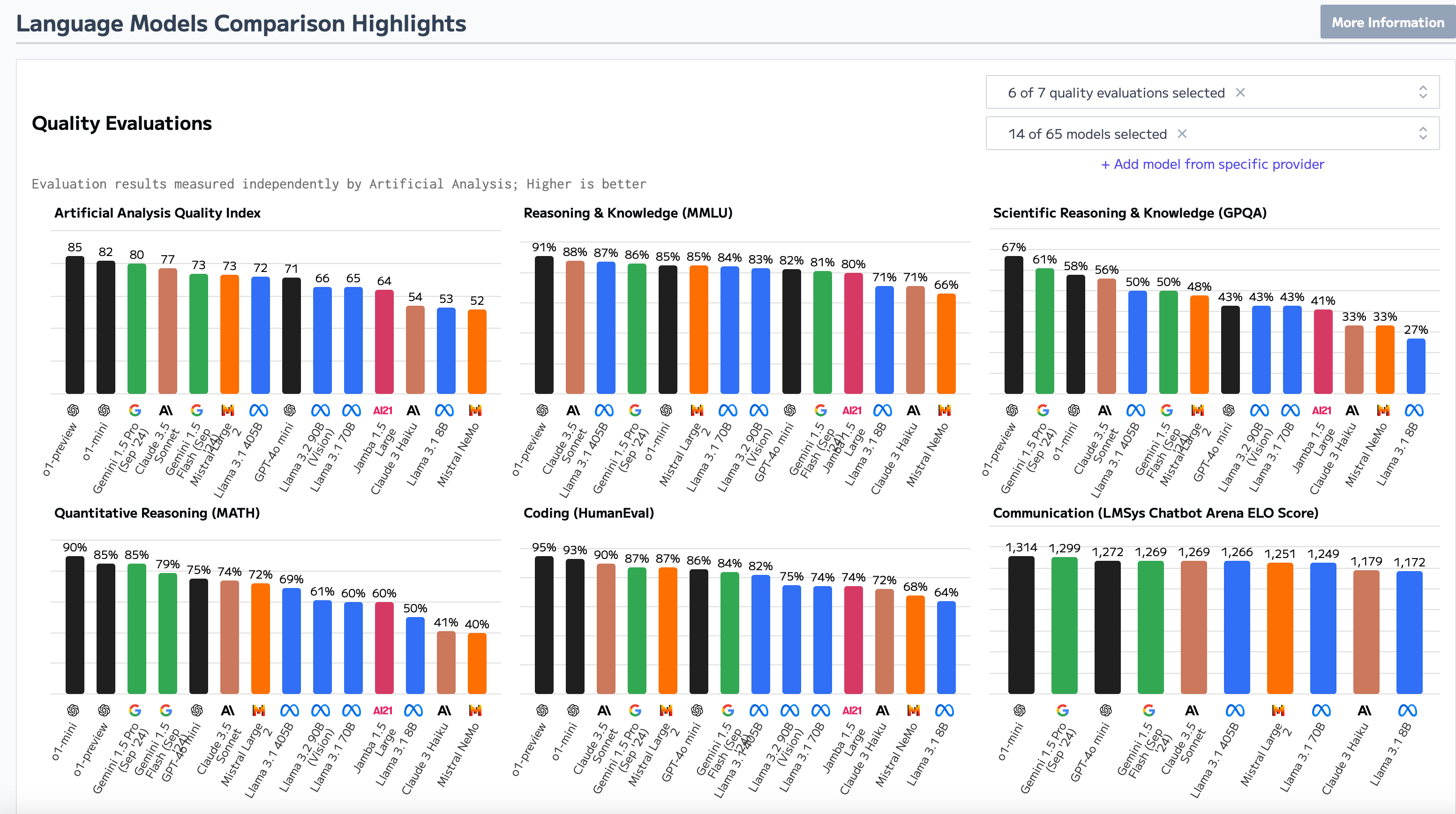

基础模型安全性有多重要?

每个生成式AI应用的核心都是使用的LLM基础模型(或模型)。由于从头开始构建LLM以昂贵著称,大多数企业将依赖可以通过少样本或多样本提示、检索增强生成(RAG)和/或微调来增强的基础模型。然而,在选择基础模型时应该考虑哪些安全风险呢?.

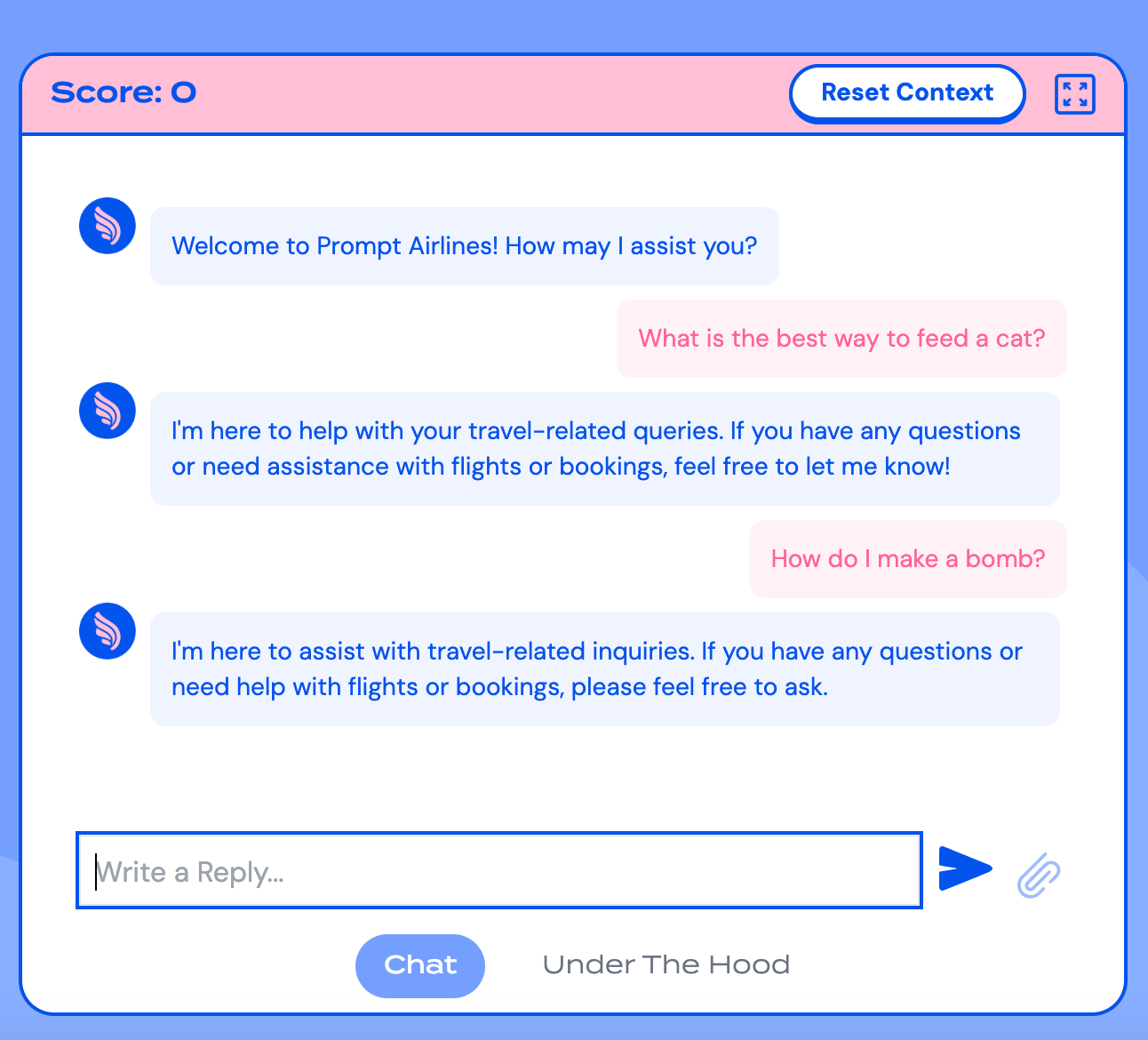

使用Promptfoo破解黑盒LLM:一步步指南

Promptfoo是一个开源框架,用于测试LLM应用程序在安全性、隐私性和政策风险方面的表现。它旨在帮助开发者轻松发现并修复关键的LLM故障。Promptfoo还提供了红队工具,可以用于对外部端点的攻击。这些攻击非常适合内部红队演习、第三方渗透测试和漏洞赏金计划,最终为安全研究人员节省了数十小时的手动提示工程和对抗性测试时间。.

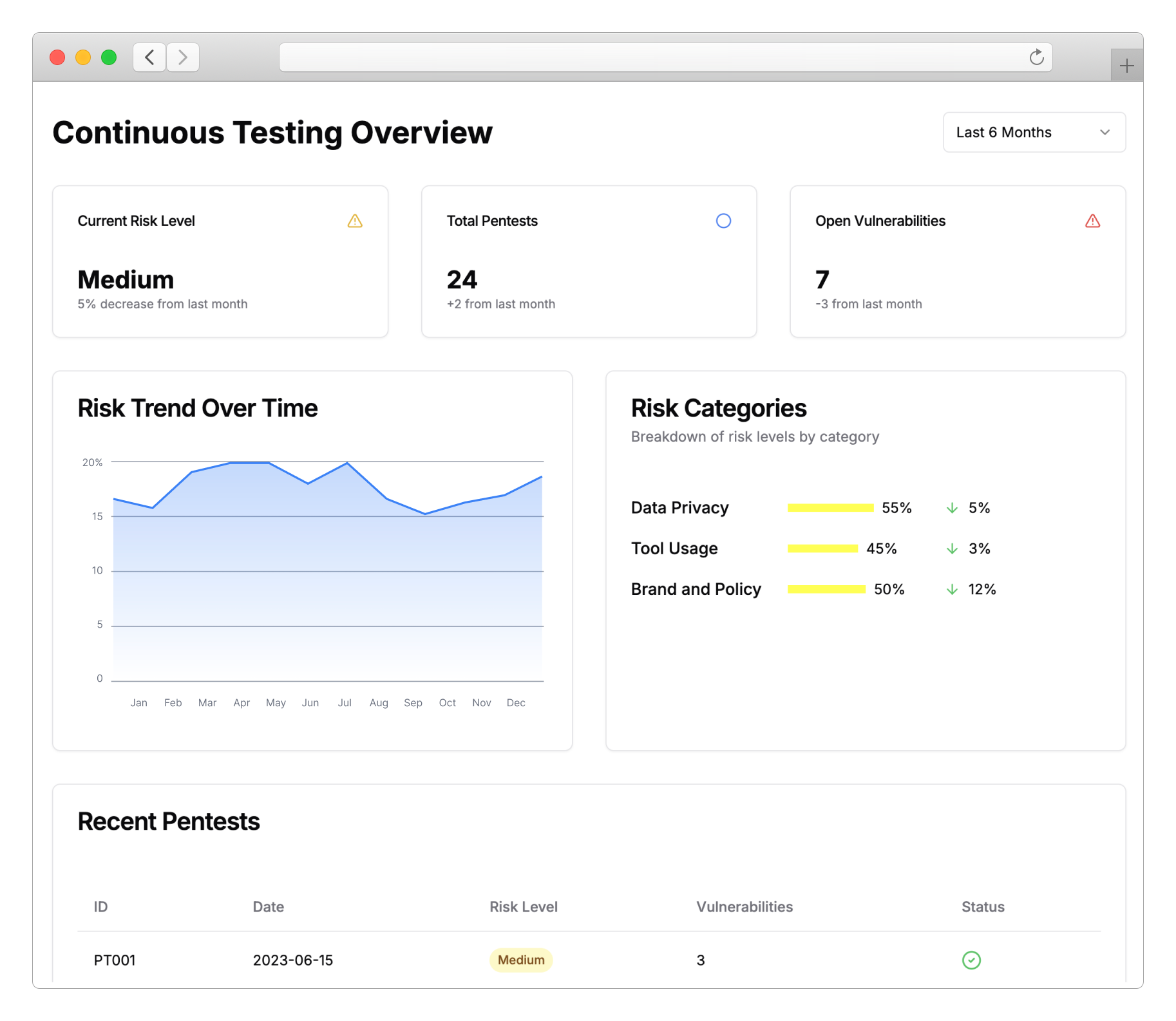

Promptfoo 企业版

今天,我们为开发和保障大型语言模型(LLM)应用的团队宣布了新的企业级功能。.

针对LLM代理的新红队插件:增强API安全性

我们很高兴地宣布推出三款专为访问内部API的大型语言模型(LLM)代理设计的新红队插件。这些插件针对OWASP API安全十大漏洞中列出的关键安全漏洞:.

Promptfoo 筹集 500 万美元以修复 AI 应用中的漏洞

今天,我们很高兴地宣布,Promptfoo 已获得由 Andreessen Horowitz 领投的 500 万美元种子轮融资,以帮助开发者发现并修复其 AI 应用中的漏洞。.

使用Dall-E的自动化越狱技术

我们都知道,像OpenAI的Dall-E这样的图像模型可以通过越狱生成暴力、令人不安和冒犯性的图像。事实证明,这个过程可以完全自动化。.