非 OpenAI 模型

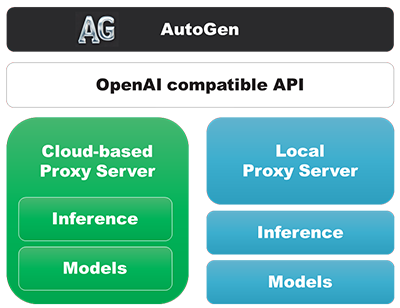

AutoGen 允许您通过提供与 OpenAI 兼容的 API 或自定义模型客户端类来使用非 OpenAI 模型。

这种灵活性的好处包括访问数百个模型,将专门的模型分配给代理人(例如,微调的编码模型),在您的环境中完全运行 AutoGen,同时利用 OpenAI 和非 OpenAI 模型在一个系统中运行,并减少推理成本。

兼容 OpenAI API 的代理服务器

任何提供与OpenAI 的 API兼容的 API 的代理服务器都可以与 AutoGen 一起使用。

这些代理服务器可以是基于云的,也可以在您的环境中本地运行。

基于云的代理服务器

通过使用基于云的代理服务器,您可以在不需要硬件和软件的情况下使用模型。

这些提供商可以托管开源/权重模型,例如Hugging Face和Mistral AI,或者他们自己的闭源模型。

当基于云的代理服务器提供与 OpenAI 兼容的 API 时,在 AutoGen 中使用它们是直接的。使用LLM 配置的方式与使用 OpenAI 模型时基本相同,主要区别通常在于身份验证,通常通过 API 密钥处理。

下面提供了使用具有与 OpenAI 兼容的 API 的基于云的代理服务器提供商的示例:

本地运行的代理服务器

越来越多的 LLM 代理服务器可供本地使用。这些可以是开源的(例如 LiteLLM、Ollama、vLLM)或闭源的(例如 LM Studio),通常用于在您的环境中运行全栈。

与基于云的代理服务器类似,只要这些代理服务器提供与 OpenAI 兼容的 API,将它们运行在 AutoGen 中就很简单。

下面提供了使用具有与 OpenAI 兼容的 API 的本地运行的代理服务器的示例:

如果您计划使用函数调用,不是所有基于云的和本地代理服务器都支持使用 OpenAI 兼容的 API 进行函数调用,请查看它们的文档。

非 OpenAI �模型的配置

无论您选择基于云的还是本地运行的代理服务器,配置方式与使用 OpenAI 模型相同,请参阅LLM 配置。 更多信息请参考。

您可以使用model configuration filtering将特定模型分配给代理。

自定义模型客户端类

对于更高级的用户,您可以创建自己的自定义模型客户端类,从而能够定义和加载自己的模型。

请参阅AutoGen with Custom Models: Empowering Users to Use Their Own Inference Mechanism博客文章和此笔记本,了解如何创建自定义模型客户端类的指南。