高效的无限上下文变压器

Google 发表的一篇新的论文将压缩记忆集成到传统的点积注意力层中。

其目标是使 Transformer LLM 能够有效处理具有有限内存占用和计算量的无限长输入。

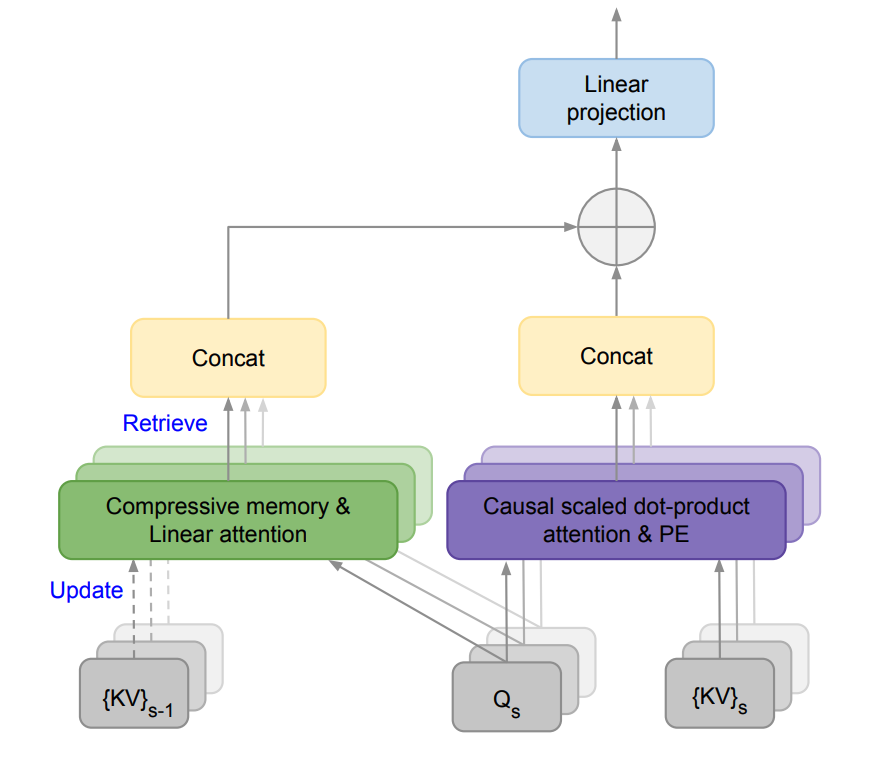

他们提出了一种名为 Infini-attention 的新型注意力技术,将一个压缩记忆模块融入到传统的注意力机制中。

该模型将掩码局部注意力和长期线性注意力结合到一个 Transformer 块中。这使得 Infini-Transformer 模型能够高效处理长距离和短距离的上下文依赖关系。

这种方法在长上下文语言建模任务中表现优异,内存压缩比达到了 114 倍!

他们还展示了一个 10 亿参数的 LLM 可以自然地扩展到 100 万序列长度,而一个 80 亿参数的模型在 50 万长度的书籍摘要任务上取得了新的最先进结果。

考虑到长上下文 LLM 的重要性,拥有一个有效的记忆系统可以释放出强大的推理、规划、持续适应等功能,这些功能在以往的 LLM 中尚未见过。