LLM 推理

在过去几年里,大型语言模型(LLMs)在各种任务中取得了显著进展。最近,当规模足够大时,LLMs已经展现出展示推理能力的潜力。不同类型的推理对智能至关重要,但目前还不完全了解AI模型如何学习和利用这种能力来解决复杂问题。这是许多研究实验室极为关注和投资的领域。

基于基础模型的推理

Sun等人(2023)最近提出了一个关于基础模型推理的概述,重点关注各种推理任务中的最新进展。这项工作还着眼于更广泛地涵盖跨模态模型和自主语言代理的推理。

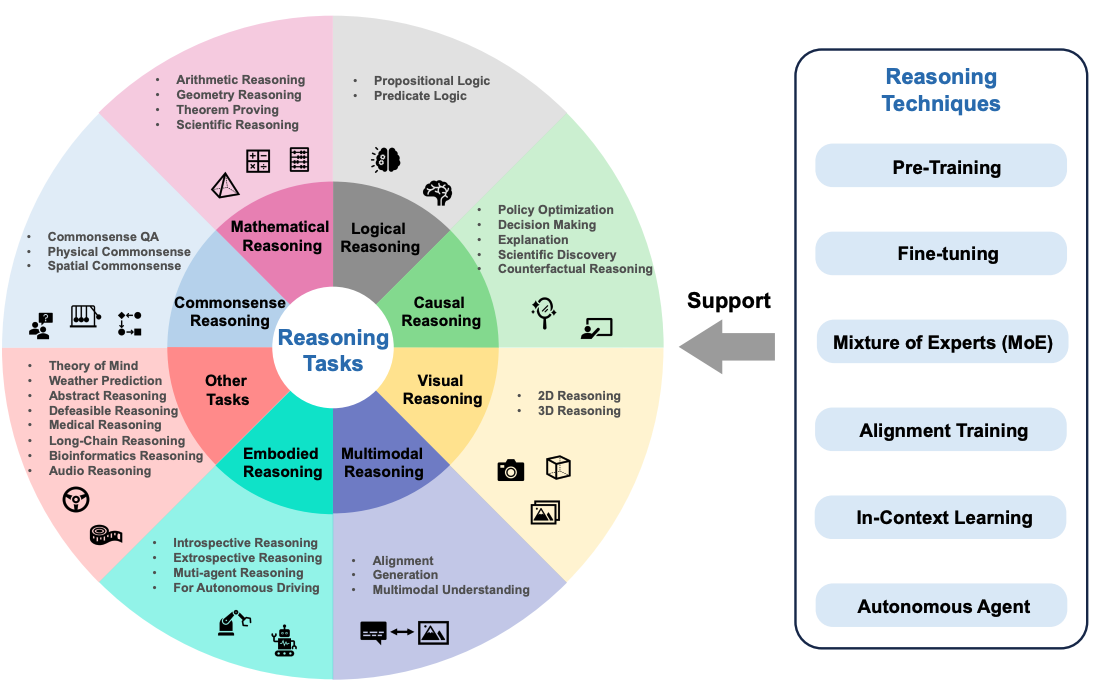

推理任务可能包括数学推理、逻辑推理、因果推理、视觉推理等任务。下图展示了调查论文中讨论的推理任务概述,包括基础模型的推理技术,如对齐训练和上下文学习。

图源:Sun等人,2023

图源:Sun等人,2023

如何在LLMs中引发推理?

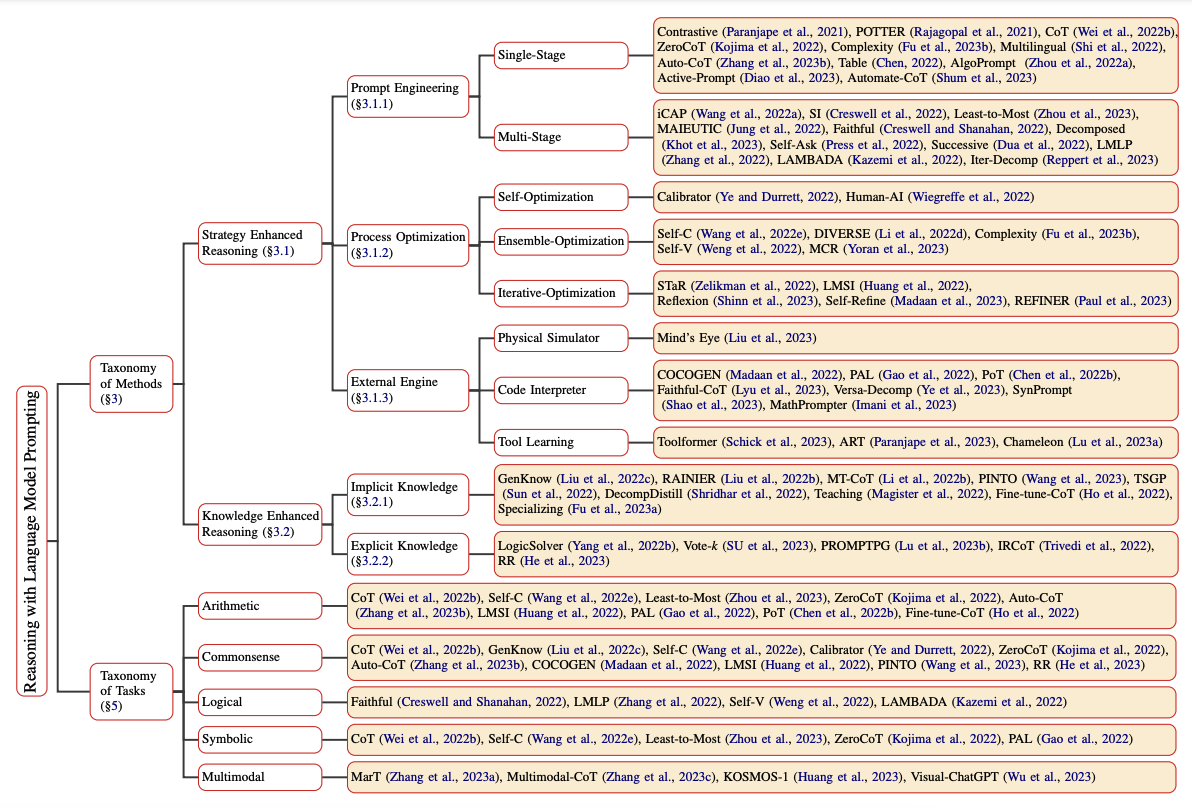

LLMs中的推理可以通过许多不同的提示方法引发和增强。Qiao等人(2023)将推理方法研究分为两个不同的分支,即增强推理策略和知识增强推理。推理策略包括提示工程、过程优化和外部引擎。例如,单阶段提示策略包括Chain-of-Thought和Active-Prompt。关于语言模型提示的推理的完整分类可以在论文中找到,并总结在下图中:

图源:Qiao等人,2023

图源:Qiao等人,2023

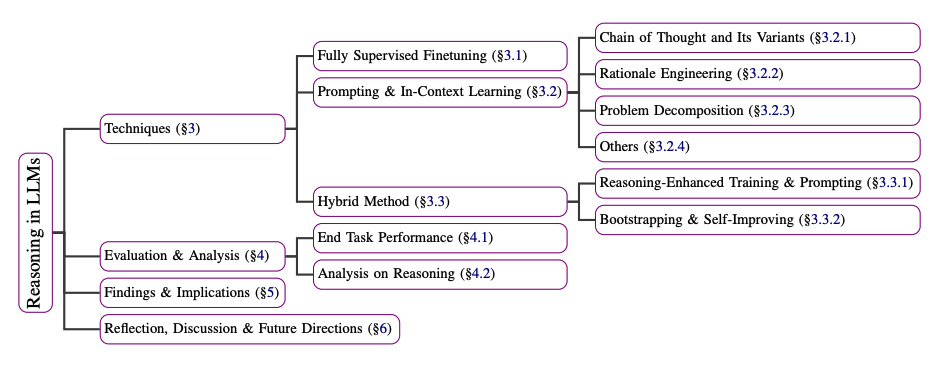

Huang等人(2023)还解释了一些改进或引发LLMs(如GPT-3)推理的技术摘要。这些技术范围从使用在解释数据集上训练的全监督微调模型到提示方法,如Chain-of-Thought、问题分解和上下文学习。下面是论文中描述的技术摘要:

图源:Huang等人,2023

图源:Huang等人,2023

LLMs能够推理和规划吗?

关于LLMs是否能够推理和规划存在很多争论。推理和规划都是解锁LLMs在机器人和自主代理等领域复杂应用的重要能力。Subbarao Kambhampati(2024)的一篇立场论文讨论了LLMs的推理和规划问题。

以下是作者结论的摘要:

总结一下,我所阅读、验证或进行的任何事情都没有给我任何充分的理由相信LLMs会进行推理/规划,正如通常理解的那样。相反,他们所做的是依靠网络规模训练,这是一种通用的近似检索形式,正如我所辩论的,有时可能被误认为是推理能力。