提升性能#

在本教程的这一部分中,我们将研究如何使用 Cython、Numba 和 pandas.eval() 加速对 pandas DataFrame 进行操作的某些函数。通常,使用 Cython 和 Numba 可以比使用 pandas.eval() 提供更大的加速,但需要更多的代码。

备注

除了遵循本教程中的步骤外,有兴趣提升性能的用户强烈建议安装 推荐的依赖项 以提升 pandas 的性能。这些依赖项通常不会默认安装,但如果存在,将会提供速度上的改进。

Cython(为pandas编写C扩展)#

对于许多用例来说,使用纯 Python 和 NumPy 编写 pandas 已经足够了。然而,在某些计算密集型应用中,通过将工作转移到 cython 可以实现显著的速度提升。

本教程假设您已经在Python中尽可能地进行了重构,例如通过尝试移除for循环并利用NumPy矢量化。首先在Python中进行优化总是值得的。

本教程通过一个“典型”的 Cython 化慢计算过程。我们使用 Cython 文档中的一个示例 但在 pandas 的上下文中。我们最终的 Cython 化解决方案比纯 Python 解决方案快大约 100 倍。

纯Python#

我们有一个 DataFrame ,我们希望对其逐行应用一个函数。

In [1]: df = pd.DataFrame(

...: {

...: "a": np.random.randn(1000),

...: "b": np.random.randn(1000),

...: "N": np.random.randint(100, 1000, (1000)),

...: "x": "x",

...: }

...: )

...:

In [2]: df

Out[2]:

a b N x

0 0.469112 -0.218470 585 x

1 -0.282863 -0.061645 841 x

2 -1.509059 -0.723780 251 x

3 -1.135632 0.551225 972 x

4 1.212112 -0.497767 181 x

.. ... ... ... ..

995 -1.512743 0.874737 374 x

996 0.933753 1.120790 246 x

997 -0.308013 0.198768 157 x

998 -0.079915 1.757555 977 x

999 -1.010589 -1.115680 770 x

[1000 rows x 4 columns]

以下是纯Python的函数:

In [3]: def f(x):

...: return x * (x - 1)

...:

In [4]: def integrate_f(a, b, N):

...: s = 0

...: dx = (b - a) / N

...: for i in range(N):

...: s += f(a + i * dx)

...: return s * dx

...:

我们通过使用 :meth:`DataFrame.apply`(按行)来实现我们的结果:

In [5]: %timeit df.apply(lambda x: integrate_f(x["a"], x["b"], x["N"]), axis=1)

61.1 ms +- 6.48 ms per loop (mean +- std. dev. of 7 runs, 10 loops each)

让我们来看看在使用 prun ipython 魔法函数 进行此操作时,时间都花在哪里了:

# most time consuming 4 calls

In [6]: %prun -l 4 df.apply(lambda x: integrate_f(x["a"], x["b"], x["N"]), axis=1) # noqa E999

605845 function calls (605827 primitive calls) in 0.148 seconds

Ordered by: internal time

List reduced from 139 to 4 due to restriction <4>

ncalls tottime percall cumtime percall filename:lineno(function)

1000 0.078 0.000 0.122 0.000 <ipython-input-4-c2a74e076cf0>:1(integrate_f)

552423 0.044 0.000 0.044 0.000 <ipython-input-3-c138bdd570e3>:1(f)

3000 0.004 0.000 0.015 0.000 series.py:889(__getitem__)

3000 0.003 0.000 0.008 0.000 series.py:973(_get_value)

到目前为止,大部分时间都花在 integrate_f 或 f 内部,因此我们将集中精力用 Cython 化这两个函数。

普通的 Cython#

首先,我们需要将 Cython 魔术函数导入到 IPython 中:

In [7]: %load_ext Cython

现在,让我们简单地将我们的函数复制到 Cython:

In [8]: %%cython

...: def f_plain(x):

...: return x * (x - 1)

...: def integrate_f_plain(a, b, N):

...: s = 0

...: dx = (b - a) / N

...: for i in range(N):

...: s += f_plain(a + i * dx)

...: return s * dx

...:

In [9]: %timeit df.apply(lambda x: integrate_f_plain(x["a"], x["b"], x["N"]), axis=1)

34 ms +- 1.69 ms per loop (mean +- std. dev. of 7 runs, 10 loops each)

与纯Python方法相比,这提高了三分之一的性能。

声明 C 类型#

我们可以注释函数变量和返回类型,以及使用 cdef 和 cpdef 来提高性能:

In [10]: %%cython

....: cdef double f_typed(double x) except? -2:

....: return x * (x - 1)

....: cpdef double integrate_f_typed(double a, double b, int N):

....: cdef int i

....: cdef double s, dx

....: s = 0

....: dx = (b - a) / N

....: for i in range(N):

....: s += f_typed(a + i * dx)

....: return s * dx

....:

In [11]: %timeit df.apply(lambda x: integrate_f_typed(x["a"], x["b"], x["N"]), axis=1)

5.18 ms +- 186 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

使用C类型注释函数与原始Python实现相比,性能提高了十倍以上。

使用 ndarray#

当重新分析时,时间花费在从每一行创建一个 Series ,并从索引和序列中调用 __getitem__ (每行三次)。这些 Python 函数调用是昂贵的,可以通过传递一个 np.ndarray 来改进。

In [12]: %prun -l 4 df.apply(lambda x: integrate_f_typed(x["a"], x["b"], x["N"]), axis=1)

52422 function calls (52404 primitive calls) in 0.015 seconds

Ordered by: internal time

List reduced from 137 to 4 due to restriction <4>

ncalls tottime percall cumtime percall filename:lineno(function)

3000 0.002 0.000 0.009 0.000 series.py:889(__getitem__)

3000 0.002 0.000 0.004 0.000 series.py:973(_get_value)

3000 0.001 0.000 0.001 0.000 base.py:3538(get_loc)

3000 0.001 0.000 0.002 0.000 indexing.py:2741(check_dict_or_set_indexers)

In [13]: %%cython

....: cimport numpy as np

....: import numpy as np

....: cdef double f_typed(double x) except? -2:

....: return x * (x - 1)

....: cpdef double integrate_f_typed(double a, double b, int N):

....: cdef int i

....: cdef double s, dx

....: s = 0

....: dx = (b - a) / N

....: for i in range(N):

....: s += f_typed(a + i * dx)

....: return s * dx

....: cpdef np.ndarray[double] apply_integrate_f(np.ndarray col_a, np.ndarray col_b,

....: np.ndarray col_N):

....: assert (col_a.dtype == np.float64

....: and col_b.dtype == np.float64 and col_N.dtype == np.dtype(int))

....: cdef Py_ssize_t i, n = len(col_N)

....: assert (len(col_a) == len(col_b) == n)

....: cdef np.ndarray[double] res = np.empty(n)

....: for i in range(len(col_a)):

....: res[i] = integrate_f_typed(col_a[i], col_b[i], col_N[i])

....: return res

....:

这个实现创建了一个零数组,并将 integrate_f_typed 应用于每一行的结果插入其中。在 Cython 中循环遍历一个 ndarray 比循环遍历一个 Series 对象更快。

由于 apply_integrate_f 被类型化为接受一个 np.ndarray ,需要调用 Series.to_numpy() 来使用这个函数。

In [14]: %timeit apply_integrate_f(df["a"].to_numpy(), df["b"].to_numpy(), df["N"].to_numpy())

765 us +- 40 us per loop (mean +- std. dev. of 7 runs, 1,000 loops each)

性能比之前的实现提高了近十倍。

禁用编译器指令#

大部分时间现在都花在 apply_integrate_f 上了。禁用 Cython 的 boundscheck 和 wraparound 检查可以提高性能。

In [15]: %prun -l 4 apply_integrate_f(df["a"].to_numpy(), df["b"].to_numpy(), df["N"].to_numpy())

165 function calls in 0.001 seconds

Ordered by: internal time

List reduced from 45 to 4 due to restriction <4>

ncalls tottime percall cumtime percall filename:lineno(function)

1 0.001 0.001 0.001 0.001 <string>:1(<module>)

1 0.000 0.000 0.001 0.001 {built-in method builtins.exec}

3 0.000 0.000 0.000 0.000 base.py:565(to_numpy)

3 0.000 0.000 0.000 0.000 managers.py:1151(iget)

In [16]: %%cython

....: cimport cython

....: cimport numpy as np

....: import numpy as np

....: cdef np.float64_t f_typed(np.float64_t x) except? -2:

....: return x * (x - 1)

....: cpdef np.float64_t integrate_f_typed(np.float64_t a, np.float64_t b, np.int64_t N):

....: cdef np.int64_t i

....: cdef np.float64_t s = 0.0, dx

....: dx = (b - a) / N

....: for i in range(N):

....: s += f_typed(a + i * dx)

....: return s * dx

....: @cython.boundscheck(False)

....: @cython.wraparound(False)

....: cpdef np.ndarray[np.float64_t] apply_integrate_f_wrap(

....: np.ndarray[np.float64_t] col_a,

....: np.ndarray[np.float64_t] col_b,

....: np.ndarray[np.int64_t] col_N

....: ):

....: cdef np.int64_t i, n = len(col_N)

....: assert len(col_a) == len(col_b) == n

....: cdef np.ndarray[np.float64_t] res = np.empty(n, dtype=np.float64)

....: for i in range(n):

....: res[i] = integrate_f_typed(col_a[i], col_b[i], col_N[i])

....: return res

....:

In [17]: %timeit apply_integrate_f_wrap(df["a"].to_numpy(), df["b"].to_numpy(), df["N"].to_numpy())

567 us +- 19 us per loop (mean +- std. dev. of 7 runs, 1,000 loops each)

然而,一个访问数组中无效位置的循环索引器 i 会导致段错误,因为内存访问未被检查。有关 boundscheck 和 wraparound 的更多信息,请参阅 Cython 文档中的 编译器指令。

Numba (JIT 编译)#

静态编译 Cython 代码的另一种选择是使用带有 Numba 的动态即时(JIT)编译器。

Numba 允许你编写一个纯 Python 函数,该函数可以通过使用 @jit 装饰你的函数,被 JIT 编译为本地机器指令,性能类似于 C、C++ 和 Fortran。

Numba 通过在导入时、运行时或静态地(使用包含的 pycc 工具)使用 LLVM 编译器基础设施生成优化的机器代码。Numba 支持将 Python 编译为在 CPU 或 GPU 硬件上运行,并且设计为与 Python 科学软件栈集成。

备注

@jit 编译会在函数的运行时增加开销,因此在使用小数据集时可能不会实现性能提升。考虑 缓存 你的函数,以避免每次运行函数时的编译开销。

Numba 可以以两种方式与 pandas 一起使用:

在选择pandas方法时指定``engine=”numba”``关键字

定义你自己的 Python 函数,并用

@jit装饰,并将Series或DataFrame的底层 NumPy 数组(使用Series.to_numpy())传递给该函数

pandas Numba 引擎#

如果安装了 Numba,可以在选择 pandas 方法时指定 engine="numba" 以使用 Numba 执行该方法。支持 engine="numba" 的方法还将有一个 engine_kwargs 关键字,该关键字接受一个字典,允许指定 "nogil"、"nopython" 和 "parallel" 键,并带有布尔值以传递给 @jit 装饰器。如果未指定 engine_kwargs,则默认为 {"nogil": False, "nopython": True, "parallel": False},除非另有指定。

备注

在性能方面,第一次使用 Numba 引擎运行函数会比较慢,因为 Numba 会有一些函数编译开销。然而,JIT 编译的函数会被缓存,后续调用将会很快。总的来说,Numba 引擎在处理大量数据点(例如 100 万以上)时表现良好。

In [1]: data = pd.Series(range(1_000_000)) # noqa: E225

In [2]: roll = data.rolling(10)

In [3]: def f(x):

...: return np.sum(x) + 5

# Run the first time, compilation time will affect performance

In [4]: %timeit -r 1 -n 1 roll.apply(f, engine='numba', raw=True)

1.23 s ± 0 ns per loop (mean ± std. dev. of 1 run, 1 loop each)

# Function is cached and performance will improve

In [5]: %timeit roll.apply(f, engine='numba', raw=True)

188 ms ± 1.93 ms per loop (mean ± std. dev. of 7 runs, 10 loops each)

In [6]: %timeit roll.apply(f, engine='cython', raw=True)

3.92 s ± 59 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

如果你的计算硬件包含多个CPU,通过将 parallel 设置为 True 以利用超过1个CPU,可以实现最大的性能提升。在内部,pandas 利用 numba 来并行化 DataFrame 列的计算;因此,这种性能提升仅对具有大量列的 DataFrame 有益。

In [1]: import numba

In [2]: numba.set_num_threads(1)

In [3]: df = pd.DataFrame(np.random.randn(10_000, 100))

In [4]: roll = df.rolling(100)

In [5]: %timeit roll.mean(engine="numba", engine_kwargs={"parallel": True})

347 ms ± 26 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

In [6]: numba.set_num_threads(2)

In [7]: %timeit roll.mean(engine="numba", engine_kwargs={"parallel": True})

201 ms ± 2.97 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

自定义函数示例#

一个用 @jit 装饰的自定义 Python 函数可以通过传递它们的 NumPy 数组表示与 pandas 对象一起使用,使用 Series.to_numpy()。

import numba

@numba.jit

def f_plain(x):

return x * (x - 1)

@numba.jit

def integrate_f_numba(a, b, N):

s = 0

dx = (b - a) / N

for i in range(N):

s += f_plain(a + i * dx)

return s * dx

@numba.jit

def apply_integrate_f_numba(col_a, col_b, col_N):

n = len(col_N)

result = np.empty(n, dtype="float64")

assert len(col_a) == len(col_b) == n

for i in range(n):

result[i] = integrate_f_numba(col_a[i], col_b[i], col_N[i])

return result

def compute_numba(df):

result = apply_integrate_f_numba(

df["a"].to_numpy(), df["b"].to_numpy(), df["N"].to_numpy()

)

return pd.Series(result, index=df.index, name="result")

In [4]: %timeit compute_numba(df)

1000 loops, best of 3: 798 us per loop

在这个例子中,使用 Numba 比使用 Cython 更快。

Numba 也可以用来编写向量化函数,这些函数不需要用户显式地循环遍历向量的观测值;向量化函数将自动应用于每一行。考虑以下将每个观测值加倍的示例:

import numba

def double_every_value_nonumba(x):

return x * 2

@numba.vectorize

def double_every_value_withnumba(x): # noqa E501

return x * 2

# Custom function without numba

In [5]: %timeit df["col1_doubled"] = df["a"].apply(double_every_value_nonumba) # noqa E501

1000 loops, best of 3: 797 us per loop

# Standard implementation (faster than a custom function)

In [6]: %timeit df["col1_doubled"] = df["a"] * 2

1000 loops, best of 3: 233 us per loop

# Custom function with numba

In [7]: %timeit df["col1_doubled"] = double_every_value_withnumba(df["a"].to_numpy())

1000 loops, best of 3: 145 us per loop

注意事项#

Numba 最擅长加速那些对 NumPy 数组应用数值函数的函数。如果你尝试 @jit 一个包含不支持的 Python 或 NumPy 代码的函数,编译将回退到 对象模式 ,这很可能不会加速你的函数。如果你希望 Numba 在无法以加速代码的方式编译函数时抛出错误,请传递给 Numba 参数 nopython=True``(例如 ``@jit(nopython=True))。有关 Numba 模式的故障排除更多信息,请参见 Numba 故障排除页面。

使用 parallel=True``(例如 ``@jit(parallel=True))可能会导致 SIGABRT,如果线程层导致不安全行为。你可以在运行带有 parallel=True 的 JIT 函数之前 指定一个安全的线程层。

通常,如果您在使用 Numba 时遇到段错误 (SIGSEGV),请将问题报告到 Numba 问题跟踪器。

通过 eval() 进行表达式求值#

顶级函数 pandas.eval() 实现了对 Series 和 DataFrame 的高性能表达式评估。表达式评估允许将操作表示为字符串,并且通过一次性评估大型 DataFrame 的算术和布尔表达式,可能会提供性能提升。

备注

对于简单的表达式或涉及小数据框的表达式,你不应该使用 eval()。事实上,对于较小的表达式或对象,eval() 比纯 Python 慢许多个数量级。一个好的经验法则是,只有当你有一个包含超过 10,000 行的 DataFrame 时,才使用 eval()。

支持的语法#

这些操作由 pandas.eval() 支持:

算术运算(除了左移 (

<<) 和右移 (>>) 运算符),例如,df + 2 * pi / s ** 4 % 42 - the_golden_ratio比较操作,包括链式比较,例如,

2 < df < df2布尔运算,例如,

df < df2 and df3 < df4 or not df_boollist和tuple字面量,例如,[1, 2]或(1, 2)属性访问,例如,

df.a下标表达式,例如,

df[0]简单的变量评估,例如,

pd.eval("df")(这并不是非常有用)数学函数:

sin,cos,exp,log,expm1,log1p,sqrt,sinh,cosh,tanh,arcsin,arccos,arctan,arccosh,arcsinh,arctanh,abs,arctan2和log10。

以下 Python 语法 不 允许:

表达式

除了数学函数之外的函数调用。

is/is not操作if表达式lambda表达式list/set/dict推导式字面量

dict和set表达式yield表达式生成器表达式

仅由标量值组成的布尔表达式

声明

本地变量#

你必须通过在名称前放置 @ 字符来 显式引用 任何你想在表达式中使用的局部变量。这个机制对于 DataFrame.query() 和 DataFrame.eval() 都是相同的。例如,

In [18]: df = pd.DataFrame(np.random.randn(5, 2), columns=list("ab"))

In [19]: newcol = np.random.randn(len(df))

In [20]: df.eval("b + @newcol")

Out[20]:

0 -0.206122

1 -1.029587

2 0.519726

3 -2.052589

4 1.453210

Name: b, dtype: float64

In [21]: df.query("b < @newcol")

Out[21]:

a b

1 0.160268 -0.848896

3 0.333758 -1.180355

4 0.572182 0.439895

如果你不使用 @ 前缀本地变量,pandas 会抛出一个异常,告诉你该变量未定义。

在使用 DataFrame.eval() 和 DataFrame.query() 时,这允许你在表达式中同时拥有一个局部变量和一个 DataFrame 列,且它们具有相同的名字。

In [22]: a = np.random.randn()

In [23]: df.query("@a < a")

Out[23]:

a b

0 0.473349 0.891236

1 0.160268 -0.848896

2 0.803311 1.662031

3 0.333758 -1.180355

4 0.572182 0.439895

In [24]: df.loc[a < df["a"]] # same as the previous expression

Out[24]:

a b

0 0.473349 0.891236

1 0.160268 -0.848896

2 0.803311 1.662031

3 0.333758 -1.180355

4 0.572182 0.439895

警告

pandas.eval() 如果你不能使用 @ 前缀,因为它在该上下文中未定义,将会引发异常。

In [25]: a, b = 1, 2

In [26]: pd.eval("@a + b")

Traceback (most recent call last):

File /usr/local/lib/python3.10/site-packages/IPython/core/interactiveshell.py:3577 in run_code

exec(code_obj, self.user_global_ns, self.user_ns)

Cell In[26], line 1

pd.eval("@a + b")

File /home/pandas/pandas/core/computation/eval.py:334 in eval

_check_for_locals(expr, level, parser)

File /home/pandas/pandas/core/computation/eval.py:171 in _check_for_locals

raise SyntaxError(msg)

File <string>

SyntaxError: The '@' prefix is not allowed in top-level eval calls.

please refer to your variables by name without the '@' prefix.

在这种情况下,你应该像在标准 Python 中那样引用变量。

In [27]: pd.eval("a + b")

Out[27]: 3

pandas.eval() 解析器#

有两种不同的表达式语法解析器。

默认的 'pandas' 解析器允许一种更直观的语法来表达类似查询的操作(比较、连接和分离)。特别是,& 和 | 运算符的优先级被设置为与相应的布尔运算 and 和 or 的优先级相同。

例如,上述连接可以不带括号书写。或者,你可以使用 'python' 解析器来强制严格的 Python 语义。

In [28]: nrows, ncols = 20000, 100

In [29]: df1, df2, df3, df4 = [pd.DataFrame(np.random.randn(nrows, ncols)) for _ in range(4)]

In [30]: expr = "(df1 > 0) & (df2 > 0) & (df3 > 0) & (df4 > 0)"

In [31]: x = pd.eval(expr, parser="python")

In [32]: expr_no_parens = "df1 > 0 & df2 > 0 & df3 > 0 & df4 > 0"

In [33]: y = pd.eval(expr_no_parens, parser="pandas")

In [34]: np.all(x == y)

Out[34]: True

同样的表达可以用单词 和 一起进行“与”操作:

In [35]: expr = "(df1 > 0) & (df2 > 0) & (df3 > 0) & (df4 > 0)"

In [36]: x = pd.eval(expr, parser="python")

In [37]: expr_with_ands = "df1 > 0 and df2 > 0 and df3 > 0 and df4 > 0"

In [38]: y = pd.eval(expr_with_ands, parser="pandas")

In [39]: np.all(x == y)

Out[39]: True

pandas.eval() 引擎#

有两种不同的表达引擎。

'numexpr' 引擎是性能更高的引擎,与标准 Python 语法相比,可以为大型 DataFrame 带来性能提升。此引擎需要安装可选依赖 numexpr。

'python' 引擎通常*不*有用,除非是为了测试其他评估引擎。使用 eval() 并设置 engine='python' 不会带来**任何**性能提升,甚至可能会导致性能下降。

In [40]: %timeit df1 + df2 + df3 + df4

4.37 ms +- 310 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

In [41]: %timeit pd.eval("df1 + df2 + df3 + df4", engine="python")

4.84 ms +- 187 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

The DataFrame.eval() 方法#

除了顶层的 pandas.eval() 函数外,你还可以在 DataFrame 的“上下文”中评估表达式。

In [42]: df = pd.DataFrame(np.random.randn(5, 2), columns=["a", "b"])

In [43]: df.eval("a + b")

Out[43]:

0 -0.161099

1 0.805452

2 0.747447

3 1.189042

4 -2.057490

dtype: float64

任何有效的 pandas.eval() 表达式也是有效的 DataFrame.eval() 表达式,额外的好处是你不需要在感兴趣的列前加上 DataFrame 的名称。

此外,您可以在表达式中执行列的赋值。这允许进行 公式化评估 。赋值目标可以是新的列名或现有的列名,并且它必须是一个有效的 Python 标识符。

In [44]: df = pd.DataFrame(dict(a=range(5), b=range(5, 10)))

In [45]: df = df.eval("c = a + b")

In [46]: df = df.eval("d = a + b + c")

In [47]: df = df.eval("a = 1")

In [48]: df

Out[48]:

a b c d

0 1 5 5 10

1 1 6 7 14

2 1 7 9 18

3 1 8 11 22

4 1 9 13 26

返回一个包含新列或修改列的 DataFrame 副本,原始框架保持不变。

In [49]: df

Out[49]:

a b c d

0 1 5 5 10

1 1 6 7 14

2 1 7 9 18

3 1 8 11 22

4 1 9 13 26

In [50]: df.eval("e = a - c")

Out[50]:

a b c d e

0 1 5 5 10 -4

1 1 6 7 14 -6

2 1 7 9 18 -8

3 1 8 11 22 -10

4 1 9 13 26 -12

In [51]: df

Out[51]:

a b c d

0 1 5 5 10

1 1 6 7 14

2 1 7 9 18

3 1 8 11 22

4 1 9 13 26

可以通过使用多行字符串来执行多列赋值。

In [52]: df.eval(

....: """

....: c = a + b

....: d = a + b + c

....: a = 1""",

....: )

....:

Out[52]:

a b c d

0 1 5 6 12

1 1 6 7 14

2 1 7 8 16

3 1 8 9 18

4 1 9 10 20

在标准 Python 中的等价物会是

In [53]: df = pd.DataFrame(dict(a=range(5), b=range(5, 10)))

In [54]: df["c"] = df["a"] + df["b"]

In [55]: df["d"] = df["a"] + df["b"] + df["c"]

In [56]: df["a"] = 1

In [57]: df

Out[57]:

a b c d

0 1 5 5 10

1 1 6 7 14

2 1 7 9 18

3 1 8 11 22

4 1 9 13 26

eval() 性能比较#

pandas.eval() 在包含大数组的表达式中表现良好。

In [58]: nrows, ncols = 20000, 100

In [59]: df1, df2, df3, df4 = [pd.DataFrame(np.random.randn(nrows, ncols)) for _ in range(4)]

DataFrame 算术:

In [60]: %timeit df1 + df2 + df3 + df4

2.98 ms +- 200 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

In [61]: %timeit pd.eval("df1 + df2 + df3 + df4")

3.22 ms +- 170 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

DataFrame 比较:

In [62]: %timeit (df1 > 0) & (df2 > 0) & (df3 > 0) & (df4 > 0)

3.89 ms +- 155 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

In [63]: %timeit pd.eval("(df1 > 0) & (df2 > 0) & (df3 > 0) & (df4 > 0)")

5.39 ms +- 617 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

DataFrame 算术与未对齐的轴。

In [64]: s = pd.Series(np.random.randn(50))

In [65]: %timeit df1 + df2 + df3 + df4 + s

4.79 ms +- 405 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

In [66]: %timeit pd.eval("df1 + df2 + df3 + df4 + s")

3.73 ms +- 205 us per loop (mean +- std. dev. of 7 runs, 100 loops each)

备注

操作例如

1 and 2 # would parse to 1 & 2, but should evaluate to 2

3 or 4 # would parse to 3 | 4, but should evaluate to 3

~1 # this is okay, but slower when using eval

应该在 Python 中执行。如果你尝试对不是类型 bool 或 np.bool_ 的标量操作数执行任何布尔/位运算,将会引发异常。

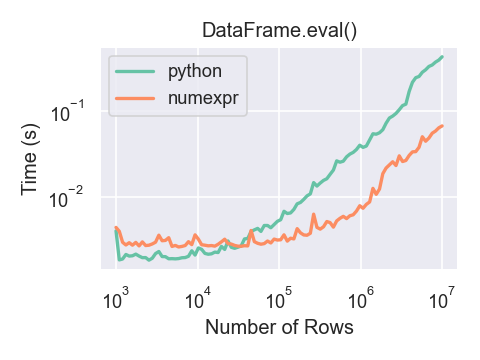

这里有一个图表显示了 pandas.eval() 的运行时间作为计算中涉及的帧大小的函数。两条线代表两种不同的引擎。

只有在使用 numexpr 引擎与 pandas.eval() 时,如果你的 DataFrame 有超过大约 100,000 行,你才会看到性能上的好处。

这个图表是使用一个包含3列的 DataFrame 创建的,每列都包含使用 numpy.random.randn() 生成的浮点值。

使用 numexpr 进行表达式求值的限制#

由于 NaT 会导致对象 dtype 或涉及日期时间操作的表达式必须在 Python 空间中进行评估,但表达式的一部分仍然可以使用 numexpr 进行评估。例如:

In [67]: df = pd.DataFrame(

....: {"strings": np.repeat(list("cba"), 3), "nums": np.repeat(range(3), 3)}

....: )

....:

In [68]: df

Out[68]:

strings nums

0 c 0

1 c 0

2 c 0

3 b 1

4 b 1

5 b 1

6 a 2

7 a 2

8 a 2

In [69]: df.query("strings == 'a' and nums == 1")

Out[69]:

Empty DataFrame

Columns: [strings, nums]

Index: []

数值部分的比较(nums == 1)将由``numexpr``进行评估,而对象部分的比较("strings == 'a')将由Python进行评估。