Mixtral 8x22B

Mixtral 8x22B 是 Mistral AI 发布的一款新型开放式大型语言模型(LLM)。Mixtral 8x22B 是一种稀疏的专家混合模型,其中有 39B 个活跃参数,总共有 141B 个参数。

功能

Mixtral 8x22B 被训练成一种成本高效的模型,具有多语言理解、数学推理、代码生成、本地函数调用支持和受限输出支持等功能。该模型支持 64K 个标记的上下文窗口大小,从而能够在大型文档上实现高性能的信息回溯。

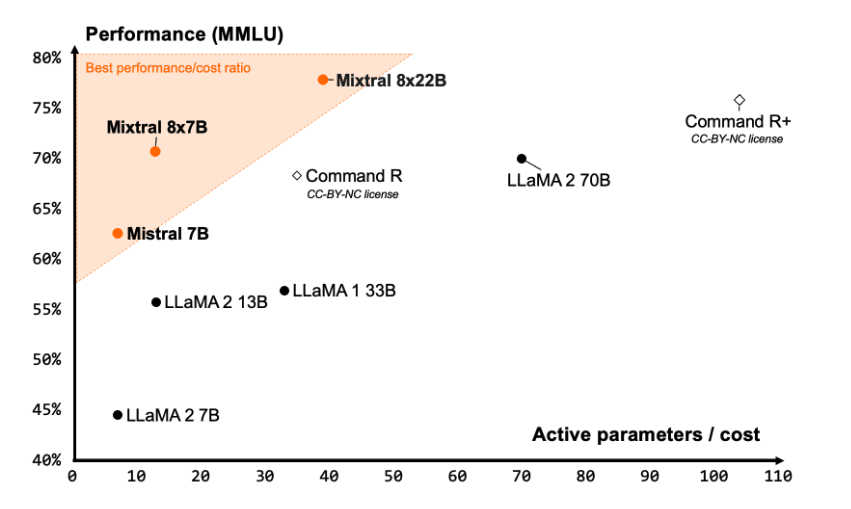

Mistral AI 声称,Mixtral 8x22B 提供了性能与成本比例最佳的社区模型之一,并且由于其稀疏激活而具有显著的快速性。

结果

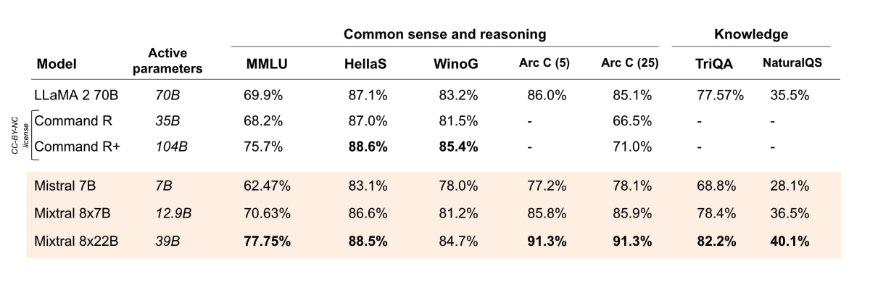

根据官方报告的结果,具有 39B 个活跃参数的 Mixtral 8x22B 在多个推理和知识基准测试(如 MMLU、HellaS、TriQA、NaturalQA 等)上优于 Command R+ 和 Llama 2 70B 等最先进的开放模型。

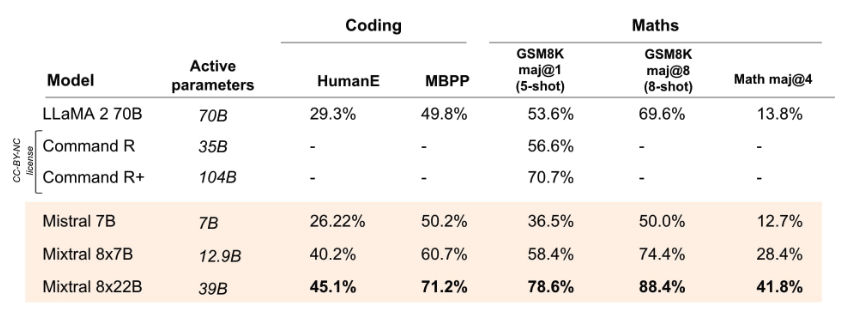

Mixtral 8x22B 在编码和数学任务上优于所有开放模型,当在 GSM8K、HumanEval 和 Math 等基准测试上进行评估时。据报道,Mixtral 8x22B Instruct 在 GSM8K(maj@8)上达到了 90% 的得分。

有关 Mixtral 8x22B 的更多信息以及如何使用,请参阅:https://docs.mistral.ai/getting-started/open_weight_models/#operation/listModels

该模型是根据 Apache 2.0 许可证发布的。

来源:

来源: 来源:

来源: 来源:

来源: