Llama.cpp 模型部署

Enterprise Feature

llama.cpp 模型部署应用程序可在 ClearML 企业计划下使用。

llama.cpp 模型部署应用程序使用户能够快速部署 GGUF 格式的 LLM 模型,使用 llama.cpp。

llama.cpp 模型部署应用程序在您选择的机器上为您的模型提供服务。一旦应用程序实例运行,它通过一个安全的、可公开访问的网络端点为您的模型提供服务。应用程序监控端点活动,并在模型在指定的最大空闲时间内保持不活动时关闭。

AI Application Gateway

llama.cpp 模型部署应用程序利用了 ClearML 流量路由器,该路由器为模型实现了一个安全、经过身份验证的网络端点。

如果ClearML AI应用程序网关不可用,模型端点可能无法访问。

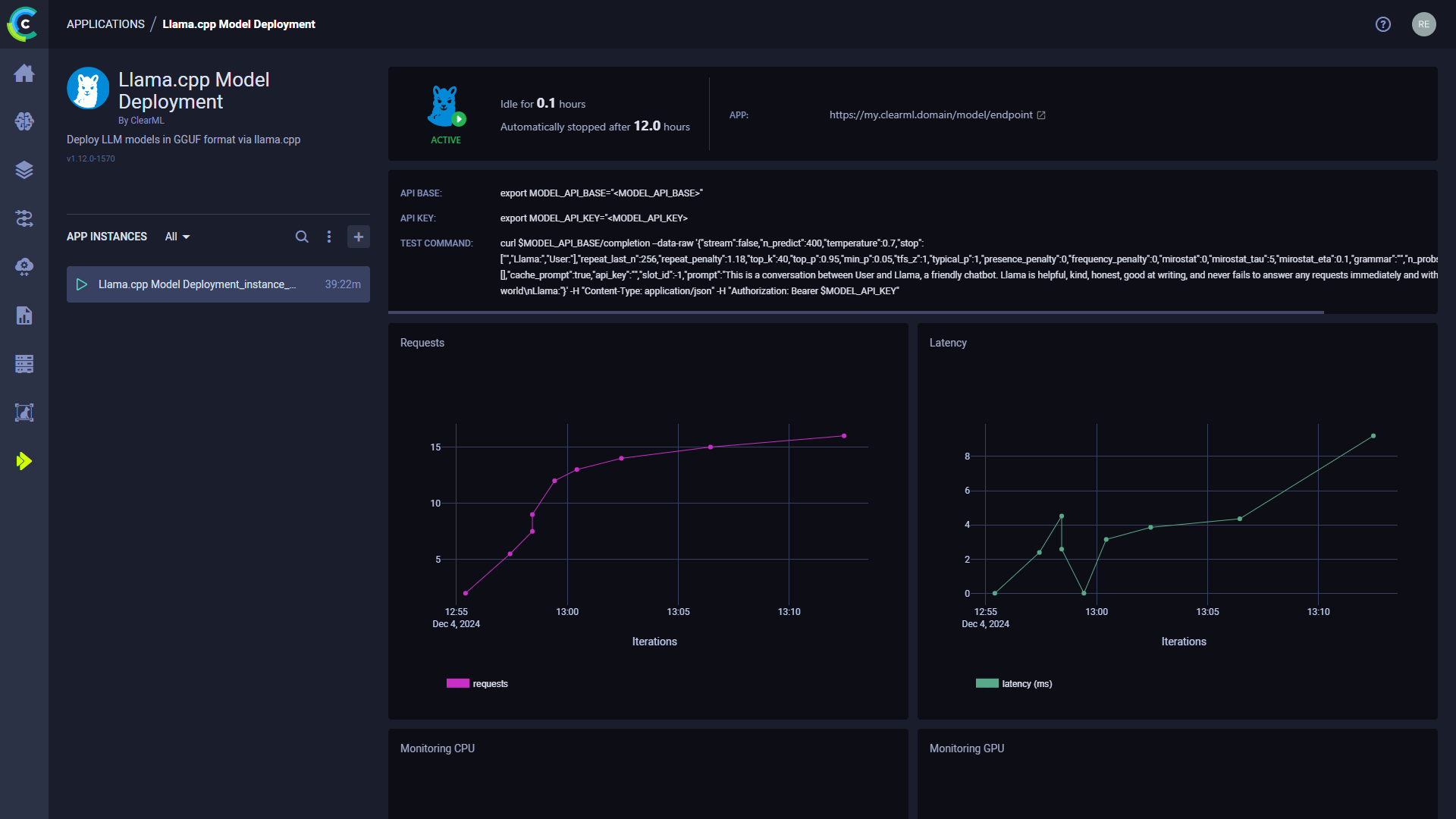

启动一个llama.cpp模型部署实例后,您可以在其仪表板中查看以下信息:

- 状态指示器

- 应用程序实例正在运行并且正在积极使用

- 应用程序实例正在设置中

- 应用程序实例处于空闲状态

- 应用程序实例已停止

- 空闲时间 - 自上次活动以来经过的时间

- App - 模型端点的公开可访问URL。活跃的模型端点也可以在 模型端点 表中找到,该表允许您查看和比较端点详细信息并 随时间监控状态

- API 基础 - 模型端点的基本 URL

- API key - 模型端点的认证密钥

- 测试命令 - 用于测试已部署模型的示例命令行

- 请求 - 随时间变化的请求数量

- 延迟 - 请求响应时间(毫秒)随时间变化

- 端点资源监控指标随时间变化

- CPU 使用率

- 网络吞吐量

- 磁盘性能

- 内存性能

- GPU 利用率

- GPU 内存使用率

- GPU 温度

- 控制台日志 - 控制台日志显示应用程序实例的控制台输出:设置进度、状态更改、错误消息等。

Llama.cpp 模型部署实例配置

在配置一个新的llama.cpp模型部署实例时,您可以填写所需的参数或重用之前启动实例的配置。

使用以下选项之一启动一个应用程序实例,配置与之前启动的实例相同:

- 克隆之前启动的应用程序实例将打开实例启动表单,并预填充原始实例的配置。

- 导入应用程序配置文件。您可以在查看其配置时,将之前启动的实例的配置导出为JSON文件。

在启动新的应用程序实例之前,可以编辑预填充的配置表单。

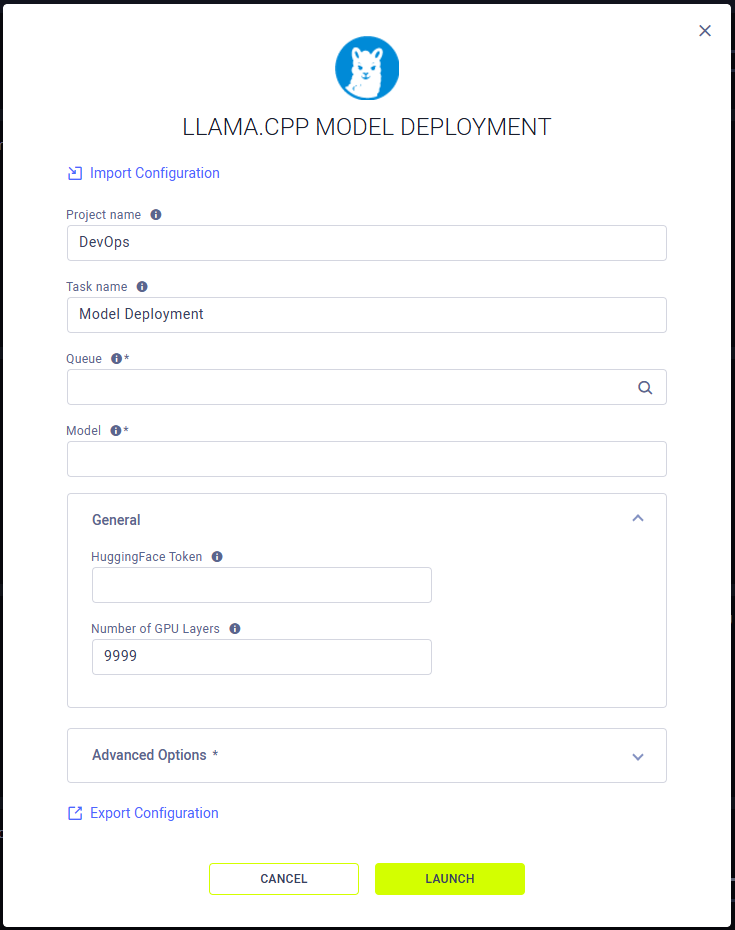

要配置一个新的应用程序实例,请点击Launch New 以打开应用程序的配置表单。

配置选项

- 导入配置 - 导入一个应用实例配置文件。这将用文件中的值填充配置表单,可以在启动应用实例之前进行修改。

- 项目名称 - ClearML 项目,您的 llama.cpp 模型部署应用程序实例将存储在此处

- 任务名称 - 您的llama.cpp模型部署应用实例的ClearML 任务名称

- 队列 - ClearML 队列,llama.cpp 模型部署应用程序实例任务将被加入该队列(确保已为其分配代理)

- 模型 - 一个ClearML模型ID或Hugging Face模型。模型必须是GGUF格式。如果您使用的是HuggingFace模型,请确保传递GGUF文件的路径。例如:

provider/repo/path/to/model.gguf - 常规

- Hugging Face Token - 用于访问需要身份验证的Hugging Face模型的令牌

- GPU层数 - 存储在VRAM中的层数。

9999表示所有层都应加载到VRAM中。用于将模型卸载到CPU RAM

- 高级选项

- 空闲时间限制(小时)- 应用实例在达到最大空闲时间后将关闭

- 最后操作报告间隔(秒)- 报告应用程序最后活动的频率。 用于在机器指标较低但应用程序实际上仍在运行时阻止应用程序进入空闲状态