拟合#

- scipy.stats.fit(dist, data, bounds=None, *, guess=None, method='mle', optimizer=<function differential_evolution>)[源代码][源代码]#

将离散或连续分布拟合到数据

给定一个分布、数据以及分布参数的界限,返回参数的最大似然估计。

- 参数:

- dist :

scipy.stats.rv_continuous或scipy.stats.rv_discretescipy.stats.rv_continuous 或 scipy.stats.rv_discrete 表示要拟合到数据的分布对象。

- 数据1D array_like

要拟合分布的数据。如果数据包含任何

np.nan、np.inf或 -np.inf,拟合方法将引发ValueError。- 边界字典或元组序列,可选

如果是一个字典,每个键是分布参数的名称,对应的值是一个包含该参数的下限和上限的元组。如果该分布仅定义了该参数的有限范围值,则不需要该参数的条目;例如,某些分布的参数必须在区间 [0, 1] 上。参数位置 (

loc) 和尺度 (scale) 的界限是可选的;默认情况下,它们分别固定为 0 和 1。如果是一个序列,元素 i 是一个包含分布的第 i 个参数的下限和上限的元组。在这种情况下,必须为 所有 分布形状参数提供界限。可选地,位置和尺度的界限可以跟随在分布形状参数之后。

如果一个形状需要保持固定(例如,如果它是已知的),下限和上限可能相等。如果用户提供的下限或上限超出了分布定义域的界限,分布定义域的界限将替换用户提供的值。同样,必须是整数的参数将被限制在用户提供界限内的整数值。

- 猜测字典或类似数组的对象,可选

如果是一个字典,每个键是分布参数的名称,对应的值是该参数的猜测值。

如果是一个序列,元素 i 是分布的第 i 个参数的猜测。在这种情况下,必须为 所有 分布形状参数提供猜测。

如果未提供 guess,则不会将决策变量的猜测传递给优化器。如果提供了 guess,则任何缺失参数的猜测将设置为上下限的平均值。必须为整数的参数的猜测将被四舍五入为整数值,并且位于用户提供的界限与分布域交集之外的猜测将被裁剪。

- 方法{‘mle’, ‘mse’}

使用

method="mle"``(默认),拟合是通过最小化负对数似然函数来计算的。对于超出分布支持范围的观测值,会应用一个大的有限惩罚(而不是无限负对数似然)。使用 ``method="mse",拟合是通过最小化负对数乘积间距函数来计算的。对于超出支持范围的观测值,应用相同的惩罚。我们遵循 [1] 的方法,该方法针对具有重复观测的样本进行了推广。- 优化器, 可选可调用,可选

optimizer 是一个可调用对象,接受以下位置参数。

- 乐趣可调用

要优化的目标函数。fun 接受一个参数

x,即分布的候选形状参数,并返回给定x、dist 和提供的 data 的目标函数值。optimizer 的工作是找到使 fun 最小化的决策变量的值。

optimizer 还必须接受以下关键字参数。

- 边界元组的序列

决策变量的取值范围;每个元素将是一个包含决策变量上下限的元组。

如果提供了 guess , optimizer 也必须接受以下关键字参数。

- x0array_like

每个决策变量的猜测值。

如果分布有任何必须为整数的形状参数,或者分布是离散的且位置参数未固定,optimizer 还必须接受以下关键字参数。

- 完整性布尔类型的类数组对象

对于每个决策变量,如果决策变量必须约束为整数值则为 True,如果决策变量为连续值则为 False。

optimizer 必须返回一个对象,例如

scipy.optimize.OptimizeResult的实例,该对象在属性x中保存决策变量的最优值。如果提供了属性fun、status或message,它们将被包含在fit返回的结果对象中。

- dist :

- 返回:

注释

当用户提供包含最大似然估计的紧边界时,优化更有可能收敛到最大似然估计。例如,当将二项分布拟合到数据时,每个样本的基础实验次数可能是已知的,在这种情况下,相应的形状参数

n可以固定。参考文献

[1]Shao, Yongzhao, 和 Marjorie G. Hahn. “最大间距乘积法:一种统一的公式及其强一致性的说明.” 伊利诺伊数学杂志 43.3 (1999): 489-499.

示例

假设我们希望将一个分布拟合到以下数据。

>>> import numpy as np >>> from scipy import stats >>> rng = np.random.default_rng() >>> dist = stats.nbinom >>> shapes = (5, 0.5) >>> data = dist.rvs(*shapes, size=1000, random_state=rng)

假设我们不知道数据是如何生成的,但我们怀疑它遵循参数为 n 和 p 的负二项分布。(参见

scipy.stats.nbinom。)我们相信参数 n 小于 30,并且我们知道参数 p 必须在区间 [0, 1] 内。我们将此信息记录在一个变量 bounds 中,并将此信息传递给fit。>>> bounds = [(0, 30), (0, 1)] >>> res = stats.fit(dist, data, bounds)

fit在用户指定的 bounds 内搜索最能匹配数据(在最大似然估计的意义上)的值。在这种情况下,它找到了与生成数据的形状值相似的形状值。>>> res.params FitParams(n=5.0, p=0.5028157644634368, loc=0.0) # may vary

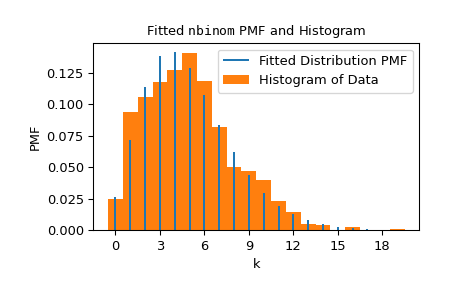

我们可以通过将分布的概率质量函数(形状拟合到数据)叠加在数据的归一化直方图上来可视化结果。

>>> import matplotlib.pyplot as plt # matplotlib must be installed to plot >>> res.plot() >>> plt.show()

注意,n 的估计值是整数;这是因为

nbinomPMF 的定义域仅包含整数 n,并且nbinom对象“知道”这一点。nbinom还知道形状参数 p 必须在 0 和 1 之间。在这种情况下——当分布相对于某个参数的定义域是有限的时候——我们不需要为该参数指定界限。>>> bounds = {'n': (0, 30)} # omit parameter p using a `dict` >>> res2 = stats.fit(dist, data, bounds) >>> res2.params FitParams(n=5.0, p=0.5016492009232932, loc=0.0) # may vary

如果我们希望强制分布在 n 固定为 6 的情况下拟合,我们可以将 n 的下限和上限都设置为 6。然而,需要注意的是,在这种情况下,被优化的目标函数的值通常会更差(更高)。

>>> bounds = {'n': (6, 6)} # fix parameter `n` >>> res3 = stats.fit(dist, data, bounds) >>> res3.params FitParams(n=6.0, p=0.5486556076755706, loc=0.0) # may vary >>> res3.nllf() > res.nllf() True # may vary

请注意,前面示例的数值结果是典型的,但它们可能会有所不同,因为

fit使用的默认优化器scipy.optimize.differential_evolution是随机的。然而,我们可以通过 optimizer 参数自定义优化器使用的设置,以确保可重复性——甚至可以完全使用不同的优化器。>>> from scipy.optimize import differential_evolution >>> rng = np.random.default_rng() >>> def optimizer(fun, bounds, *, integrality): ... return differential_evolution(fun, bounds, strategy='best2bin', ... seed=rng, integrality=integrality) >>> bounds = [(0, 30), (0, 1)] >>> res4 = stats.fit(dist, data, bounds, optimizer=optimizer) >>> res4.params FitParams(n=5.0, p=0.5015183149259951, loc=0.0)