扩展指令微调语言模型

有什么新内容?

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

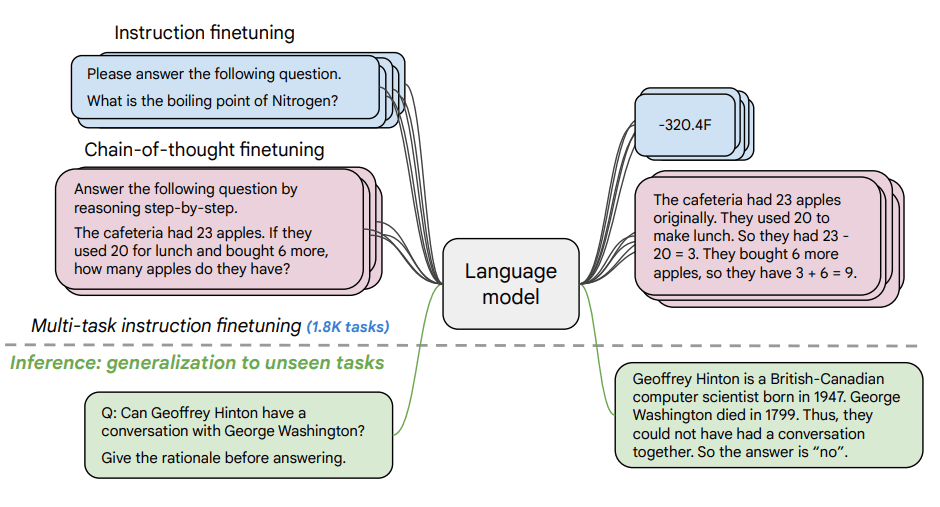

本文探讨了扩展指令微调(在新标签页中打开)的好处以及它如何提高各种模型(PaLM、T5)、提示设置(零样本、少样本、CoT)和基准测试(MMLU、TyDiQA)的性能。本文从以下几个方面进行了探讨:扩展任务数量(1.8K任务)、扩展模型规模以及在链式思维数据上进行微调(使用了9个数据集)。

微调过程:

- 1.8K任务被表述为指令并用于微调模型

- 使用带有和不带有示例,以及带有和不带有CoT

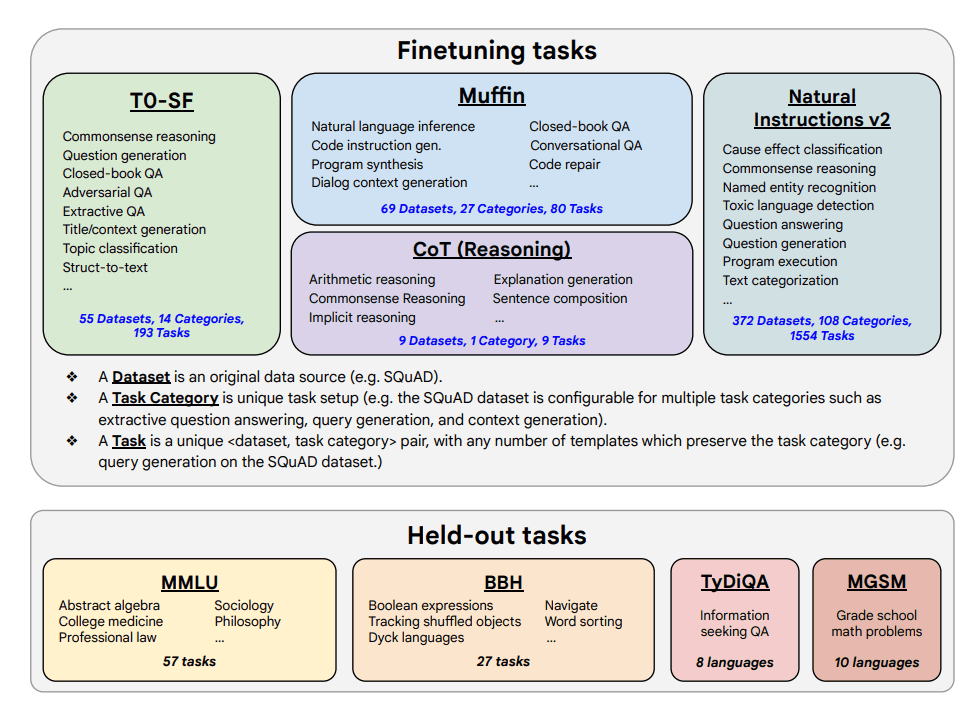

微调任务和保留任务如下所示:

能力与关键成果

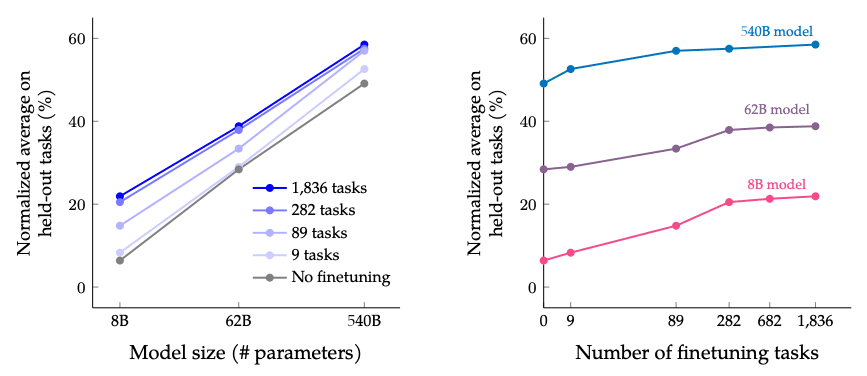

- 指令微调在任务数量和模型规模方面表现良好;这表明需要进一步扩展任务数量和模型规模

- 将CoT数据集添加到微调中,可以在推理任务上实现良好的性能

- Flan-PaLM 提升了多语言能力;在一次性 TyDiQA 上提升了 14.9%;在代表性不足的语言中的算术推理能力提升了 8.1%

- Plan-PaLM 在开放式生成问题上也表现良好,这是提高可用性的一个良好指标

- 提高负责任人工智能(RAI)基准测试的性能

- Flan-T5 指令调优模型展示了强大的少样本能力,并优于 T5 等公共检查点

微调任务数量和模型规模扩展时的结果: 尽管增加任务数量的回报递减,但扩展模型规模和微调任务数量预计会继续提高性能。

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

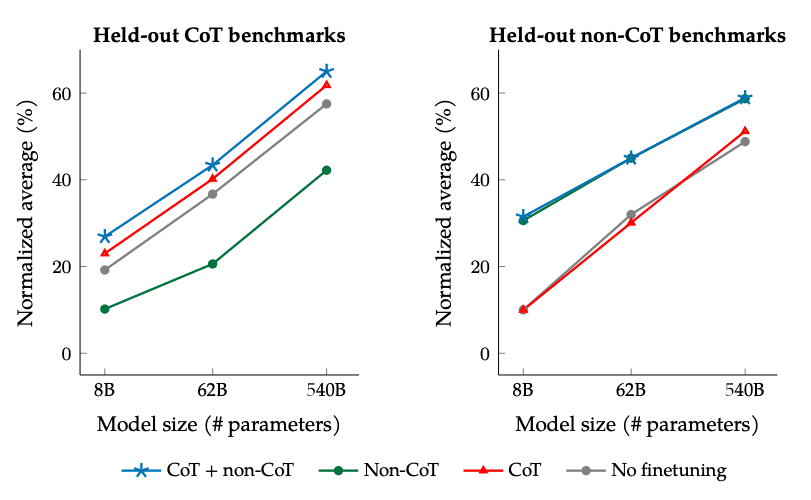

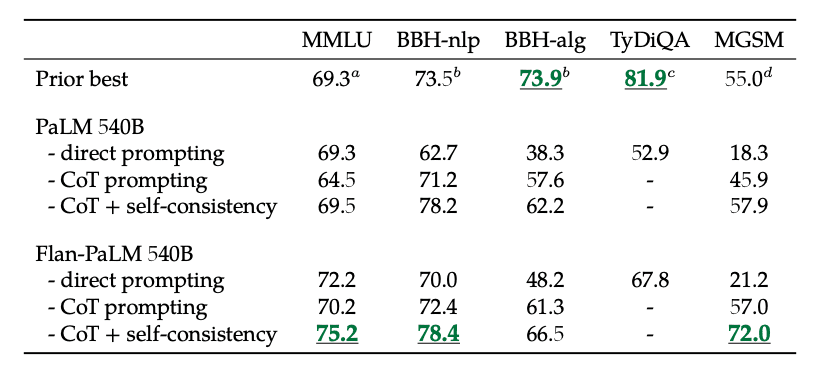

使用非CoT和CoT数据进行微调时的结果: 与非CoT或CoT数据单独进行微调相比,在非CoT和CoT数据上联合微调可以提高两种评估的性能。

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

此外,自洽性与CoT结合在多个基准测试中达到了SoTA结果。CoT + 自洽性也显著提高了涉及数学问题的基准测试结果(例如,MGSM,GSM8K)。

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

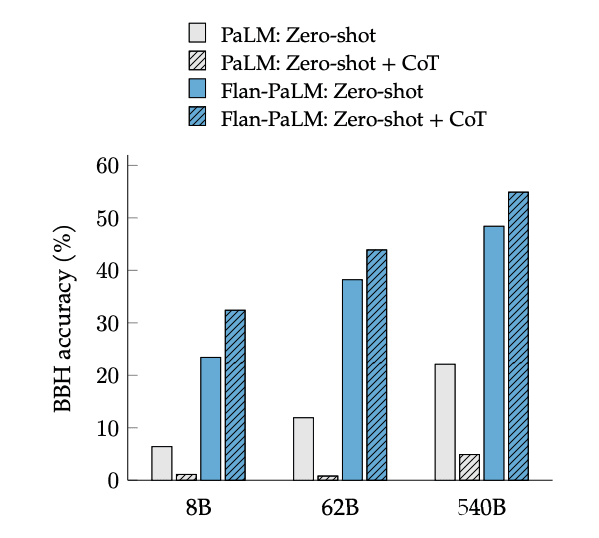

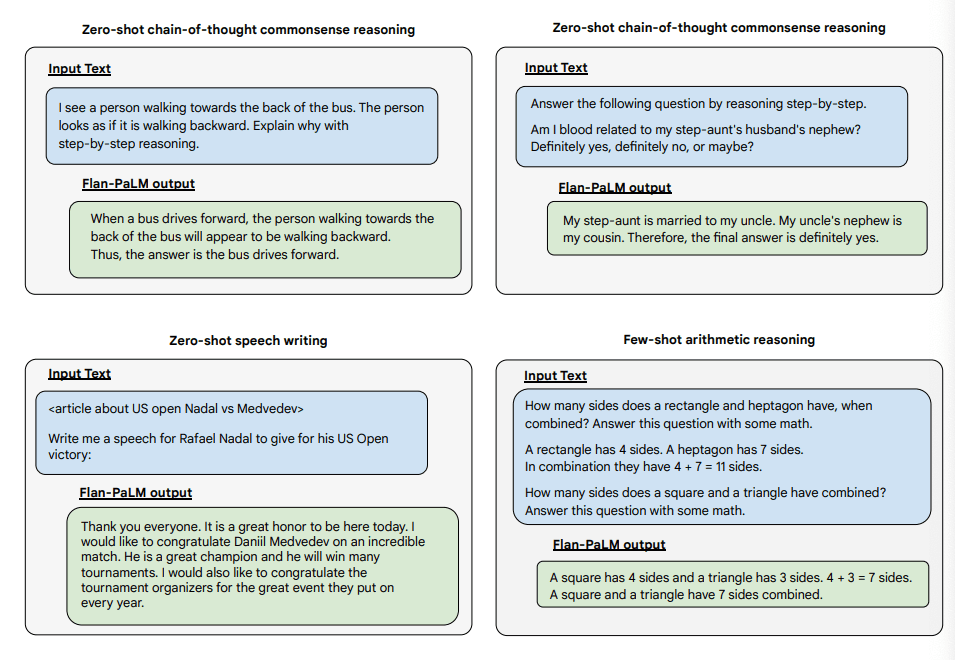

CoT微调解锁了零样本推理,通过短语“让我们一步一步思考”激活,在BIG-Bench任务上。一般来说,零样本CoT Flan-PaLM在没有微调的情况下优于零样本CoT PaLM。

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

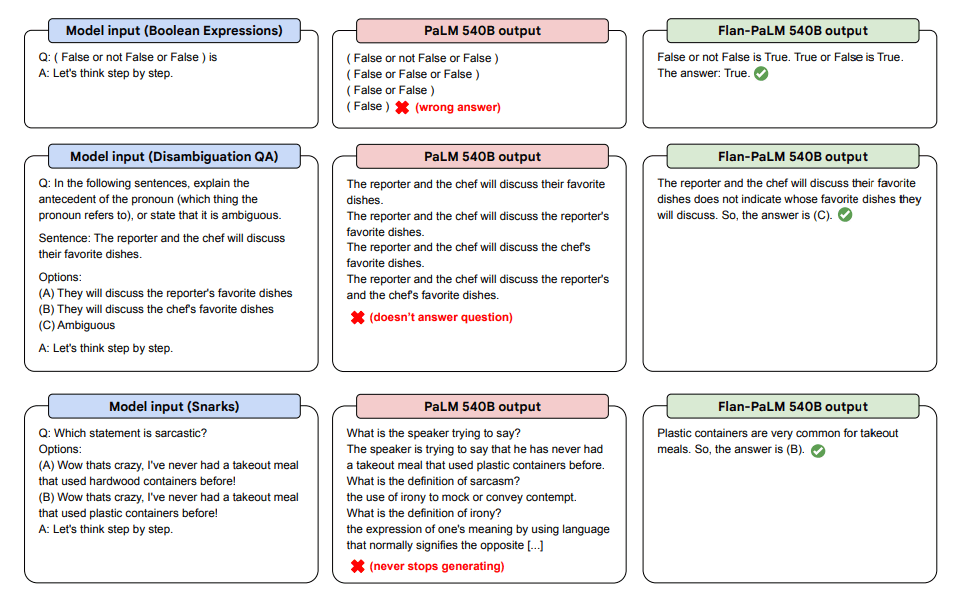

以下是一些关于PaLM和Flan-PaLM在未见任务中的零样本CoT的演示。

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

以下是零样本提示的更多示例。它展示了PaLM模型在零样本设置中如何处理重复和未回复指令的问题,而Flan-PaLM则能够表现良好。少量样本示例可以减轻这些错误。

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

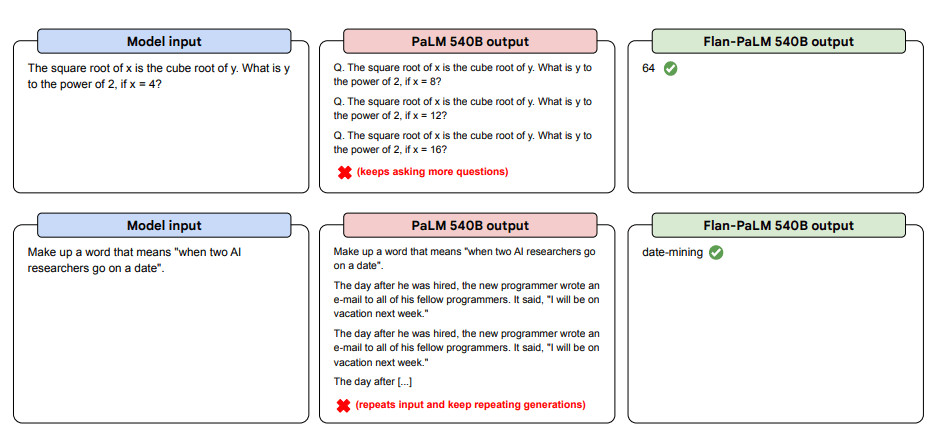

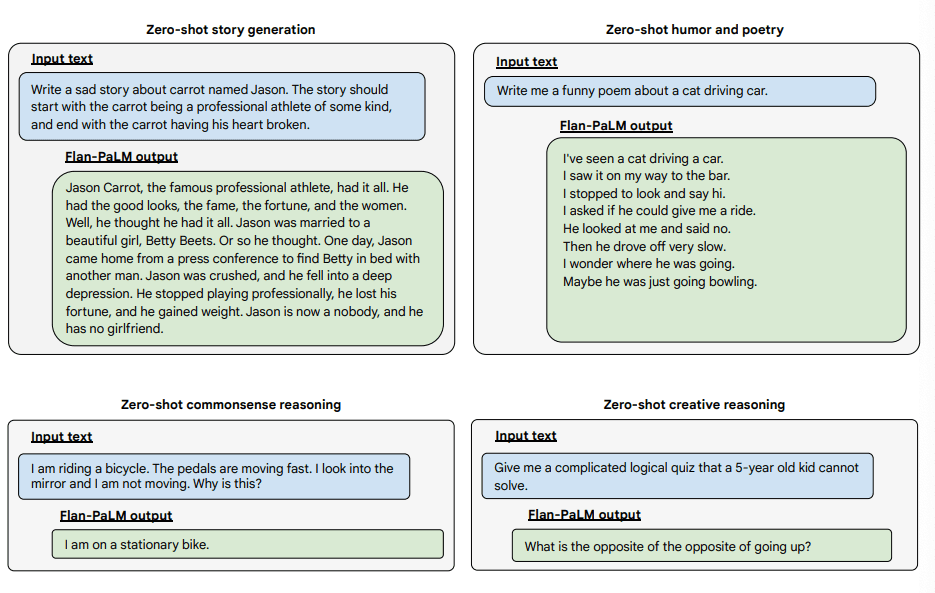

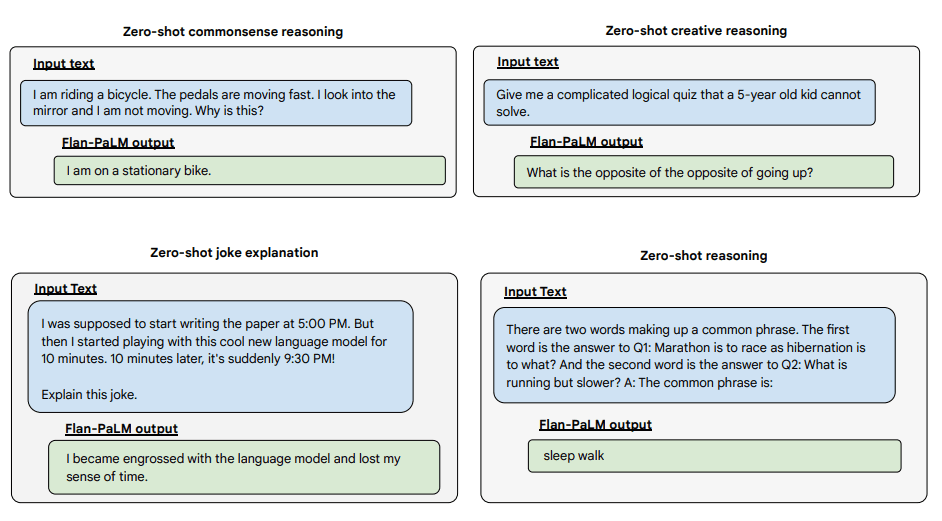

以下是一些示例,展示了Flan-PALM模型在几种不同类型的具有挑战性的开放式问题上的更多零样本能力:

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)

图片来源:Scaling Instruction-Finetuned Language Models(在新标签页中打开)