Grok-1

Grok-1 是一个拥有3140亿参数的专家混合(MoE)大型语言模型(LLM),其中包括基础模型权重和网络架构的公开发布。

Grok-1 由 xAI 训练,包含 MoE 模型,在推理时激活给定 token 的 25% 权重。Grok-1 的预训练截止日期为 2023 年 10 月。

正如官方公告 (在新标签页中打开)中所述,Grok-1 是预训练阶段的原始基础模型检查点,这意味着它尚未针对任何特定应用(如对话代理)进行微调。

该模型已在Apache 2.0许可证下发布 (在新标签页中打开)。

结果与能力

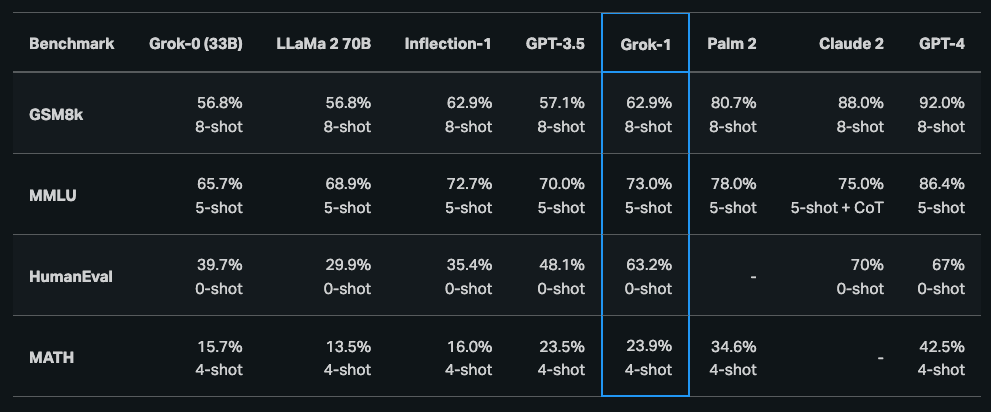

根据最初的公告 (在新标签页中打开),Grok-1在推理和编码任务中展示了强大的能力。最后公开的结果显示,Grok-1在HumanEval编码任务中达到了63.2%,在MMLU中达到了73%。它通常优于ChatGPT-3.5和Inflection-1,但仍然落后于改进的模型如GPT-4。

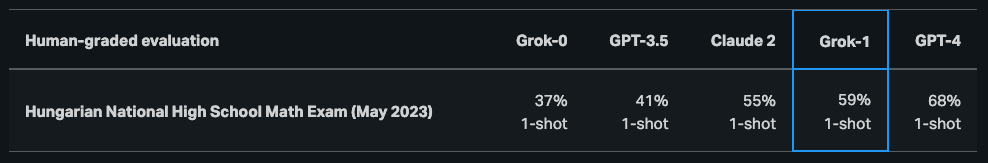

据报道,在匈牙利国家高中数学决赛中,Grok-1的得分为C(59%),而GPT-4的得分为B(68%)。

查看模型这里: https://github.com/xai-org/grok-1 (在新标签页中打开)

由于Grok-1的规模(314B参数),xAI建议使用多GPU机器来测试模型。