LM引导的思维链

一篇由Lee等人(2024年)(在新标签页中打开)发表的新论文提出使用小型语言模型来改进大型语言模型(LLMs)的推理能力。

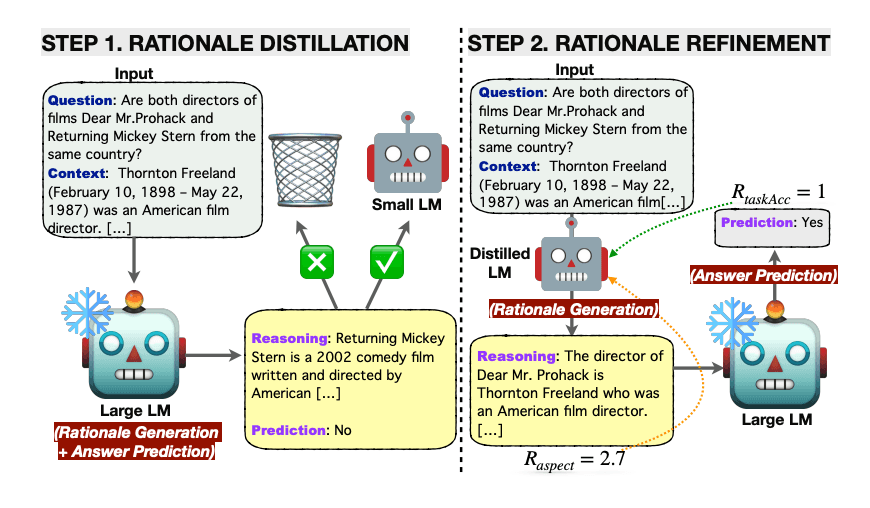

它首先将知识蒸馏应用于一个小型语言模型,利用大型语言模型生成的原理,以期缩小推理能力上的差距。

本质上,理由是由轻量级语言模型生成的,而答案预测则留给冻结的大型语言模型。这种资源高效的方法避免了微调大型模型的需要,而是将理由生成的任务卸载给小型语言模型。

知识蒸馏的语言模型通过使用多个理性导向和任务导向的奖励信号,进一步通过强化学习进行优化。

来源: https://arxiv.org/pdf/2404.03414.pdf (在新标签页中打开)

来源: https://arxiv.org/pdf/2404.03414.pdf (在新标签页中打开)

该框架在多跳抽取式问答上进行了测试,并在答案预测准确性方面优于所有基线。RL有助于提高生成理由的质量,从而进一步提高问答性能。

本文提出的LM引导的CoT提示方法优于标准提示和CoT提示。自一致性解码也提高了性能。

这种方法展示了小型语言模型在生成推理方面的巧妙应用。考虑到大型语言模型在这种能力上通常更受青睐,这些结果显得尤为显著。开发者应该深入思考以这种方式分解任务。并非所有事情都需要由大型模型来完成。在微调时,思考你想要优化的具体方面并测试小型语言模型是否能为你完成这些任务是非常有用的。