什么是Groq?

Groq (在新标签页中打开) 最近作为当今最快的LLM推理解决方案之一,成为了许多头条新闻。LLM从业者对减少LLM响应延迟非常感兴趣。延迟是优化和实现实时AI应用的重要指标。现在有许多公司在这一领域围绕LLM推理展开竞争。

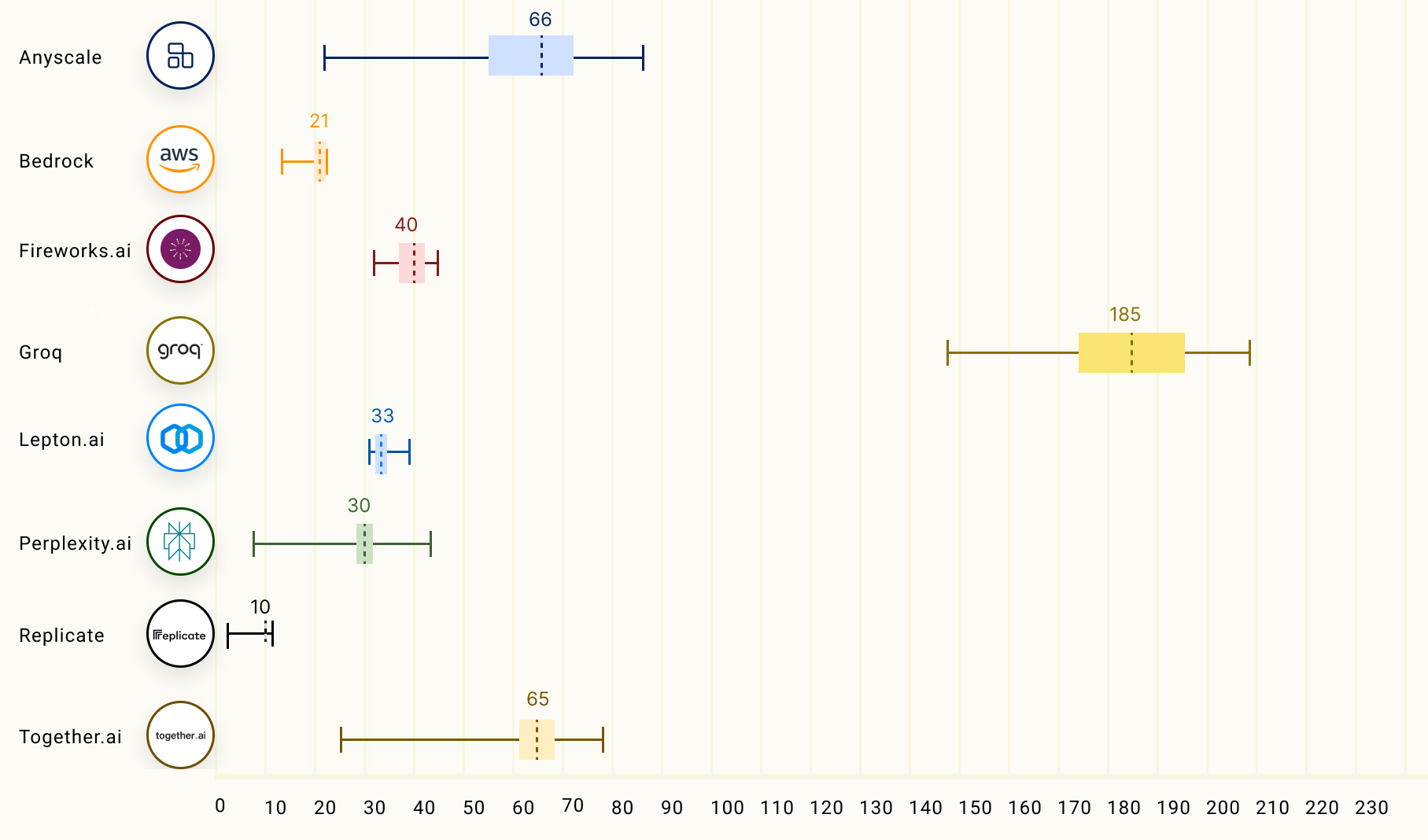

Groq 是那些声称在撰写本文时,在 Anyscale 的 LLMPerf 排行榜(在新标签页中打开) 上推理性能比其他顶级云服务提供商快 18 倍的 LLM 推理公司之一。Groq 目前通过其 API 提供 Meta AI 的 Llama 2 70B 和 Mixtral 8x7B 等模型。这些模型由 Groq LPU™ 推理引擎驱动,该引擎采用他们自己定制的硬件设计,用于运行称为语言处理单元(LPUs)的 LLM。

根据Groq的常见问题解答,LPU有助于减少每个单词的计算时间,从而加快文本序列的生成速度。您可以在他们获得ISCA奖项的2020(在新标签页中打开)和2022(在新标签页中打开)论文中阅读更多关于LPU技术细节及其优势的信息。

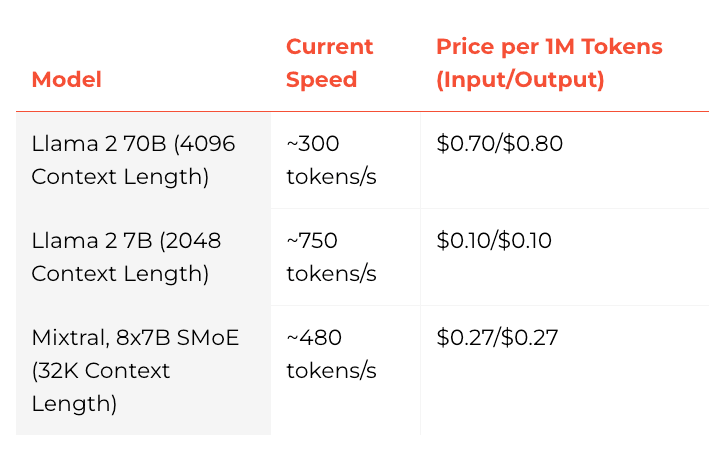

以下是他们模型的速度和价格图表:

下图比较了输出令牌吞吐量(tokens/s),即每秒返回的平均输出令牌数。图表中的数字对应于Llama 2 70B模型上LLM推理提供商的平均输出令牌吞吐量(基于150个请求)。

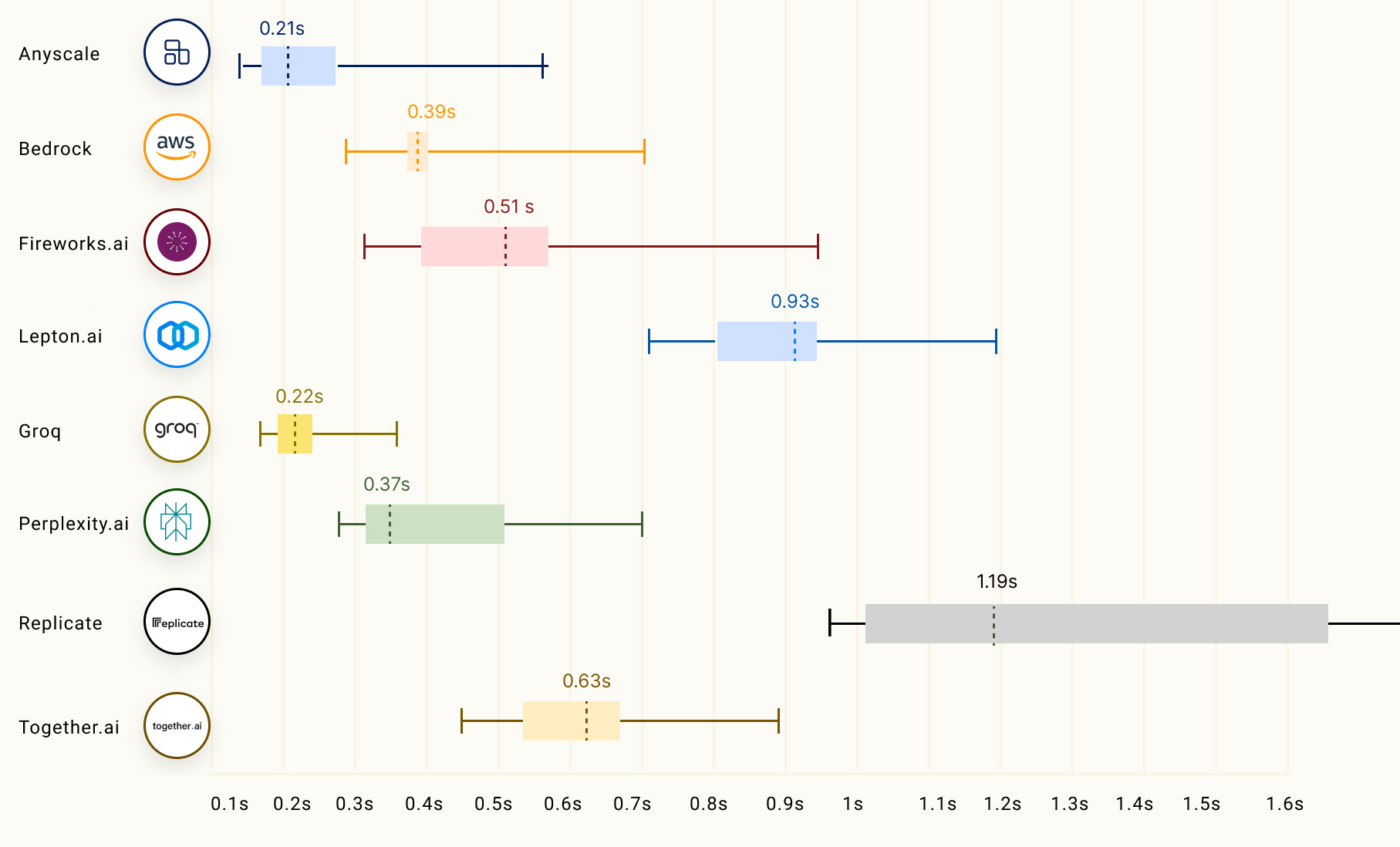

LLM推理的另一个重要因素,特别是对于流式应用,被称为首次令牌时间(TTFT),它对应于LLM返回第一个令牌的时间长度。下图展示了不同LLM推理提供商的性能表现:

你可以在Anyscale的LLMPerf排行榜上阅读更多关于Groq的LLM推理性能的信息这里(在新标签页中打开)。