LLaMA: 开放且高效的基础语言模型

⚠️

本节正在大力开发中。

有什么新内容?

本文介绍了一系列基础语言模型,参数范围从7B到65B。

模型是在使用公开可用数据集的数万亿个标记上进行训练的。

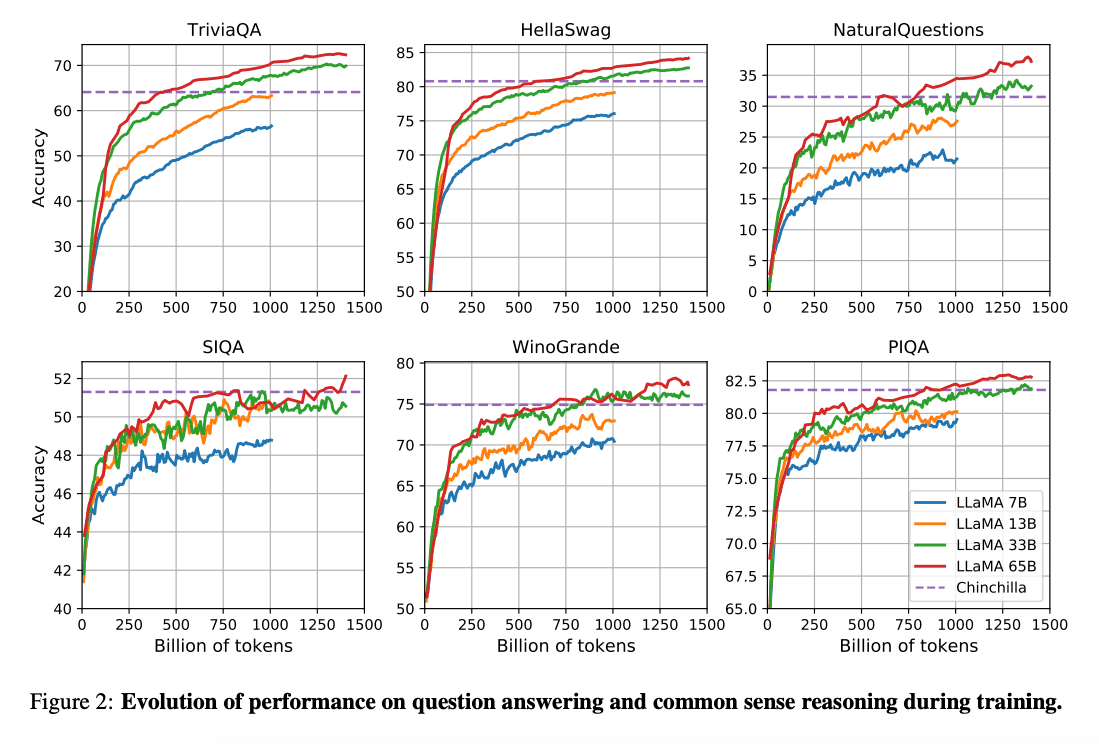

由(Hoffman et al. 2022) (在新标签页中打开)进行的研究表明,在给定的计算预算下,使用更多数据训练的较小模型可以比更大的模型获得更好的性能。这项研究建议在200B tokens上训练10B模型。然而,LLaMA论文发现,即使在1T tokens之后,7B模型的性能仍在继续提高。

这项工作的重点是通过训练更多的标记来训练模型(LLaMA),以在各种推理预算下实现最佳性能。

能力与关键成果

总体而言,LLaMA-13B 在许多基准测试中优于 GPT-3(175B),尽管它小了 10 倍并且可以在单个 GPU 上运行。LLaMA 65B 与 Chinchilla-70B 和 PaLM-540B 等模型具有竞争力。

论文: LLaMA: 开放且高效的基础语言模型 (在新标签页中打开)

代码: https://github.com/facebookresearch/llama (在新标签页中打开)

参考文献

- Koala: 学术研究的对话模型 (在新标签页中打开) (2023年4月)

- Baize: 一种在自我对话数据上进行参数高效调优的开源聊天模型 (在新标签页中打开) (2023年4月)

- Vicuna: 一个开源聊天机器人,以90%* ChatGPT质量给GPT-4留下深刻印象 (在新标签页中打开) (2023年3月)

- LLaMA-Adapter: 使用零初始化注意力高效微调语言模型 (在新标签页中打开) (2023年3月)

- GPT4All (在新标签页中打开) (2023年3月)

- ChatDoctor: 基于LLaMA模型使用医学领域知识微调的医疗聊天模型 (在新标签页中打开) (2023年3月)

- Stanford Alpaca (在新标签页中打开) (2023年3月)