LLM推理

在过去的几年里,大型语言模型(LLMs)在广泛的任务中取得了显著进展。最近,LLMs在扩展到足够大的规模时,显示出具备推理能力的潜力。不同类型的推理是智能的基础,但人们尚未完全理解AI模型如何学习和利用这种能力来解决复杂问题。这是许多研究实验室高度关注和大量投资的领域。

基于基础模型的推理

Sun et al. (2023) (在新标签页中打开) 最近提出了一个关于基础模型推理的概述,重点关注各种推理任务的最新进展。这项工作还更广泛地探讨了跨模态模型和自主语言代理的推理。

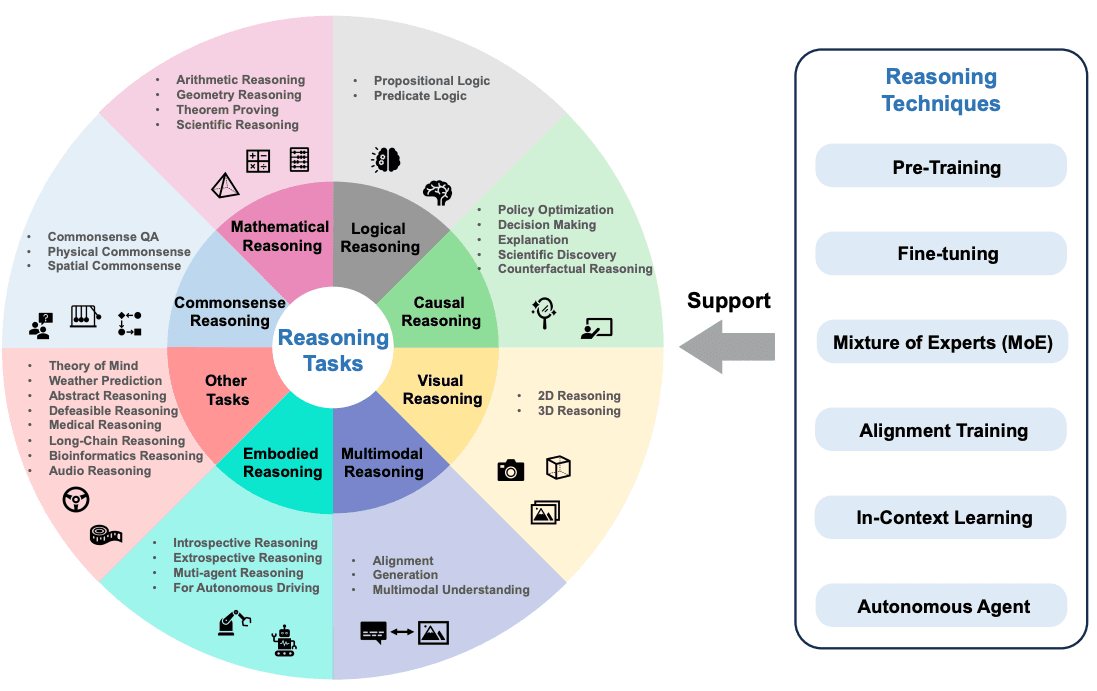

推理任务可能包括数学推理、逻辑推理、因果推理、视觉推理等任务。下图展示了调查论文中讨论的推理任务概览,包括基础模型的推理技术,如对齐训练和上下文学习。

图源: Sun et al., 2023 (在新标签页中打开)

图源: Sun et al., 2023 (在新标签页中打开)

如何在LLMs中引发推理?

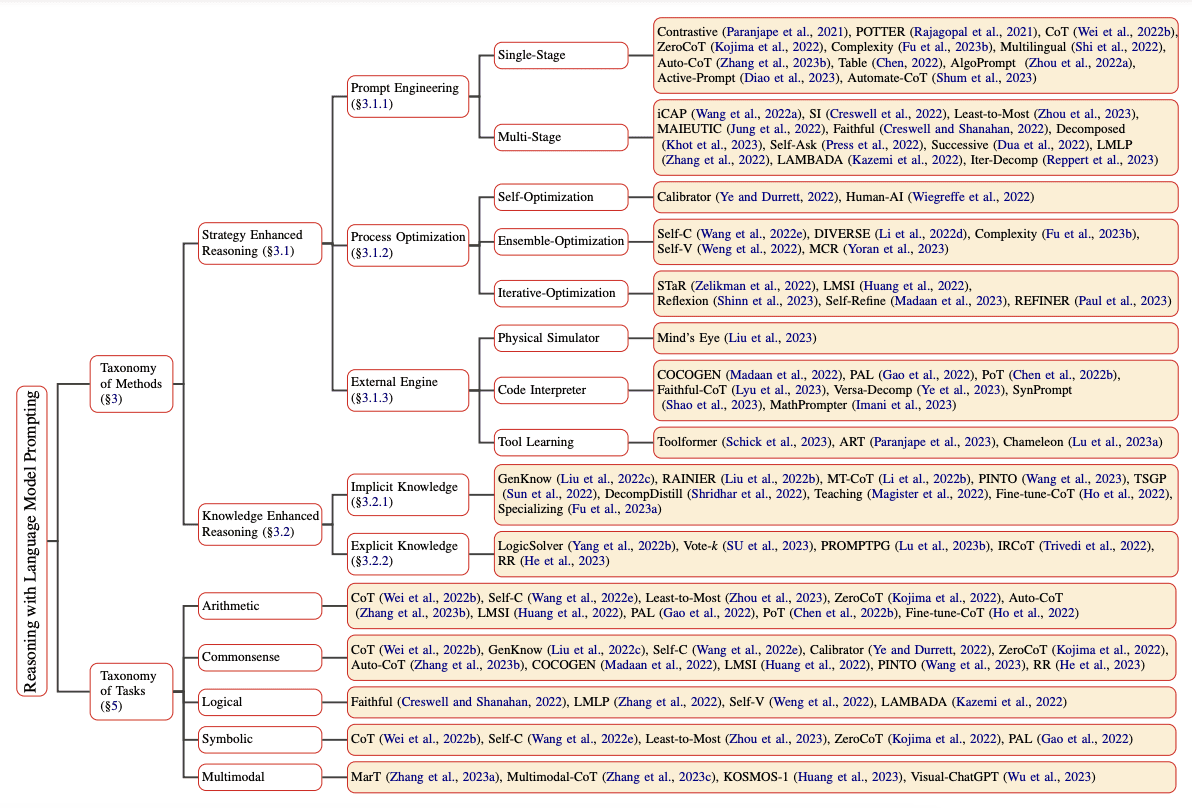

在大型语言模型(LLMs)中,可以通过多种不同的提示方法来引发和增强推理能力。Qiao et al. (2023) (在新标签页中打开) 将推理方法研究分为两个不同的分支,即推理增强策略和知识增强推理。推理策略包括提示工程、过程优化和外部引擎。例如,单阶段提示策略包括思维链 (在新标签页中打开)和主动提示 (在新标签页中打开)。关于语言模型提示的完整推理分类可以在论文中找到,并在下图中总结:

图源: Qiao et al., 2023 (在新标签页中打开)

图源: Qiao et al., 2023 (在新标签页中打开)

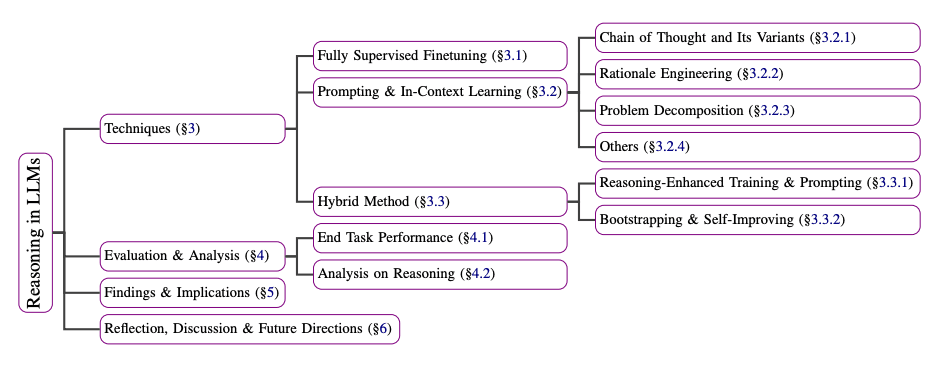

Huang et al. (2023) 还解释了改进或激发大型语言模型(如GPT-3)推理能力的技术总结。这些技术包括使用在解释数据集上训练的完全监督微调模型,以及提示方法,如思维链、问题分解和上下文学习。以下是论文中描述的技术总结:

图源: Huang et al., 2023 (在新标签页中打开)

图源: Huang et al., 2023 (在新标签页中打开)

LLMs 能否推理和规划?

关于LLMs是否能够进行推理和规划存在很多争论。推理和规划是解锁LLMs在机器人和自主代理等领域复杂应用的重要能力。Subbarao Kambhampati (2024)的一篇立场论文 (在新标签页中打开) 讨论了LLMs的推理和规划主题。

以下是作者结论的总结:

总结来说,我所阅读、验证或进行的任何内容都没有给我任何令人信服的理由,让我相信大型语言模型(LLMs)能够进行通常意义上的推理/规划。相反,它们通过大规模的网页训练,进行了一种通用的近似检索,正如我所论证的,这种检索有时可能会被误认为是推理能力。