Note

Go to the end to download the full example code. or to run this example in your browser via Binder

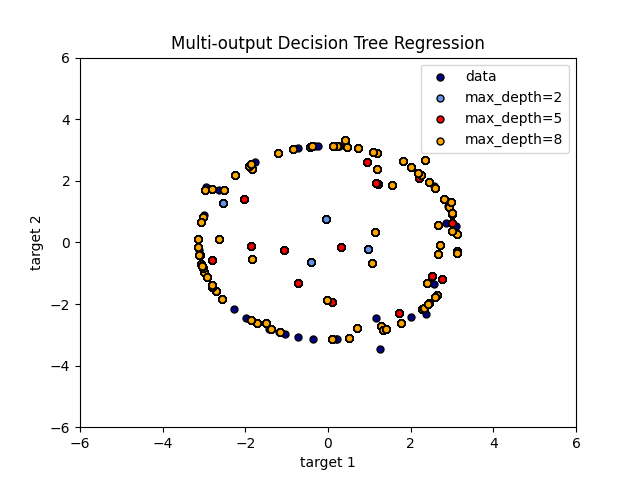

多输出决策树回归#

一个使用决策树进行多输出回归的示例。

使用 决策树 同时预测圆的噪声 x 和 y 观测值, 给定一个单一的潜在特征。结果是,它学习了近似圆的局部线性回归。

我们可以看到,如果树的最大深度(由 max_depth 参数控制)设置得太高,

决策树会学习训练数据的过细细节并从噪声中学习,即它们会过拟合。

import matplotlib.pyplot as plt

import numpy as np

from sklearn.tree import DecisionTreeRegressor

# 创建一个随机数据集

rng = np.random.RandomState(1)

X = np.sort(200 * rng.rand(100, 1) - 100, axis=0)

y = np.array([np.pi * np.sin(X).ravel(), np.pi * np.cos(X).ravel()]).T

y[::5, :] += 0.5 - rng.rand(20, 2)

# 拟合回归模型

regr_1 = DecisionTreeRegressor(max_depth=2)

regr_2 = DecisionTreeRegressor(max_depth=5)

regr_3 = DecisionTreeRegressor(max_depth=8)

regr_1.fit(X, y)

regr_2.fit(X, y)

regr_3.fit(X, y)

# Predict

X_test = np.arange(-100.0, 100.0, 0.01)[:, np.newaxis]

y_1 = regr_1.predict(X_test)

y_2 = regr_2.predict(X_test)

y_3 = regr_3.predict(X_test)

# 绘制结果

plt.figure()

s = 25

plt.scatter(y[:, 0], y[:, 1], c="navy", s=s, edgecolor="black", label="data")

plt.scatter(

y_1[:, 0],

y_1[:, 1],

c="cornflowerblue",

s=s,

edgecolor="black",

label="max_depth=2",

)

plt.scatter(y_2[:, 0], y_2[:, 1], c="red", s=s, edgecolor="black", label="max_depth=5")

plt.scatter(

y_3[:, 0], y_3[:, 1], c="orange", s=s, edgecolor="black", label="max_depth=8"

)

plt.xlim([-6, 6])

plt.ylim([-6, 6])

plt.xlabel("target 1")

plt.ylabel("target 2")

plt.title("Multi-output Decision Tree Regression")

plt.legend(loc="best")

plt.show()

Total running time of the script: (0 minutes 0.117 seconds)

Related examples